はじめに!

Author:Anda Toshiki

Updated:3 months ago

Words:34.3k

Reading:141 min

本書の目的・内容

本書は,東京大学計数工学科で 2021 年度 S1/S2 タームに開講されている"システム情報工学特論"の講義資料として作成された.

本書の目的は,クラウドの初心者を対象とし,クラウドの基礎的な知識・概念を解説する. また, Amazon Web Services (以下, AWS) の提供するクラウド環境を実例として,具体的なクラウドの利用方法をハンズオンを通して学ぶ.

とくに,科学・エンジニアリングの学生を対象として,研究などの目的でクラウドを利用するための実践的な手順を紹介する. 知識・理論の説明は最小限に留め,実践を行う中で必要な概念の解説を行う予定である. 読者が今後,研究などでクラウドを利用する際の,足がかりとなれば本書の目的は十分達成されたことになる.

本書は以下のような三部構成になっている.

| テーマ | ハンズオン | |

|---|---|---|

第一部 (1章-4章) | クラウドの基礎 |

|

第二部 (5章-9章) | クラウドを活用した機械学習 |

|

第三部 (10章-13章) | サーバーレスアーキテクチャ入門 |

|

第一部は,クラウドの基礎となる概念・知識を解説する. セキュリティやネットワークなど,クラウドを利用する上で最低限おさえなければいけないポイントを説明する. ハンズオンでは,はじめての仮想サーバーを AWS に立ち上げる演習を行う.

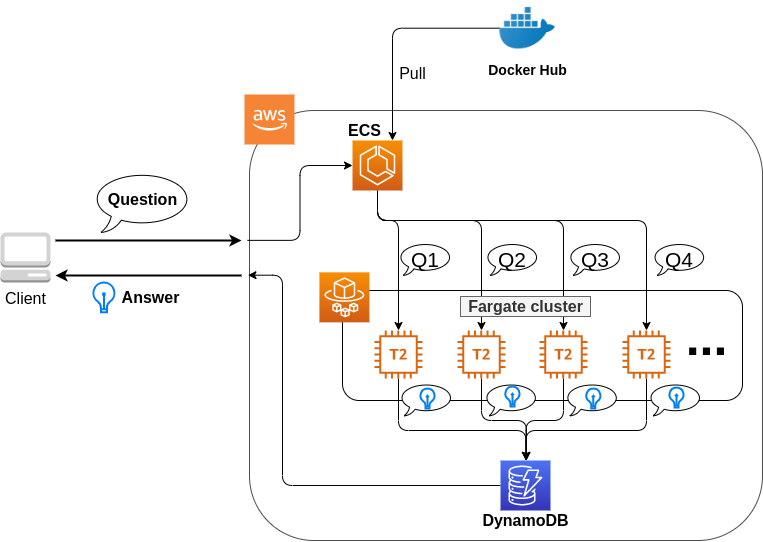

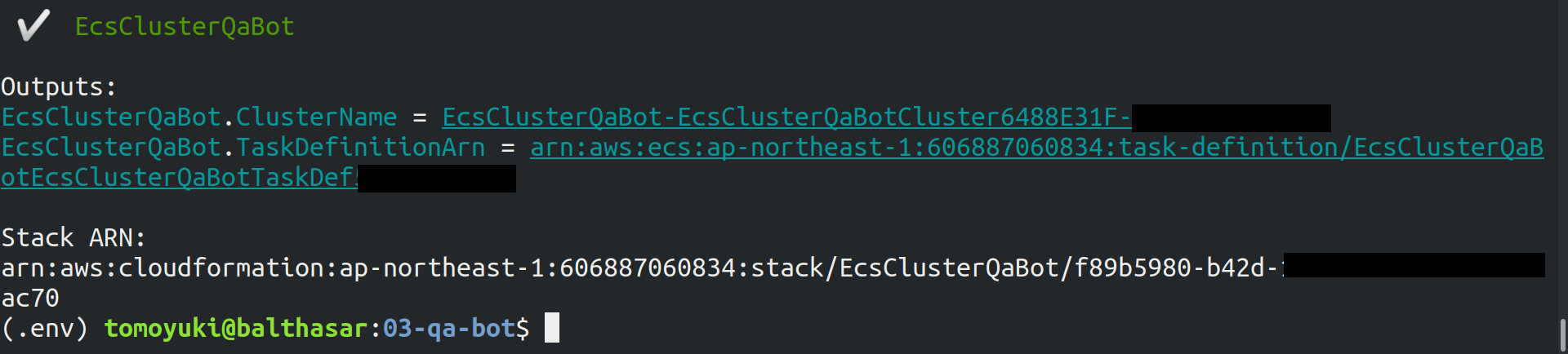

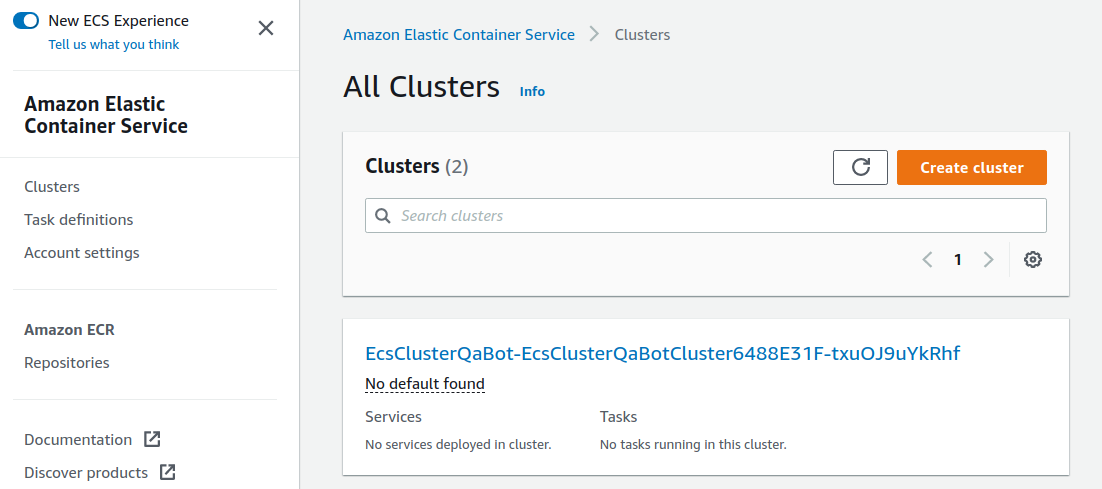

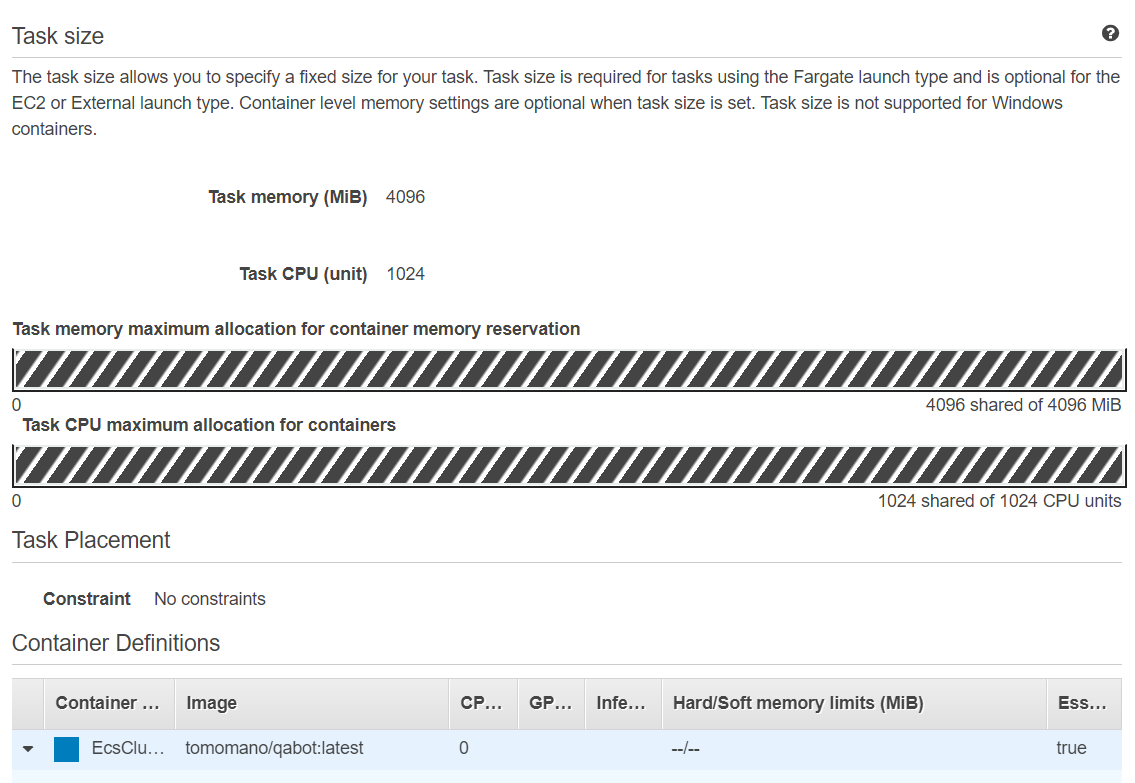

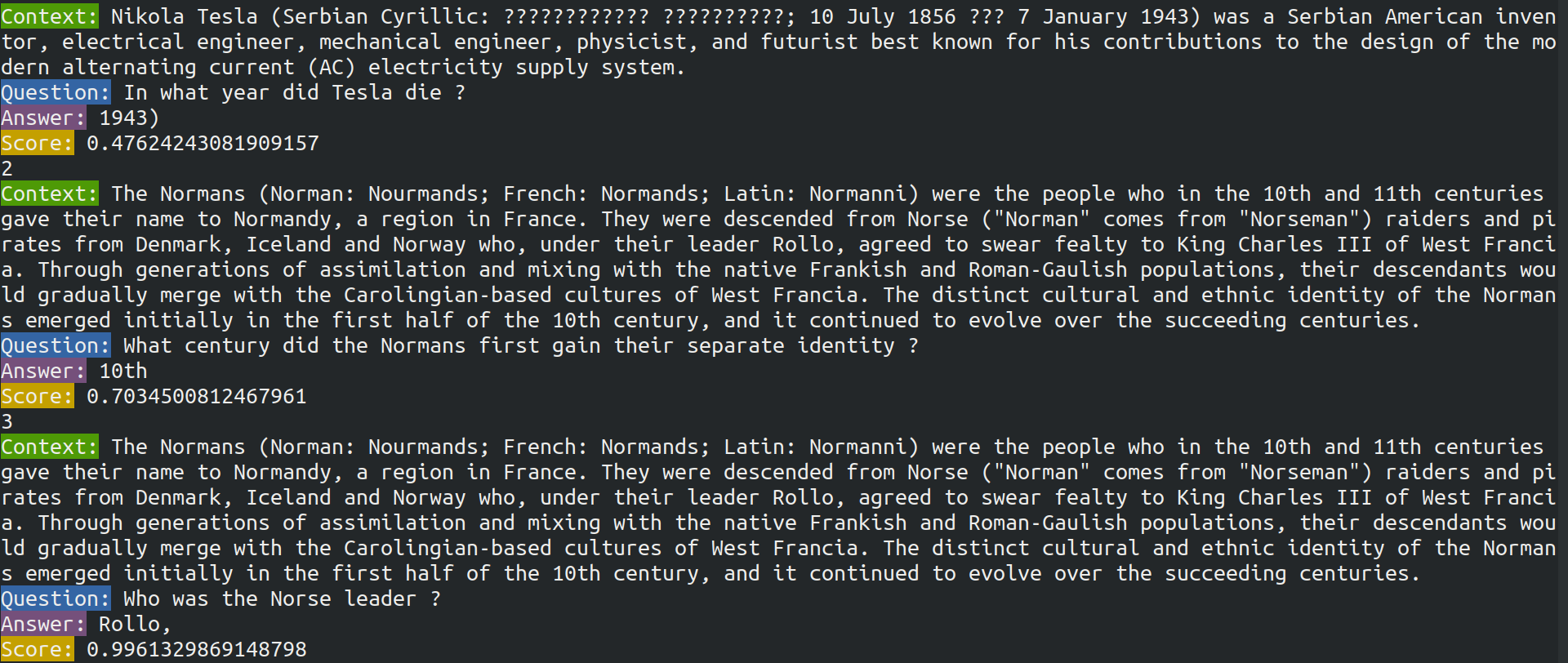

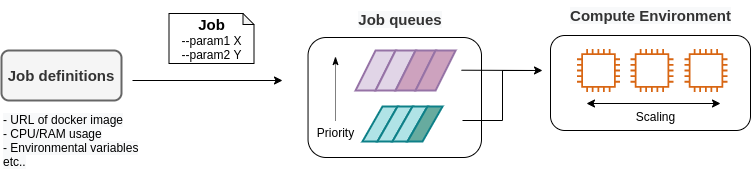

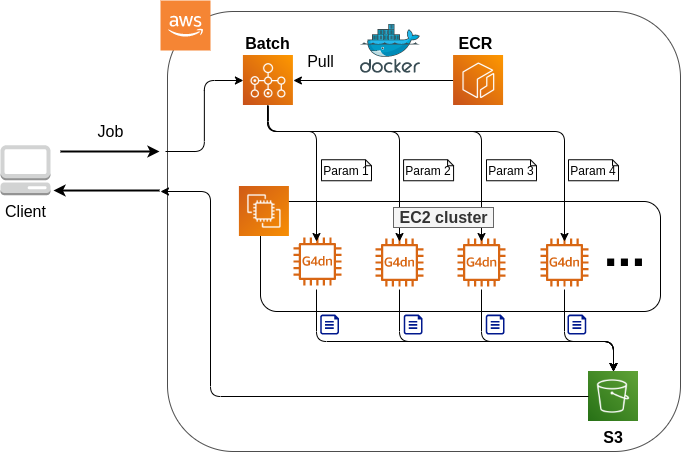

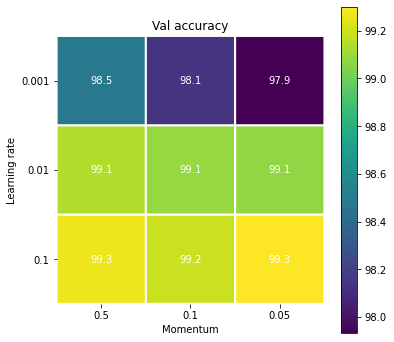

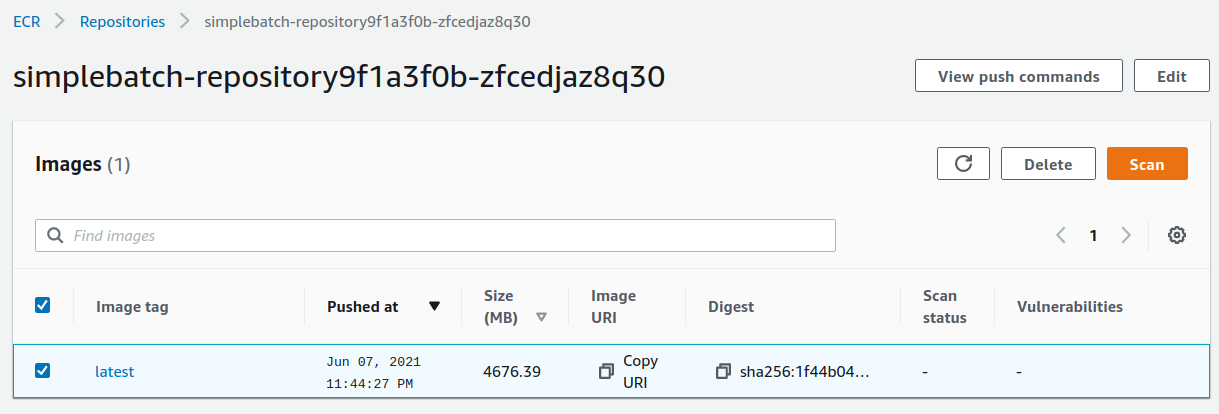

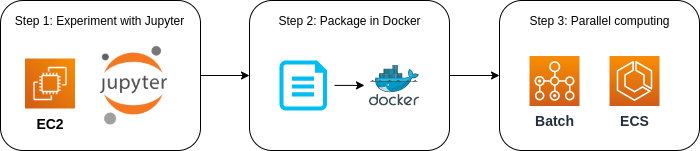

第二部では,クラウド上で科学計算 (とくに機械学習) を走らせるための入門となる知識・技術を解説する. あわせて, Docker とよばれる仮想計算環境の使用方法を紹介する. 一つ目のハンズオンでは, AWS のクラウドで Jupyter Notebook を起動し簡単な機械学習の計算を走らせる課題を実践する. 二つ目のハンズオンでは,深層学習を用いた自然言語処理により,質問に自動で回答を生成するボットを作成する. 最後に,複数台の GPU インスタンスからなるクラスターを起動し,並列に深層学習のハイパーパラメータサーチを行う方法を紹介する.

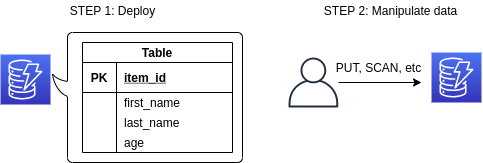

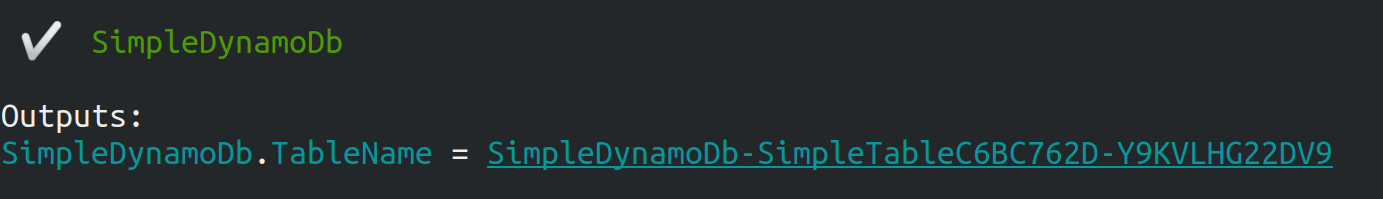

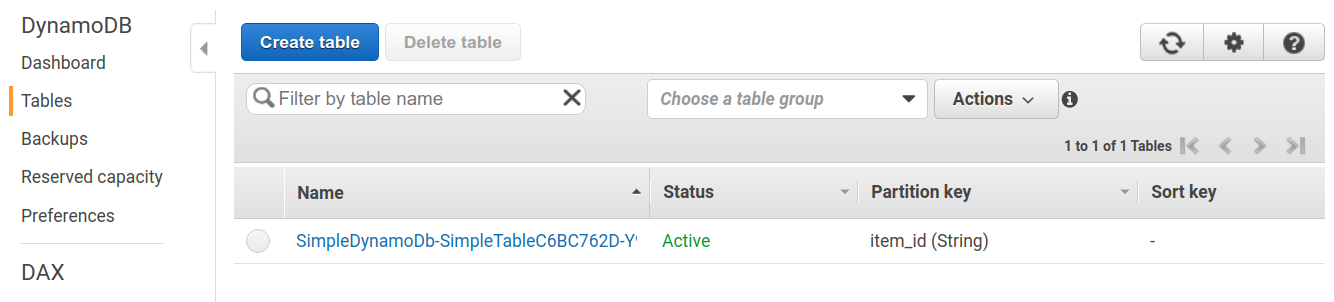

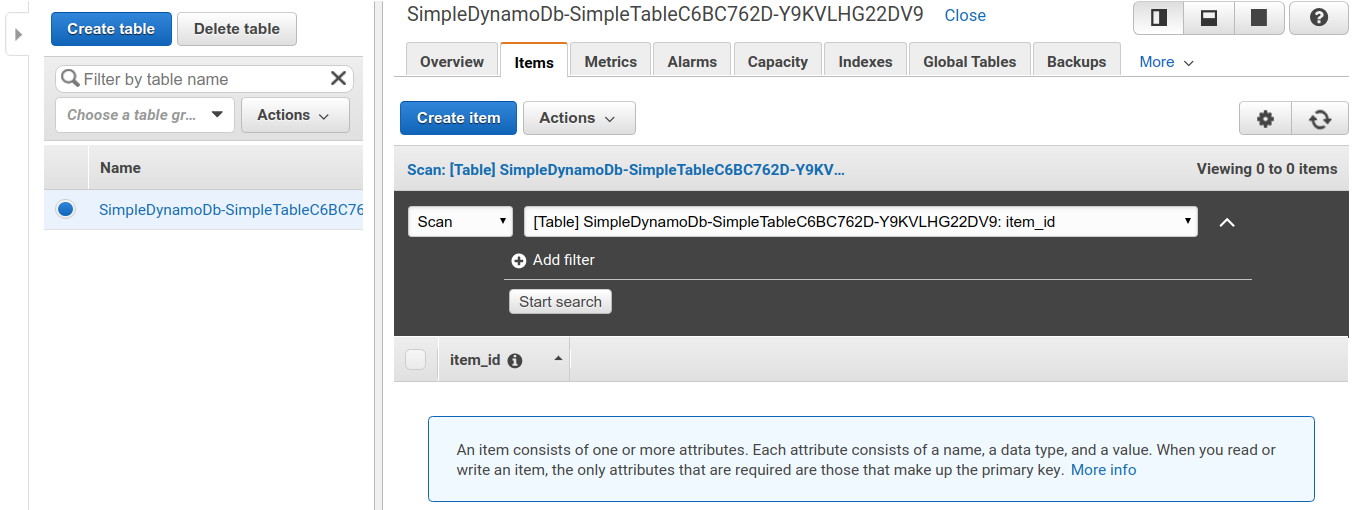

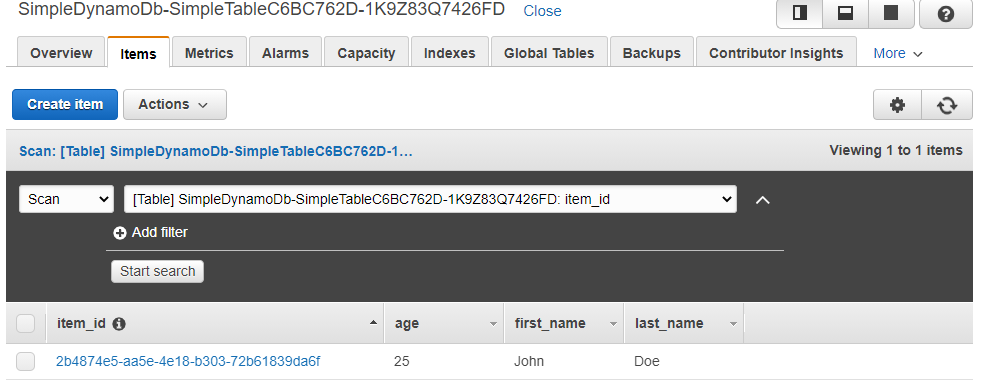

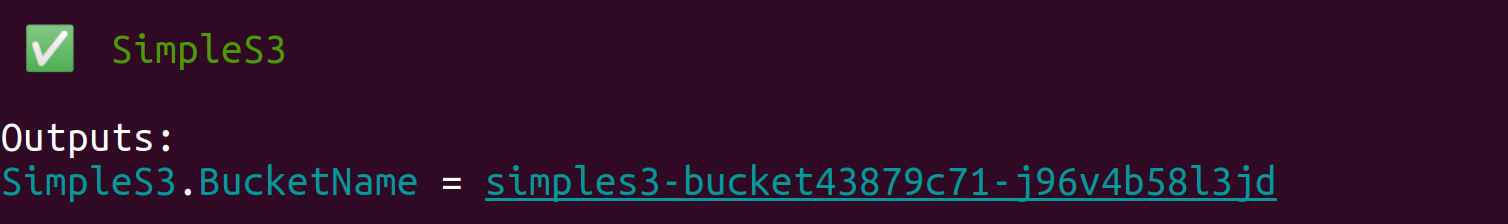

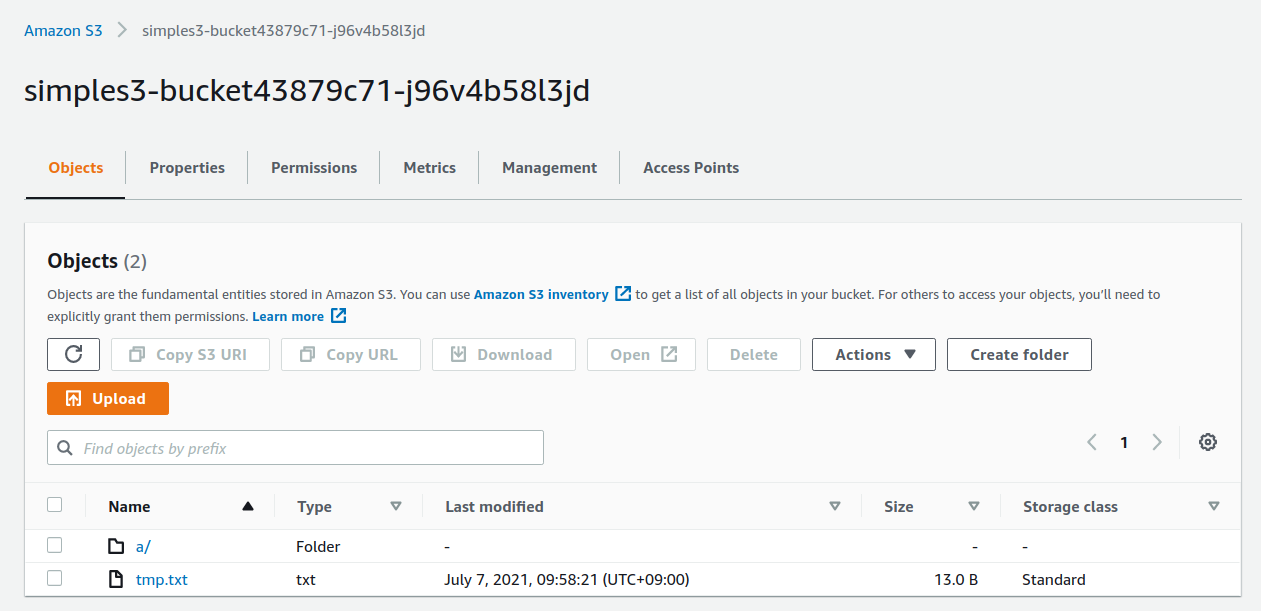

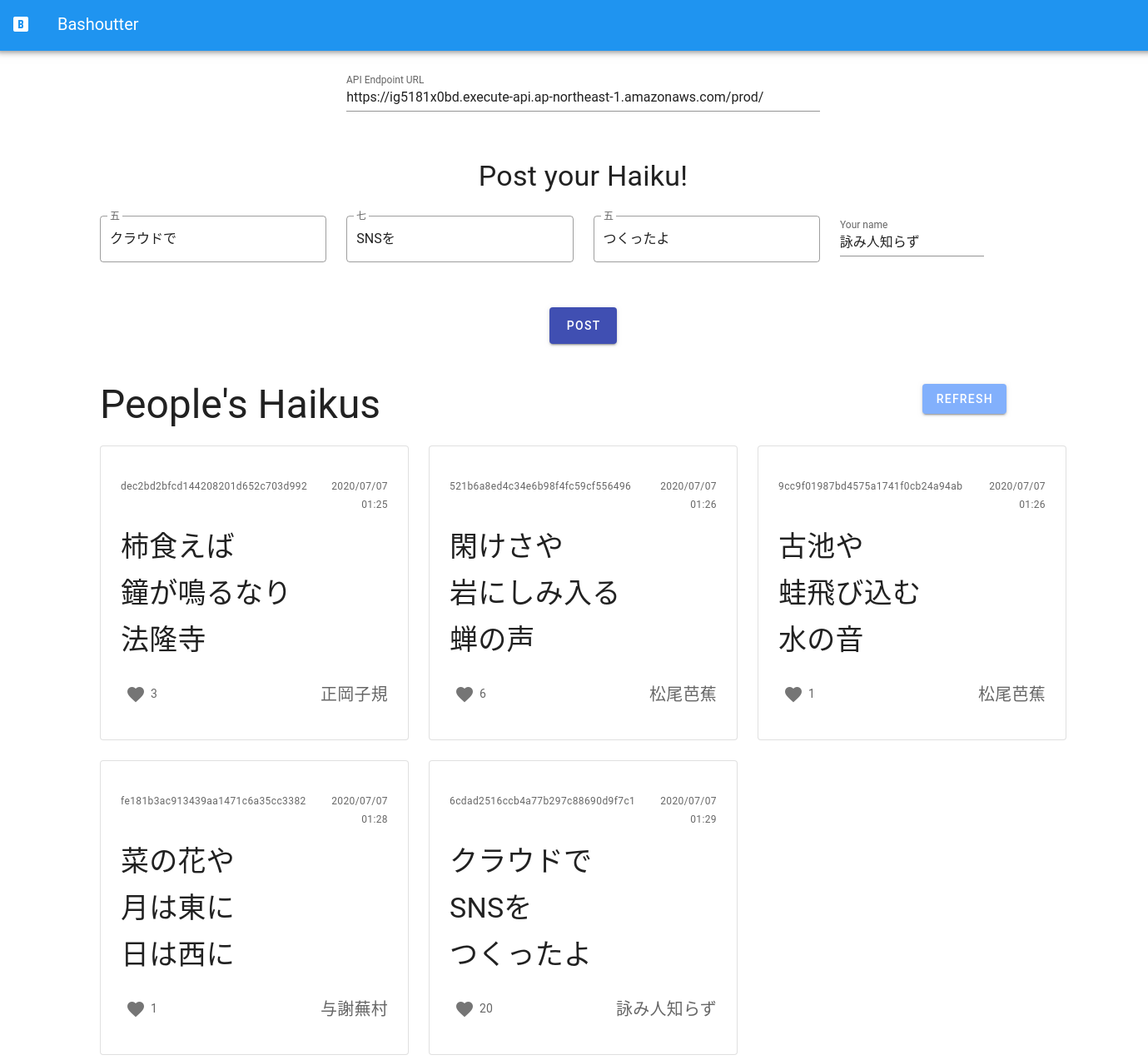

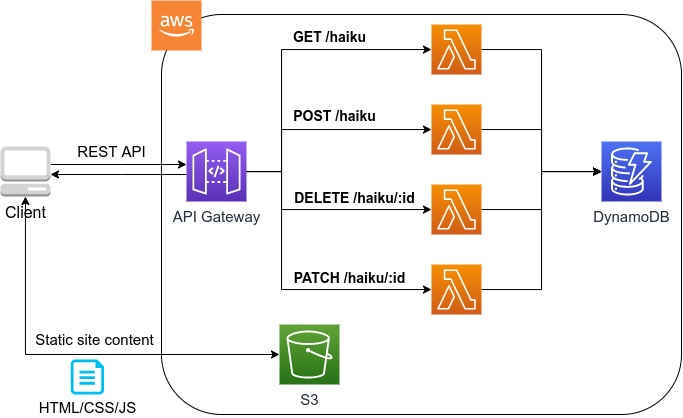

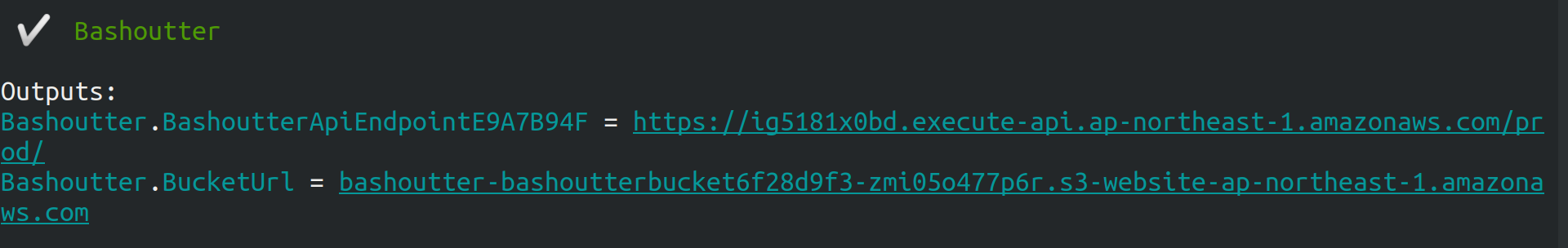

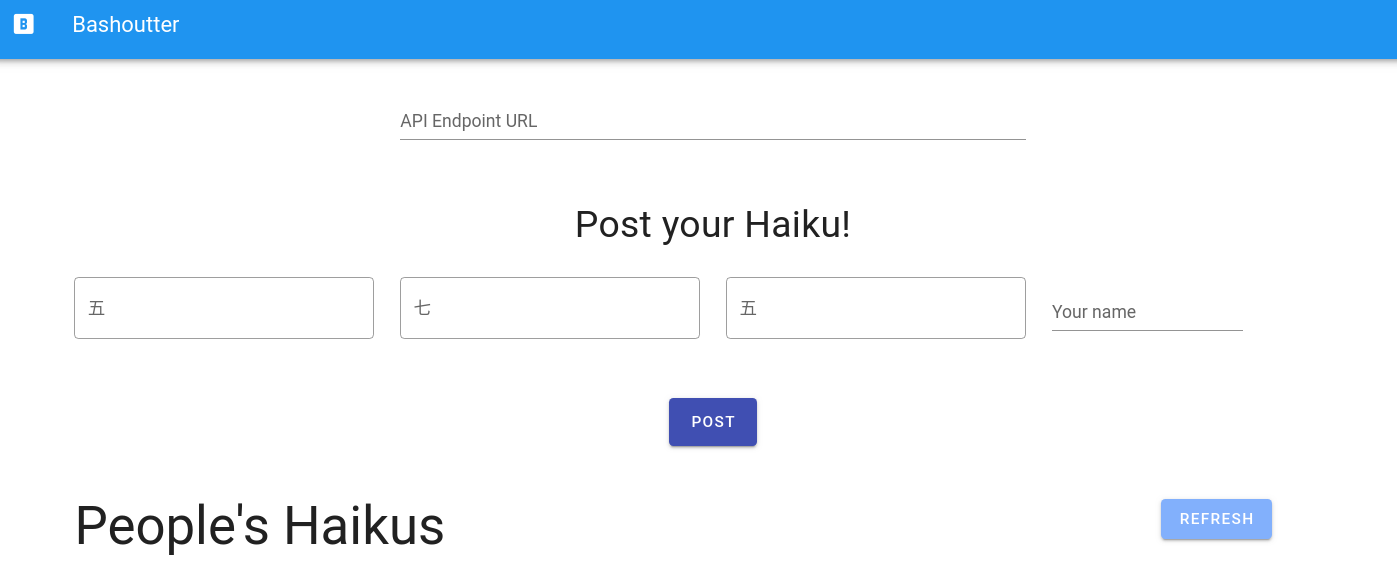

第三部では,サーバーレスアーキテクチャとよばれる最新のクラウドのアーキテクチャを紹介する. これは,サーバーの処理能力を負荷に応じてより柔軟に拡大・縮小するための概念であり,それ以前 (Serverful としばしばよばれる) と質的に異なる設計思想をクラウドに導入するものである. ハンズオンでは,サーバーレスクラウドの主要なコンポーネントである Lambda, DynamoDB, S3 の演習を提供する. さらに,サーバーレスの技術を使用して簡単な SNS をクラウド上に作成する.

これらの豊富なハンズオンにより, AWS 上にクラウドシステムを開発するための知識と技術が身につくはずである. いずれのハンズオンも,実用性を重視したものになっており,これらをベースにカスタマイズを施すことで様々な応用が可能である.

本書のフィロソフィー

本書のフィロソフィーを一言で表すなら, "ロケットで宇宙まで飛んでいって一度地球を眺めてみよう!" である.

どういうことか?

ここでいう"地球"とは,クラウドコンピューティングの全体像のことである. 言うまでもなく,クラウドという技術は非常に広範かつ複雑な概念で,幾多の情報技術・ハードウェア・アルゴリズムが精緻に組み合わさってできた総体である. そして,今日では科学研究から日常のインフラ設備に至るまで,我々の社会の多くの部分がクラウド技術によって支えられている.

ここでいう"ロケット"とはこの講義のことである. この講義では,ロケットに乗って宇宙まで飛び立ち,地球(クラウド)の全体を自身の目で眺めてもらう. その際,ロケットの成り立ちや仕組み (背後にある要素技術やプログラムのソースコード) を深くは問わない. 将来,自分が研究などの目的でクラウドを利用することになった際に,改めて学んでもらえば良い. 本書の目的はむしろ,クラウドの最先端に実際に触れ,そこからどんな景色が見えるか(どんな応用が可能か)を実感してもらうことである.

そのような理由で,本書はクラウドの基礎から応用まで幅広いテーマを取り扱う. 第一部はクラウドの基礎から始め,第二部では一気にレベルアップし機械学習(深層学習)をクラウドで実行する手法を解説する. さらに第三部では,サーバーレス・アーキテクチャというここ数年のうちに確立した全く新しいクラウドの設計について解説する. それぞれで本一冊分以上の内容に相当するものであるが,本書はあえてこれらを一冊にまとめ連続的に俯瞰するという野心的な意図をもって執筆された.

決して楽な搭乗体験ではないかもしれないが,このロケットにしがみついてきてもらえれば,とてもエキサイティングな景色が見られることを約束したい.

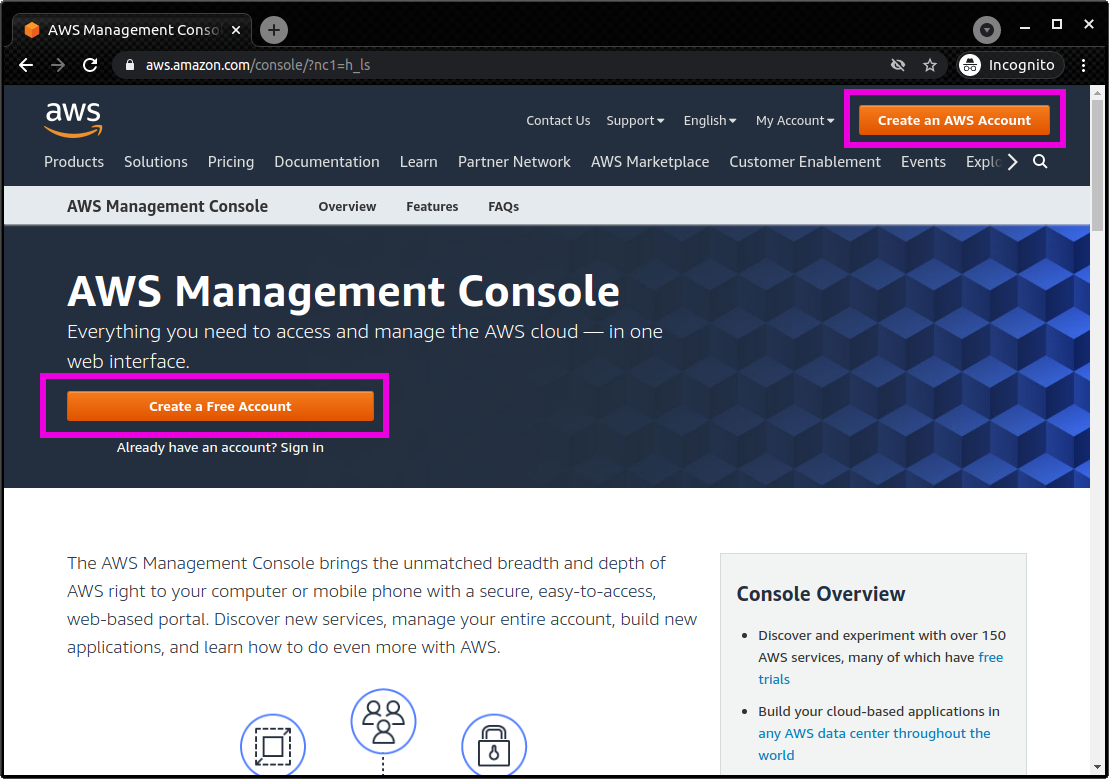

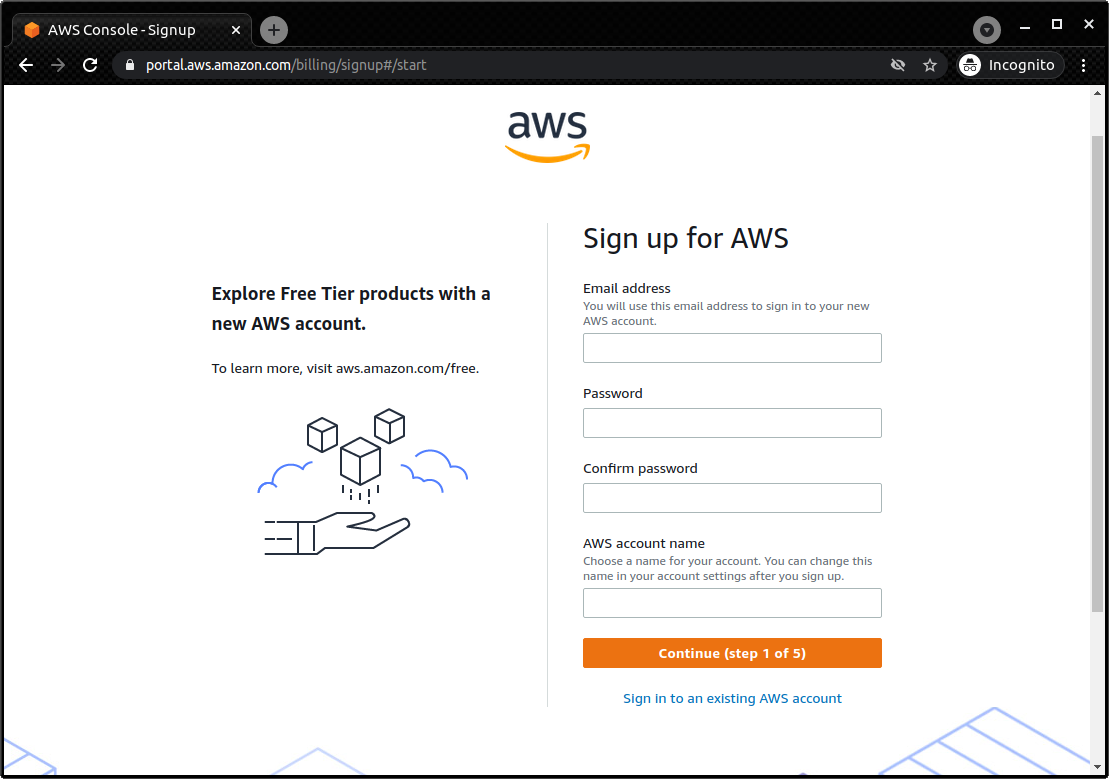

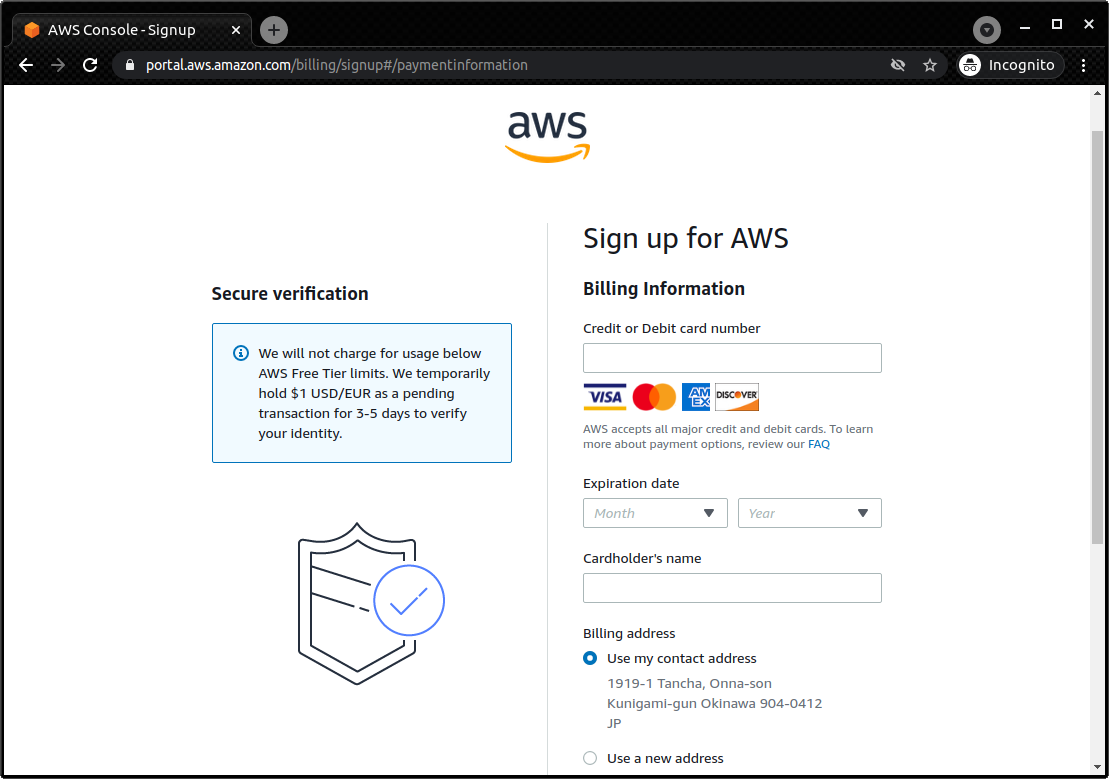

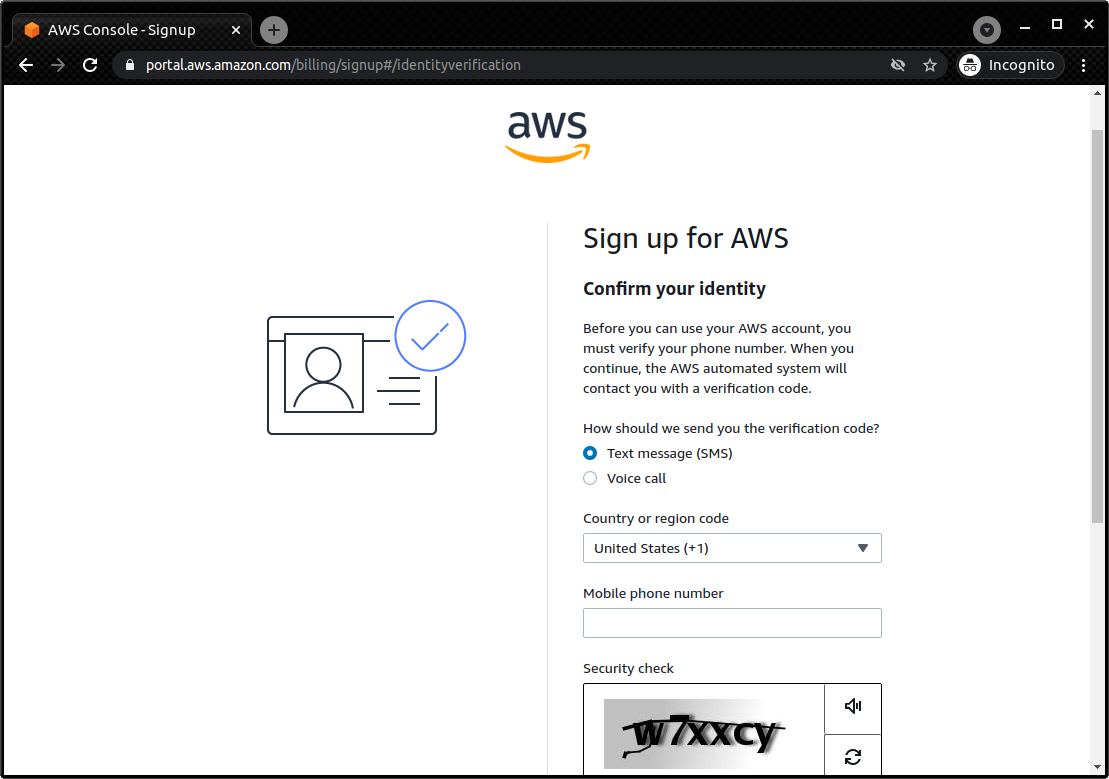

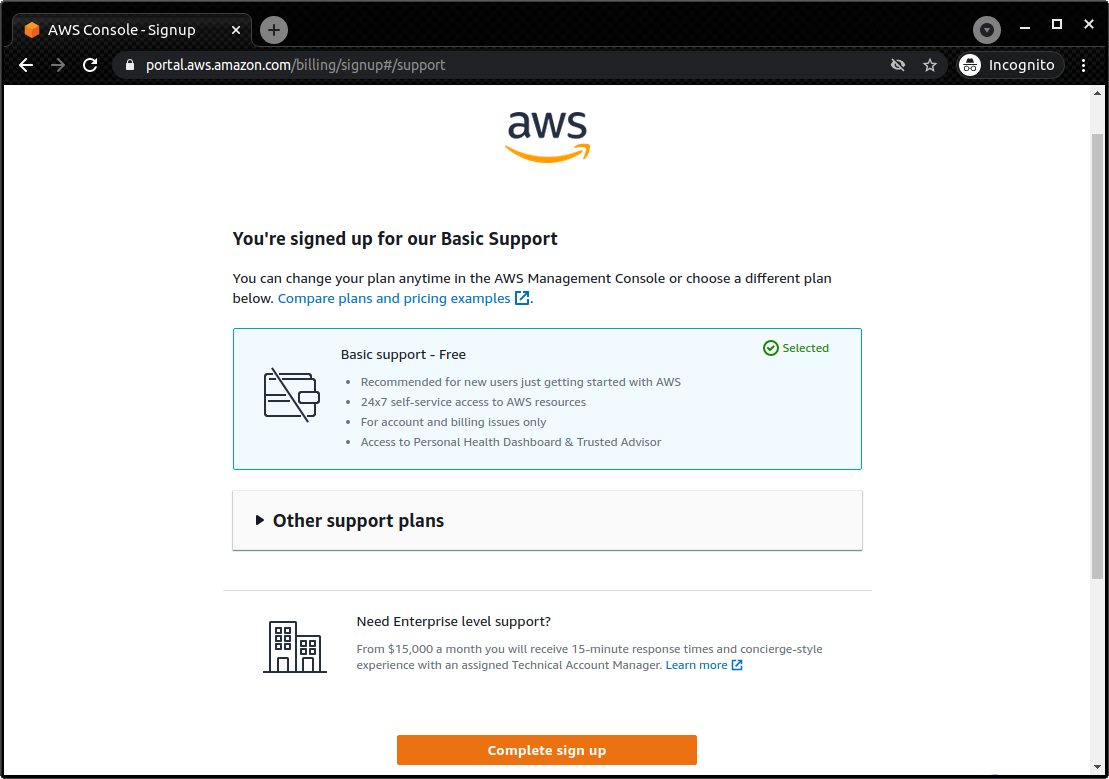

AWS アカウント

本書では,ハンズオン形式で AWS のクラウドを実際に動かす演習を提供する. 自分でハンズオンを実行してみたい読者は,各自で AWS のアカウントの作成をしていただく. AWS のアカウントの作成の仕方は巻末付録 (AWS アカウントの取得) に簡単に記載したので,必要に応じて参照していただきたい.

AWS にはいくつかの機能に対して無料利用枠が設定されており,いくつかのハンズオンは無料の範囲内で実行できる. 一方,ほかのハンズオン (とくに機械学習を扱うもの) では数ドル程度のコストが発生する. ハンズオンごとに発生するおおよそのコストについて記述があるので,注意をしながらハンズオンに取り組んでいただきたい.

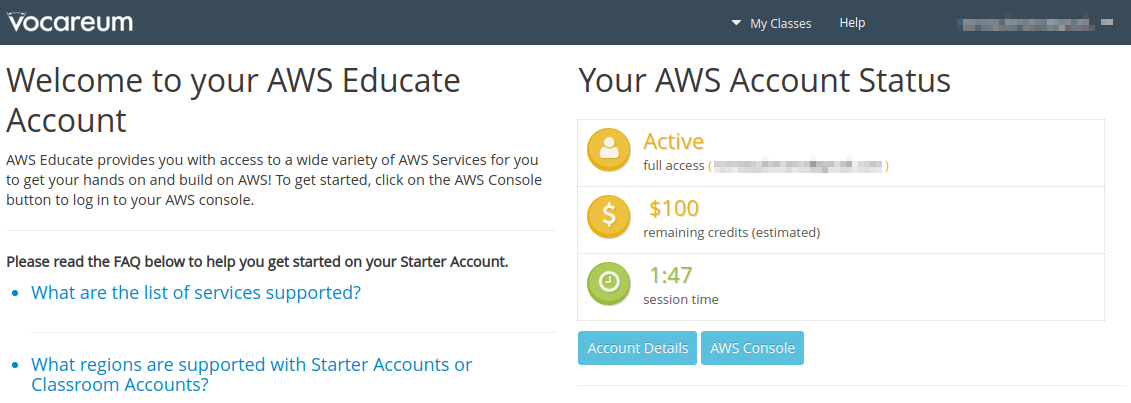

また,大学などの教育機関における講義で AWS を使用する際は, AWS Educate というプログラムを利用することも可能である. これは,講義の担当者が申請を行うことで,受講する学生に対し AWS クレジットが提供されるというプログラムである. AWS Educate を利用することで金銭的な負担なしに AWS を体験することができる. また,講義を経由せず個人でも AWS Educate に参加することも可能である. AWS Educate からは様々な学習教材が提供されているので,ぜひ活用してもらいたい.

環境構築

本書では, AWS 上にクラウドアプリケーションを展開するハンズオンを実施する. そこで紹介するプログラムを実行するためには,以下の計算機環境が必要である. インストールの方法については,巻末付録 (Appendix: 環境構築) に記してある. 必要に応じて参照し,環境構築を各自実施していただきたい.

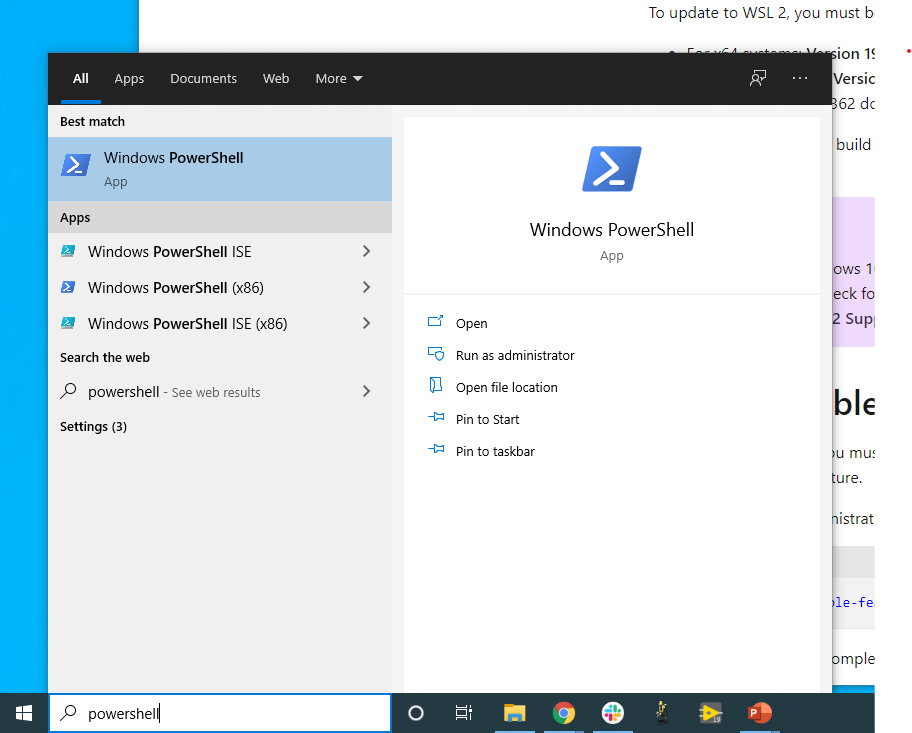

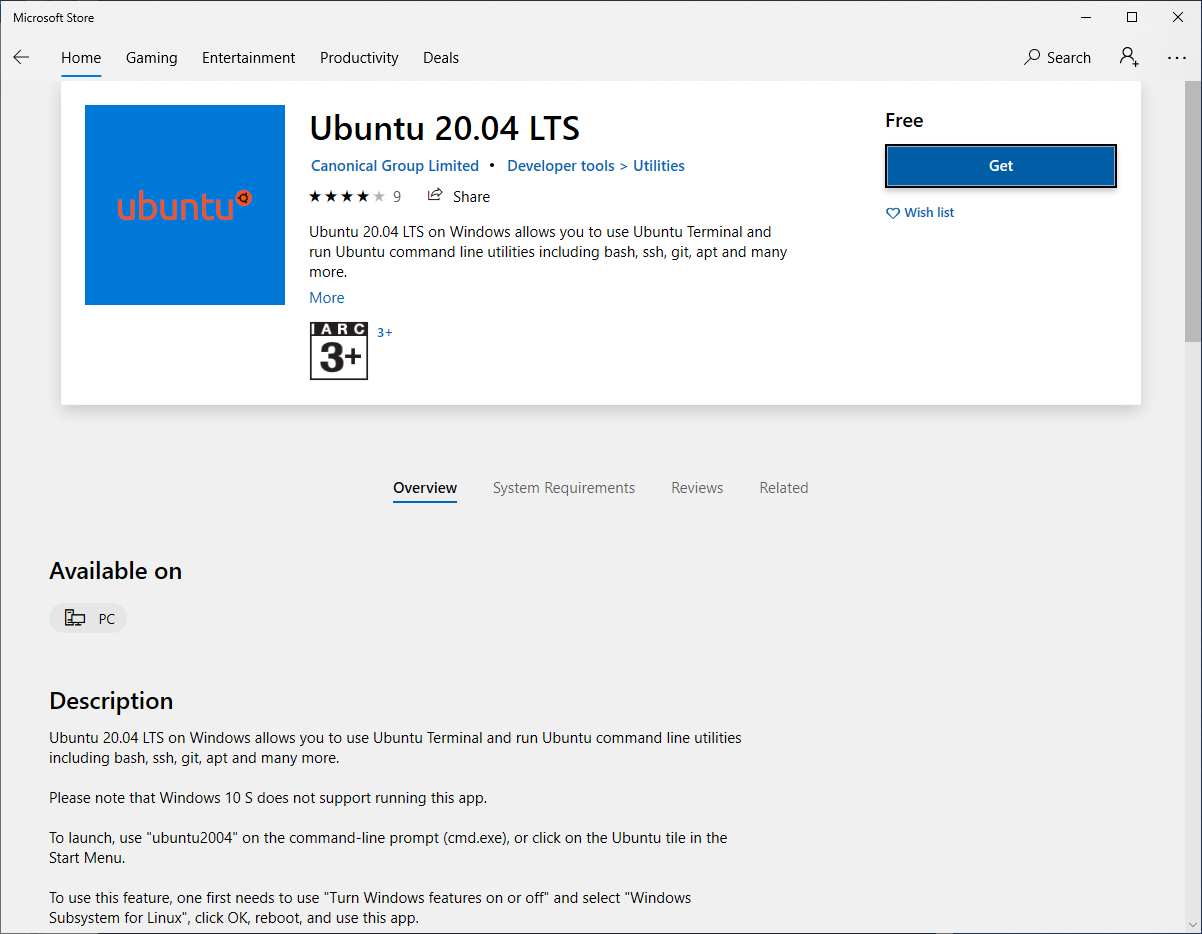

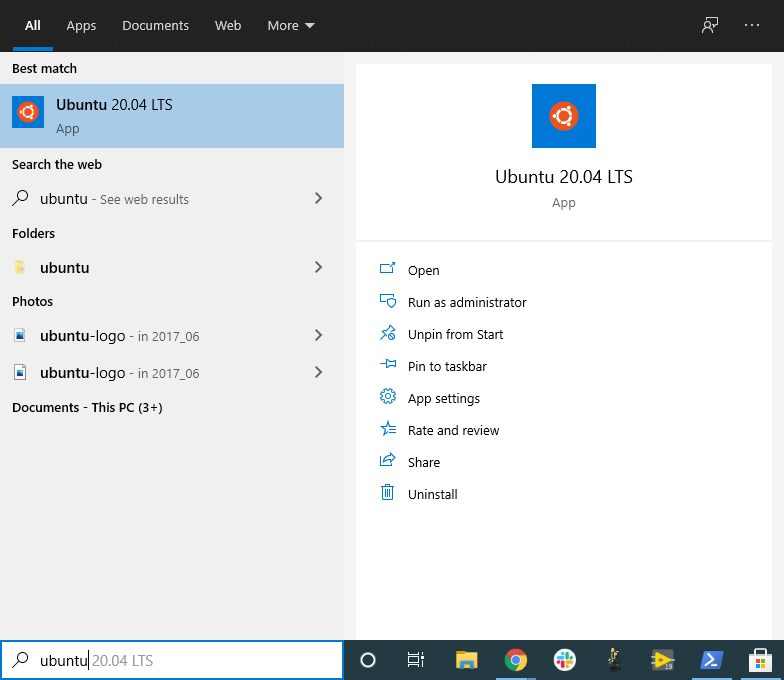

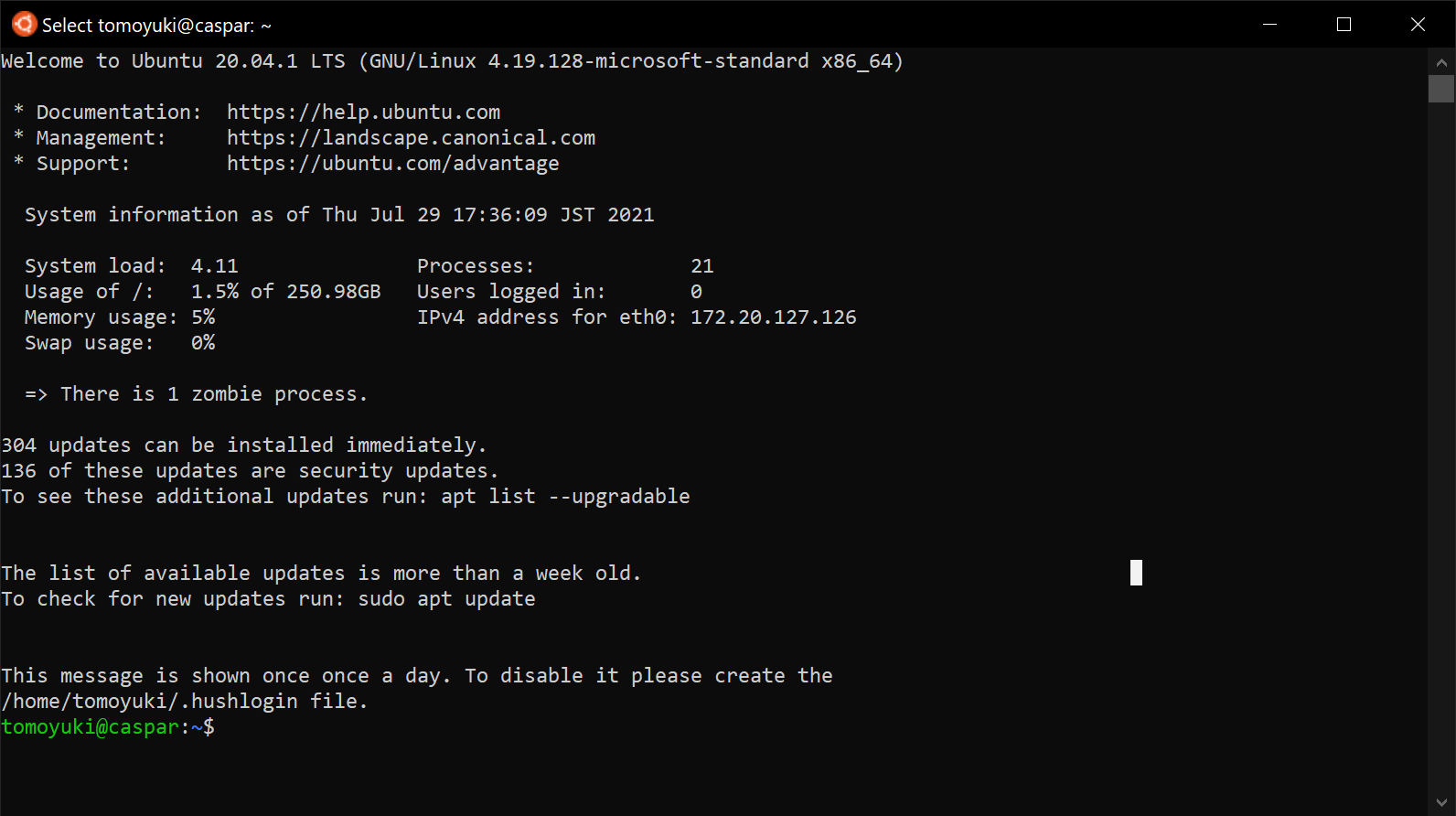

UNIX 系コンソール: ハンズオンで紹介するコマンドを実行したり, SSH でサーバーにアクセスするため, UNIX 系のコンソール環境が必要である. Mac または Linux のユーザーは, OS に標準搭載のコンソール(ターミナルとも呼ばれる)を使用すればよい. Windows のユーザーは, Windows Subsystem for Linux (WSL) を使い, Linux の仮想環境のインストールを推奨する (WSL のインストール 参照).

Docker: 本書では Docker とよばれる仮想計算環境の利用方法を解説する. インストール手順については Docker のインストール を参照のこと.

Python: Version 3.6 以上をインストールする. とくに,ハンズオンでは

venvモジュールを使用する.venvの使い方は Python クイックガイド 参照のこと.Node.js: version 12.0 以上 をインストールする.

AWS CLI: Version 2 をインストールする. インストール手順については AWS CLI のインストール 参照のこと.

AWS CDK: Version 1.100 以上をインストールする. Version 2 以降には未対応である. インストール手順については AWS CDK のインストール 参照のこと.

AWS 認証鍵の設定: AWS API をコマンドラインから呼ぶには,認証鍵 (secret key) が設定されている必要がある. 認証鍵の設定については AWS CLI のインストール 参照のこと.

ハンズオン実行用の Docker Image

Python, Node.js, AWS CDK など,ハンズオンのプログラムを実行するために必要なプログラム/ライブラリがインストール済みの Docker image を用意した. また,ハンズオンのソースコードもクローン済みである. Docker の使い方を知っている読者は,これを使えば,諸々のインストールをする必要なく,すぐにハンズオンのプログラムを実行できる.

次のコマンドで起動する.

sh

$ docker run -it tomomano/labc$ docker run -it tomomano/labcこの Docker image の使い方や詳細は ハンズオン実行用の Docker image の使い方 に記載している.

前提知識

本書を読むにあたり,要求する前提知識は大学初等程度の計算機科学の知識 (OS,プログラミングなど)のみである. それ以上の前提知識はとくに仮定しない. クラウドの利用経験もゼロで問題ない. が,以下の事前知識があるとよりスムーズに理解をすることができるだろう.

Python の基本的な理解: 本書では Python を使ってプログラムの作成を行う. 使用するライブラリは十分抽象化されており,関数の名前を見ただけで意味が明瞭なものがほとんどであるので, Python に詳しくなくても心配する必要はない.

Linux コマンドラインの基礎的な理解: クラウドを利用する際,クラウド上に立ち上がるサーバーは基本的に Linux である. Linux のコマンドラインについて知識があると,トラブルシュートなどが容易になる. 筆者のおすすめの参考書は The Linux Command Line by William Shotts である. ウェブで無料で読むことができるので,読んだことのない人はぜひ一読を.

講義に関連する資料

ハンズオンで使うプログラムや教科書のソースコードは以下のウェブページで公開している.

https://github.com/tomomano/learn-aws-by-coding

本書で使用するノーテーションなど

コードやシェルのコマンドは

monospace letterで記述する.シェルに入力するコマンドは,それがシェルコマンドであると明示する目的で,先頭に

$がつけてある.$はコマンドをコピー&ペーストするときは除かなければならない. 逆に,コマンドの出力には$はついていない点に留意する.

また,以下のような形式で注意やチップスを提供する.

追加のコメントなどを記す.

発展的な議論やアイディアなどを紹介する.

陥りやすいミスなどの注意事項を述べる.

絶対に犯してはならないミスを指摘する.

クラウド概論

クラウドとは?

クラウドとはなにか? クラウドという言葉は,それ自身がとても広い意味をもつので,厳密な定義付けを行うことは難しい.

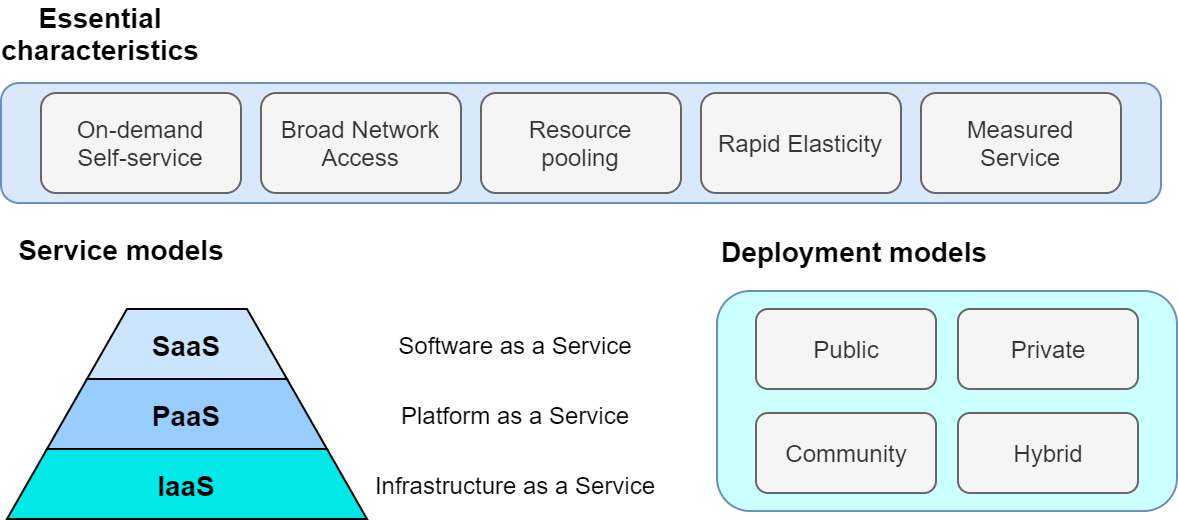

学術的な意味でのクラウドの定義づけをするとしたら,NIST(米国・国立標準技術研究所) による The NIST Definition of Cloud Computing が引用されることが多い. ここに記載されたクラウドの定義・モデルを図示したのが figure_title である.

これによると,クラウドとは以下の要件が満たされたハードウェア/ソフトウェアの総体のことをいう.

On-demand self-service 利用者のリクエストに応じて計算資源が自動的に割り当てられる.

Broad network access 利用者はネットワークを通じてクラウドにアクセスできる.

Resource pooling クラウドプロバイダーは,所有する計算資源を分割することで複数の利用者に計算資源を割り当てる.

Rapid elasticity 利用者のリクエストに応じて,迅速に計算資源の拡大あるいは縮小を行うことができる.

Measured service 計算資源の利用量を計測・監視することができる.

…と,いわれても抽象的でよくわからないかもしれない.もう少し具体的な話をする.

個人が所有する計算機で, CPU をアップグレードしようと思ったら,物理的に筐体を開け,CPU ソケットを露出させ,新しい CPU に交換する必要があるだろう. あるいは,ストレージがいっぱいになってしまったら,古いディスクを抜き取り,新しいディスクを挿入する必要がある. 計算機の場所を移動させたときには,新しい部屋の LAN ケーブルを差し込まないとネットワークには接続できない.

クラウドでは,これらの操作がプログラムからのコマンドによって実行できる. CPU が 1000 個欲しいと思ったならば,そのようにクラウドプロバイダーにリクエストを送れば良い. すると,数分もしないうちに 1000 CPU の計算資源が割り当てられる. ストレージを 1TB から 10TB に拡張しようと思ったならば,そのようにコマンドを送ればよい (これは,Google Drive や Dropbox などのサービスなどで馴染みのある人も多いだろう). 計算資源を使い終わったら,そのことをプロバイダーに伝えれば,割り当て分はすぐさま削除される. クラウドプロバイダーは,使った計算資源の量を正確にモニタリングしており,その量をもとに利用料金の計算が行われる.

このように,クラウドの本質は物理的なハードウェアの仮想化・抽象化であり,利用者はコマンドを通じて,まるでソフトウェアの一部かのように,物理的なハードウェアの管理・運用を行うことができる. もちろん,背後では,データセンターに置かれた膨大な数の計算機が大量の電力を消費しながら稼働している. クラウドプロバイダーはデータセンターの計算資源を上手にやりくりし,ソフトウェアとしてのインターフェースをユーザーに提供することで,このような仮想化・抽象化を達成しているわけである. クラウドプロバイダーの視点からすると,大勢のユーザーに計算機を貸し出し,データセンターの稼働率を常時 100%に近づけることで,利益率の最大化を図っているのである.

著者の言葉で,クラウドの重要な特性を定義するならば,以下のようになる.

クラウドとは計算機ハードウェアの抽象化である.つまり,物理的なハードウェアをソフトウェアの一部かのように自在に操作・拡大・接続することを可能にする技術である.

先述の The NIST Definition of Cloud Computing に戻ると,クラウドプロバイダーによるクラウドサービスの形態としては,次の三つが定義されている (figure_title).

Software as a Service (SaaS): クラウド上で実行されるアプリケーションをサービスとして利用者に提供する形態. 例として, Google Drive や Slack などが挙げられる. 利用者は,背後にあるクラウドのインフラ (ネットワークやサーバーなど) には直接触れず,アプリケーションとして提供されているクラウドサービスを享受する.

Platform as a Service (PaaS): 顧客の作成したアプリケーション (多くの場合データベースと API リクエスト処理を行うサーバーのコードから構成される) をデプロイする環境をサービスとして利用者に提供する形態. PaaS では利用者はクラウドのインフラに直接触れることはなく,計算負荷が増減した際のサーバーのスケーリングはクラウドプロバイダーによってなされる. 例としては, Google App Engine や Heroku などがある.

Infrastructure as a Service (IaaS): クラウド上の計算インフラストラクチャーを従量課金制で利用者に提供する形態. 利用者は必要なネットワーク・サーバー・ストレージをプロバイダーから借り受け,そこに自身のアプリケーションを展開し運用する. IaaS の例としては AWS EC2 などが挙げられる.

本書が扱うのは,主に IaaS におけるクラウド開発である. すなわち,開発者がクラウドのインフラを直接操作し,所望のネットワーク・サーバー・ストレージなどを一から構成し,そこにアプリケーションを展開するというクラウド開発である. この意味において,クラウドの開発とはクラウドインフラストラクチャーを定義・展開するプログラムを構築するステップとインフラ上で実際に走るアプリケーションを作成するステップの二つに分けることができる. この二つは,プログラマーの技術としてはある程度分業を行うことが可能であるが,最も効率化・最適化されたクラウドシステムを構築するためには両方の理解が必須である. 本書では,前者 (クラウドインフラの記述) に重きを置きつつ,アプリケーションレイヤーの話題も取り扱う. PaaS とは,開発者はアプリケーションレイヤーの開発に注力し,クラウドインフラの部分はクラウドプロバイダーに依存するという概念である. PaaS は,クラウドインフラの開発が不要になることで開発の時間が短縮されるが,細かなインフラの挙動はコントロールできないという限界がある. 本書では PaaS についてはとくに取り扱わない.

SaaS は本書の文脈では開発による"成果物"と捉えられるだろう. すなわち, IaaS を構成するプログラムを作成し展開することによって,一般の人が利用できるようなウェブ上の計算サービスやデータベースを提供することが開発の最終ゴールである. 本書のハンズオンではその実例として,シンプルな SNS の作成 (Hands-on #6: Bashoutter) などの演習を提供する.

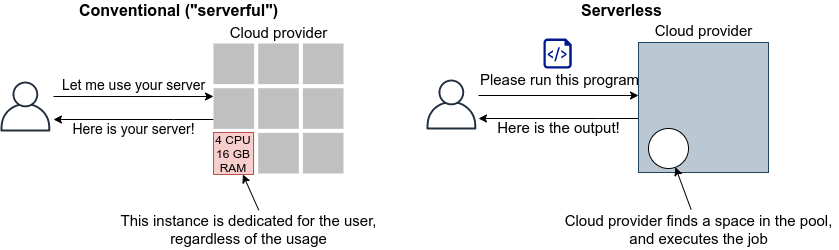

なお,最近では Function as a Service (FaaS) やサーバーレスコンピューティングなども新たなクラウドのカテゴリとして認知されている. これらの概念については Hands-on #5: サーバーレス入門 などの章で詳しく触れていく. 本書を読み進める中で明らかになるように,クラウドの技術は日進月歩である. 本書では実用的・教育的な観点から,従来的なクラウドの設計概念に触れたあと,サーバーレスなどの最新の技術も網羅するので,楽しみにしながら読み進めていただきたい.

最後に,The NIST Definition of Cloud Computing によると,クラウドの運用形態について次のような定義がなされている (figure_title). 特定の組織・団体・企業の内部のみで使用されるクラウドを,プライベートクラウド (private cloud) とよぶ. 例えば,大学や研究機関では,その機関の構成員向けの大規模計算機サーバーが運用されていることが多い. プライベートクラウドは,組織の構成員ならば無料もしくは極めて割安のコストで計算を実行できる. しかし,使用できる計算資源の上限は限られる場合が多く,拡張時の柔軟性に欠ける場合もある.

一方,商用のサービスとして一般の顧客に向けたクラウドのことを,パブリッククラウド (public cloud) とよぶ. 有名なパブリッククラウドプラットフォームの例を挙げると, Google 社が提供する Google Cloud Platform (GCP), Microsoft 社が提供する Azure, Amazon 社が提供する Amazon Web Services (AWS) などがある. パブリッククラウドを利用する場合は,プロバイダーの設定した利用料金を支払うことになる. その分,巨大なデータセンターを運用する企業の計算資源にアクセスすることができるので,計算のキャパシティは無尽蔵にあるといって過言でない.

第三のクラウドの運用形態として,コミュニティクラウド (community cloud) が挙げられる. これは,例えば政府の省庁・機関など目的・役割を共有する団体・組織が共有して運用するクラウドを指す. 最後に,ハイブリッドクラウド (hybrid cloud) という形態もあり,これはプライベート・パブリック・コミュニティクラウドの二つ以上の組み合わせによって構成されるクラウドのことである. データ保護の観点から,いくつかの機密データやプライバシーに関わる情報はプライベートクラウドに保持し,残りのシステムをパブリッククラウドに依存する,などの形態が想定される.

本書で説明するのは,基本的にパブリッククラウドを使ったクラウド開発である. 特に,Amazon Web Services (AWS) を使用して,具体的な技術と概念を学んでいく. 一方で,サーバーのスケーリングや仮想計算環境などのテクニックはすべてのクラウドに共通な概念であるので,クラウドのプラットフォームが変わろうと一般に通用する知識も同時に身につくはずだ.

なぜクラウドを使うのか?

上述のように,クラウドとはプログラムを通じて自由に計算資源を操作することのできる計算環境である. ここでは,リアルなローカル計算環境と比べて,なぜクラウドを使うと良いことがあるのかについて述べたい.

自由にサーバーのサイズをスケールできる

なにか新しいプロジェクトを始めるとき,あらかじめ必要なサーバーのスペックを知るのは難しい. いきなり大きなサーバーを買うのはリスクが高い. 一方で,小さすぎるサーバーでは,後のアップグレードが面倒である. クラウドを利用すれば,プロジェクトを進めながら,必要な分だけの計算資源を確保することができる. 2. 自分でサーバーをメンテナンスする必要がない

悲しいことに,コンピュータとは古くなるものである.最近の技術の進歩の速度からすると,5 年も経てば,もはや当時の最新コンピュータも化石と同じである. 5 年ごとにサーバーを入れ替えるのは相当な手間である. またサーバーの停電や故障など不意の障害への対応も必要である. クラウドでは,そのようなインフラの整備やメンテナンスはプロバイダーが自動でやってくれるので,ユーザーが心配する必要がない. 3. 初期コスト 0

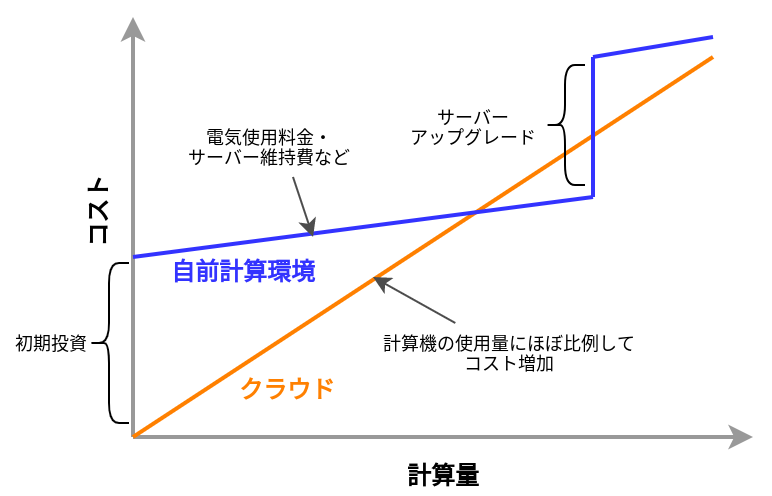

自前の計算環境とクラウドの,経済的なコストのイメージを示したのが figure_title である. クラウドを利用する場合の初期コストは基本的に 0 である. その後,使った利用量に応じてコストが増大していく. 一方,自前の計算環境では,大きな初期コストが生じる. その分,初期投資後のコストの増加は,電気利用料やサーバー維持費などに留まるため,クラウドを利用した場合よりも傾きは小さくなる. 自前の計算機では,ある一定期間後,サーバーのアップグレードなどによる支出が生じることがある. 一方,クラウドを利用する場合は,そのような非連続なコストの増大は基本的に生じない. クラウドのコストのカーブが,自前計算環境のコストのカーブの下にある範囲においては,クラウドを使うことは経済的なコスト削減につながる.

とくに,**1.**の点は研究の場面では重要であると筆者は感じる. 研究をやっていて,四六時中計算を走らせ続けるという場合は少ない. むしろ,新しいアルゴリズムが完成したとき・新しいデータが届いたとき,集中的・突発的に計算タスクが増大することが多いだろう. そういったときに,フレキシブルに計算力を増強させることができるのは,クラウドを使う大きなメリットである.

ここまでクラウドを使うメリットを述べたが,逆に,デメリットというのも当然存在する.

クラウドは賢く使わないといけない

figure_title で示したコストのカーブにあるとおり,使い方によっては自前の計算環境のほうがコスト的に有利な場面は存在しうる. クラウドを利用する際は,使い終わった計算資源はすぐに削除するなど,利用者が賢く管理を行う必要があり,これを怠ると思いもしない額の請求が届く可能性がある. 2. セキュリティ

クラウドは,インターネットを通じて世界のどこからでもアクセスできる状態にあり,セキュリティ管理を怠ると簡単にハッキングの対象となりうる. ハッキングを受けると,情報流出だけでなく,経済的な損失を被る可能性がある. 3. ラーニングカーブ

上記のように,コスト・セキュリティなど,クラウドを利用する際に留意しなければならない点は多い. 賢くクラウドを使うには,十分なクラウドの理解が必要であり,そのラーニングカーブを乗り越える必要がある.

Mac/Linux などでコマンドを入力するときに使用する,あの黒い画面のことを Terminal とよんだりする. この言葉の語源をご存知だろうか?

この言葉の語源は,コンピュータが誕生して間もない頃の時代に遡る. その頃のコンピュータというと,何千何万のという数の真空管が接続された,会議室一個分くらいのサイズのマシンであった. そのような高価でメンテが大変な機材であるから,当然みんなでシェアして使うことが前提となる. ユーザーがコンピュータにアクセスするため,マシンからは何本かのケーブルが伸び,それぞれにキーボードとスクリーンが接続されていた… これを Terminal とよんでいたのである. 人々は,代わる代わる Terminal の前に座って,計算機との対話を行っていた.

時代は流れ,Windows や Mac などのいわゆるパーソナルコンピュータの出現により,コンピュータはみんなで共有するものではなく,個人が所有するものになった.

最近のクラウドの台頭は,みんなで大きなコンピュータをシェアするという,最初のコンピュータの使われ方に原点回帰していると捉えることもできる. 一方で,スマートフォンやウェアラブルなどのエッジデバイスの普及も盛んであり,個人が複数の"小さな"コンピュータを所有する,という流れも同時に進行しているのである.

AWS 入門

AWS とは?

本書では,クラウドの実践を行うプラットフォームとして, AWS を用いる. 実践にあたって,最低限必要な AWS の知識を本章では解説しよう.

AWS (Amazon Web Services) は Amazon 社が提供する総合的なクラウドプラットフォームである. AWS は Amazon 社が持つ膨大な計算リソースを貸し出すクラウドサービスとして,2006 年に誕生した. 2021 年では,クラウドプロバイダーとして最大のマーケットシェア (約 32%) を保持している (参照). Netflix や Slack をはじめとした多くのウェブ関連のサービスで,一部または全てのサーバーリソースが AWS から提供されているとのことである. よって,知らないうちに AWS の恩恵にあずかっている人も少なくないはずだ.

最大のシェアをもつだけに,機能・サービスの幅広さはほかのクラウドプラットフォームと比べ抜きんでている. また,利用者数が多いことを反映して,公式あるいはサードパーティによる技術紹介記事が数多くウェブ上に存在しているだけでなく,ライブラリのユーザーコミュニティも大きく問題解決が捗るのも魅力の一つだ. 初期のころウェブビジネスを行う企業がユーザーの大半を占めていたが,最近は大学などでの科学研究用途としても頻繁に用いられるようになってきている.

AWS の機能・サービス

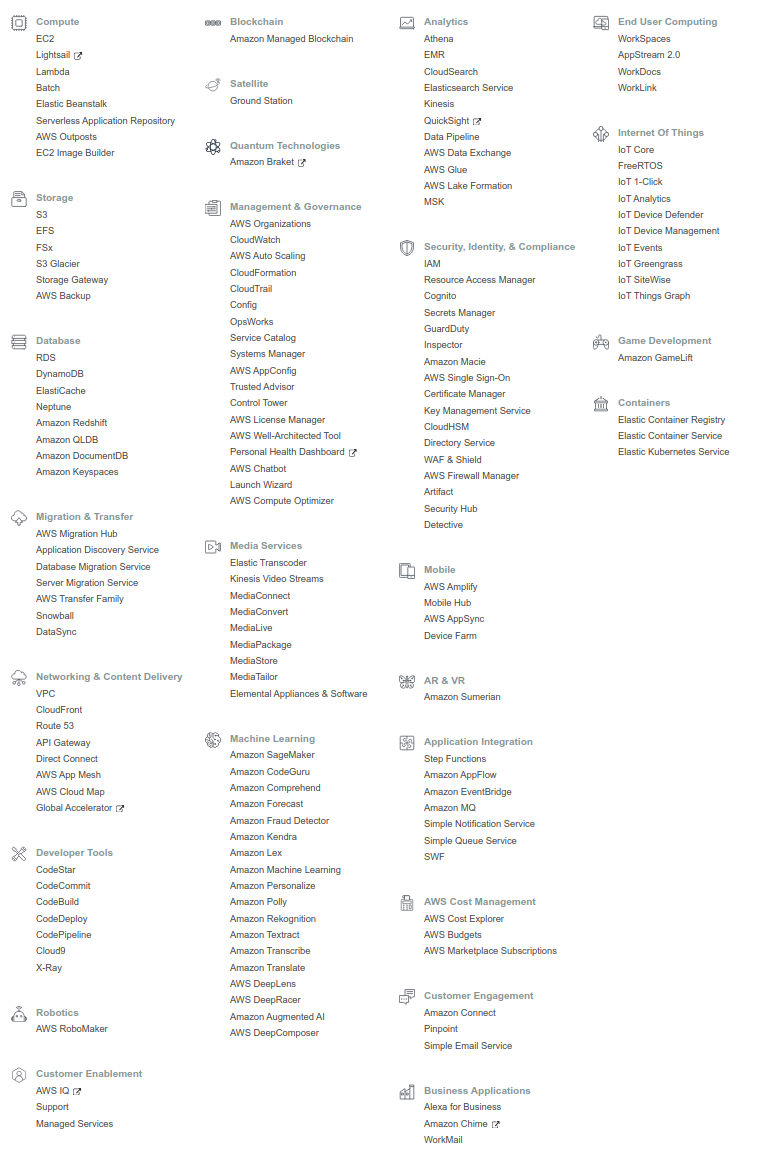

figure_title は,執筆時点において AWS で提供されている主要な機能・サービスの一覧である.

計算,ストレージ,データベース,ネットワーク,セキュリティなど,クラウドの構築に必要な様々な要素が独立したコンポーネントとして提供されている. 基本的に,これらを組み合わせることで一つのクラウドシステムができあがる.

また,機械学習・音声認識・AR/VR など,特定のアプリケーションにパッケージ済みのサービスも提供されている. これらを合計すると全部で 170 個以上のサービスが提供されているとのことである (参照).

AWS の初心者が陥りがちなのは,大量のサービスの数に圧倒され,どこから手をつけたらよいのかわからなくなる,という状況である. たくさんのサービスの中から,どのサービスをどの順番で学んでいったらいいのか,その道筋すら明らかでなく,大きな参入障壁となっていることは間違いない. だが実のところ, AWS の基本的な構成要素はそのうちの数個のみに限られる. 基本要素となる機能の使い方を知れば, AWS のおおよそのリソースを使いこなすことが可能になる. ほかの機能の多くは,基本の要素を組み合わせて特定のアプリケーションに特化したパッケージとして AWS が用意したものである. そのポイントを認知することが, AWS の学習の最初のステップである.

ここでは, AWS 上でクラウドシステムを構築するときの基本となる構成要素を列挙する. これらは後のハンズオンで実際にプログラムを書きながら体験する. 現時点では,名前だけでも頭の片隅に記憶してもらえればよい.

計算

EC2 (Elastic Compute Cloud) 様々なスペックの仮想マシンを作成し,計算を実行することができる. クラウドの最も基本となる構成要素である. Hands-on #1: 初めての EC2 インスタンスを起動する, Hands-on #2: AWS でディープラーニングを実践, Hands-on #4: AWS Batch を使って機械学習のハイパーパラメータサーチを並列化する で詳しく触れる.

EC2 (Elastic Compute Cloud) 様々なスペックの仮想マシンを作成し,計算を実行することができる. クラウドの最も基本となる構成要素である. Hands-on #1: 初めての EC2 インスタンスを起動する, Hands-on #2: AWS でディープラーニングを実践, Hands-on #4: AWS Batch を使って機械学習のハイパーパラメータサーチを並列化する で詳しく触れる.

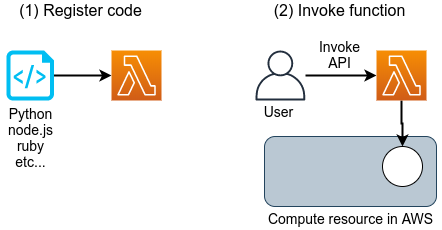

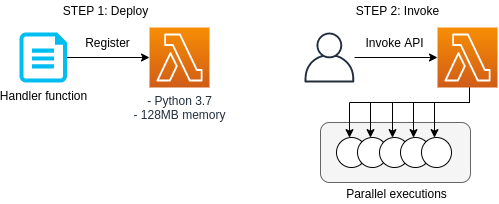

Lambda Function as a Service (FaaS) とよばれる,小さな計算をサーバーなしで実行するためのサービス. サーバーレスアーキテクチャの章 (Serverless architecture) で詳しく解説する.

Lambda Function as a Service (FaaS) とよばれる,小さな計算をサーバーなしで実行するためのサービス. サーバーレスアーキテクチャの章 (Serverless architecture) で詳しく解説する.

ストレージ

EBS (Elastic Block Store) EC2 に付与することのできる仮想データドライブ. いわゆる"普通の"(一般的な OS で使われている)ファイルシステムを思い浮かべてくれたらよい.

EBS (Elastic Block Store) EC2 に付与することのできる仮想データドライブ. いわゆる"普通の"(一般的な OS で使われている)ファイルシステムを思い浮かべてくれたらよい.

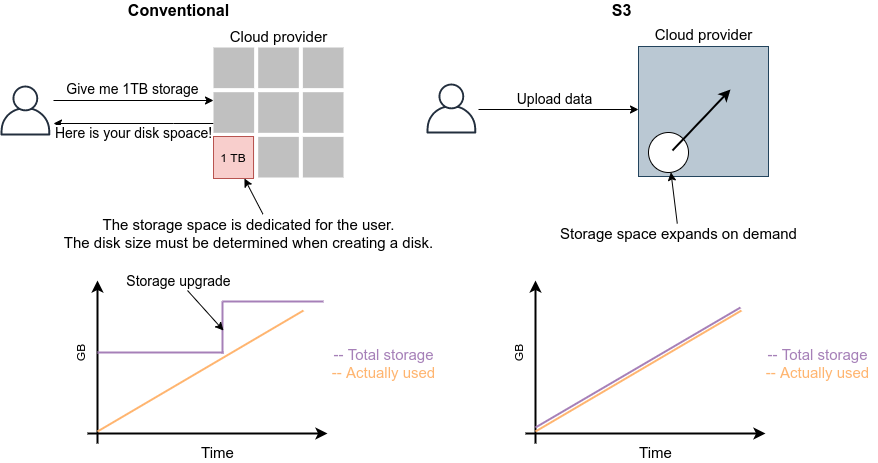

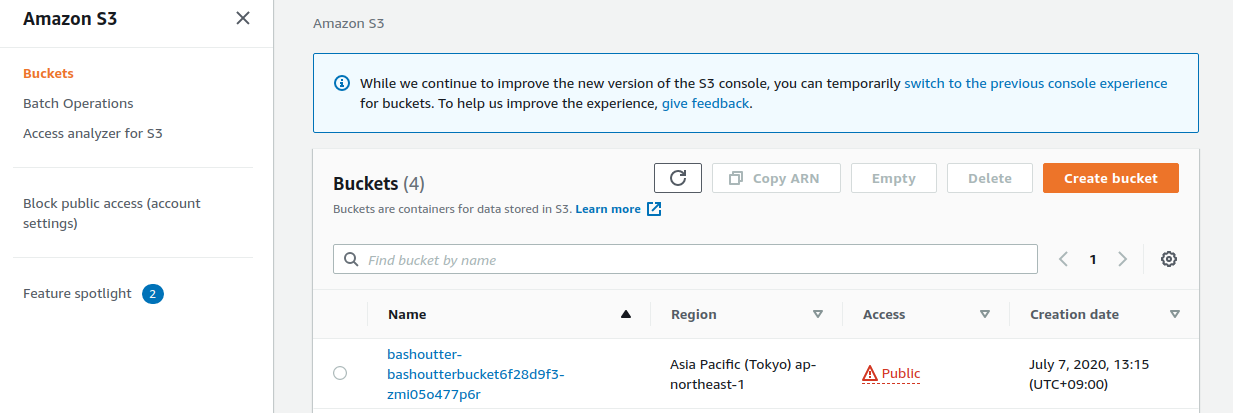

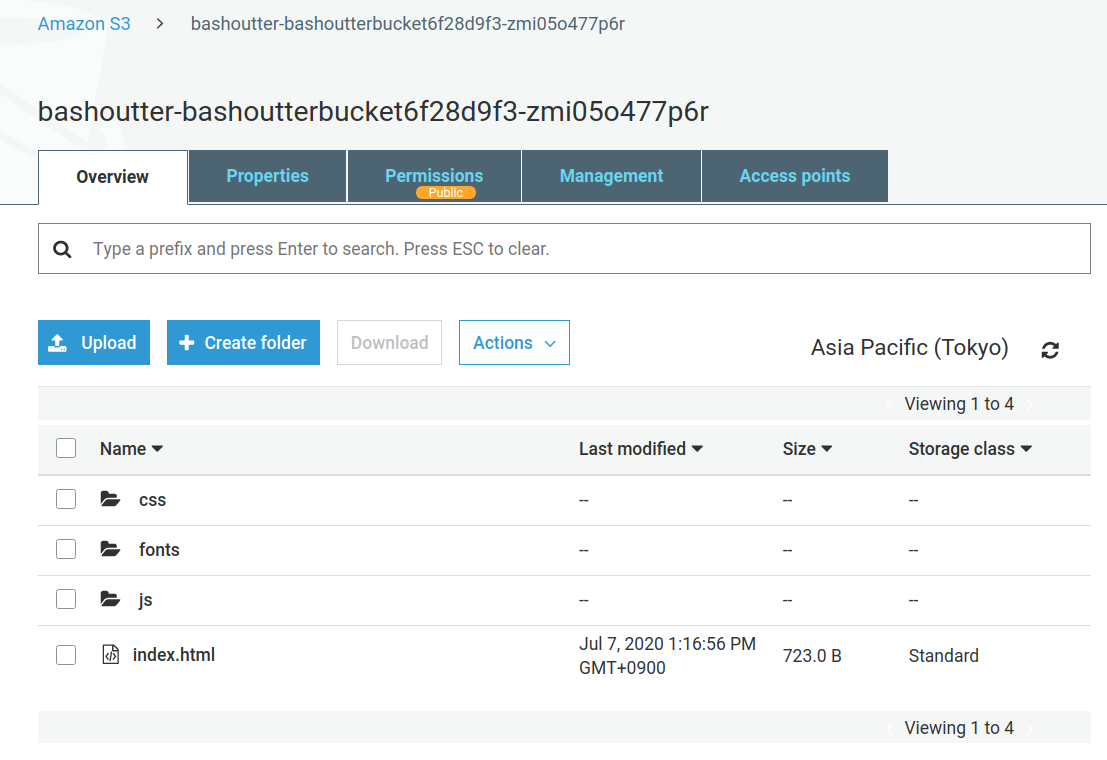

S3 (Simple Storage Service) Object Storage とよばれる,API を使ってデータの読み書きを行う,いうなれば”クラウド・ネイティブ”なデータの格納システムである. サーバーレスアーキテクチャの章 (Serverless architecture) で詳しく解説する.

S3 (Simple Storage Service) Object Storage とよばれる,API を使ってデータの読み書きを行う,いうなれば”クラウド・ネイティブ”なデータの格納システムである. サーバーレスアーキテクチャの章 (Serverless architecture) で詳しく解説する.

データベース

DynamoDB NoSQL 型のデータベースサービス (知っている人は

DynamoDB NoSQL 型のデータベースサービス (知っている人は mongoDB などを思い浮かべたらよい). サーバーレスアーキテクチャの章 (Serverless architecture) で詳しく解説する.

ネットワーク

VPC(Virtual Private Cloud) AWS 上に仮想ネットワーク環境を作成し,仮想サーバー間の接続を定義したり,外部からのアクセスなどを管理する. EC2 は VPC の内部に配置されなければならない.

VPC(Virtual Private Cloud) AWS 上に仮想ネットワーク環境を作成し,仮想サーバー間の接続を定義したり,外部からのアクセスなどを管理する. EC2 は VPC の内部に配置されなければならない.

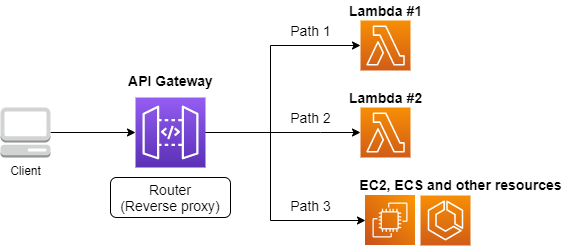

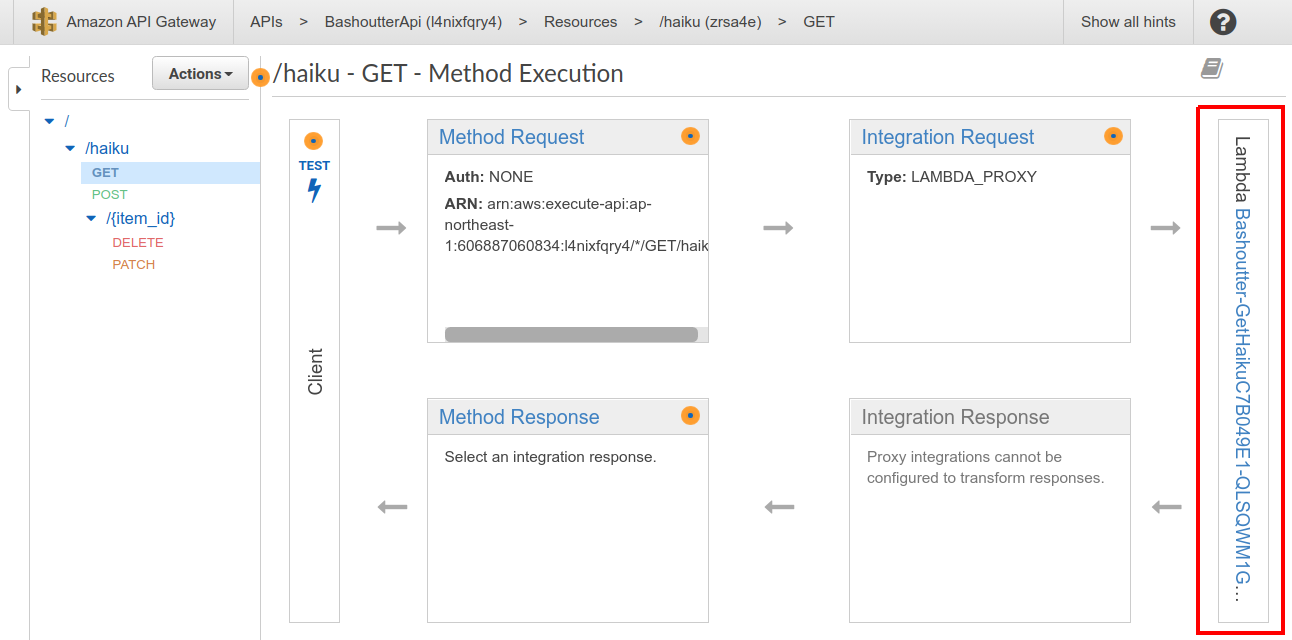

API Gateway  API のエンドポイントとバックエンドのサービス (Lambda など) を接続する際に用いる,リバースプロキシとしての役割を担う. Hands-on #6: Bashoutter で詳しく解説する.

API のエンドポイントとバックエンドのサービス (Lambda など) を接続する際に用いる,リバースプロキシとしての役割を担う. Hands-on #6: Bashoutter で詳しく解説する.

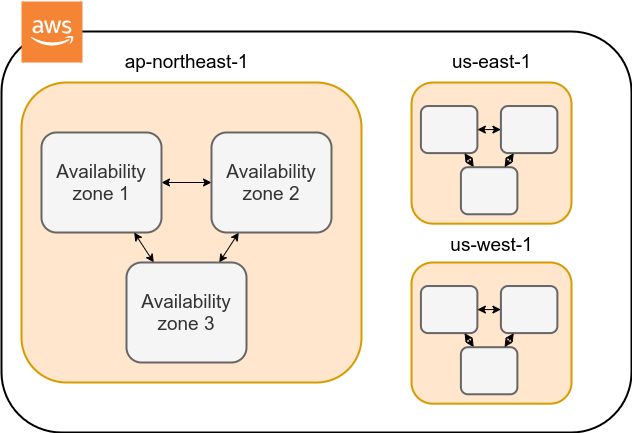

Region と Availability Zone

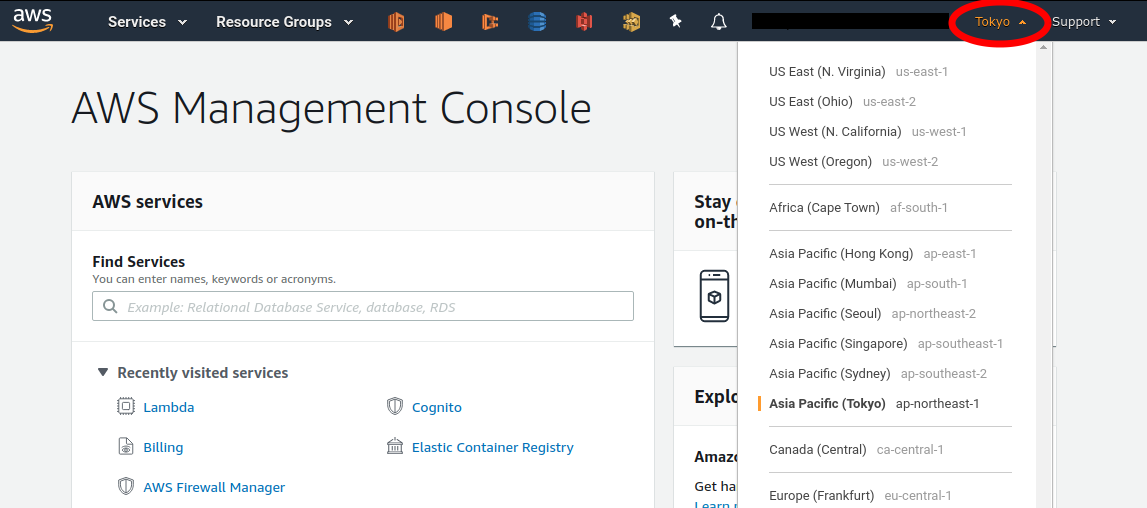

AWS を使用する際に知っておかなければならない重要な概念として, リージョン (Region) と Availability Zone (AZ) がある (figure_title). 以下ではこの概念について簡単に記述する.

リージョン (Region) とは,おおまかに言うとデータセンターの所在地のことである. 執筆時点において, AWS は世界の 25 の国と地域でデータセンターを所有している. figure_title は執筆時点で利用できるリージョンの世界地図を示している. 日本では東京と大阪にデータセンターがある. 各リージョンには固有の ID がついており,例えば東京は ap-northeast-1, 米国オハイオ州は us-east-2,などと定義されている.

AWS コンソールにログインすると,画面右上のメニューバーでリージョンを選択することができる(figure_title, 赤丸で囲った箇所). EC2, S3 などの AWS のリソースは,リージョンごとに完全に独立である. したがって,リソースを新たにデプロイする際,あるいはデプロイ済みのリソースを閲覧する際は,コンソールのリージョンが正しく設定されているか,確認する必要がある. ウェブビジネスを展開する場合などは,世界の各地にクラウドを展開する必要があるが,個人的な研究用途として用いる場合は,最寄りのリージョン (i.e. 東京) を使えば基本的に問題ない.

Avaialibity Zone (AZ) とは,リージョン内で地理的に隔離されたデータセンターのことである. それぞれのリージョンは 2 個以上の AZ を有しており,もし一つの AZ で火災や停電などが起きた場合でも,ほかの AZ がその障害をカバーすることができる. また, AZ 間は高速な AWS 専用ネットワーク回線で結ばれているため, AZ 間のデータ転送は極めて早い. AZ は,ビジネスなどでサーバーダウンが許容されない場合などに注意すべき概念であり,個人的な用途で使う限りにおいてはあまり深く考慮する必要はない.言葉の意味だけ知っておけば十分である.

AWS を使用する際,どこのリージョンを指定するのがよいのだろうか? インターネットの接続速度の観点からは,地理的に一番近いリージョンを使用するのが一般的によいだろう. 一方, EC2 の利用料などはリージョンごとに価格設定が若干 (10-20%程度) 異なる. したがって,自分が最も頻繁に利用するサービスの価格が最も安く設定されているリージョンを選択する,というのも重要な視点である. また,いくつかのサービスは,特定のリージョンで利用できない場合もある. これらのポイントから総合的に判断して使用するリージョンを決めると良い.

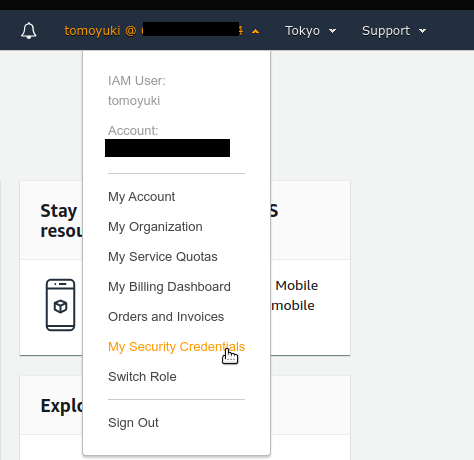

AWS Educate を利用している読者へ

執筆時点において,AWS Educate による Starter Account を使用している場合は us-east-1 region のみ利用できる (参照).

AWS でのクラウド開発

AWS のクラウドの全体像がわかってきたところで,次のトピックとして,どのようにして AWS 上にクラウドの開発を行い,展開していくかについての概略を解説しよう.

AWS のリソースを追加・編集・削除するなどの操作を実行するには,コンソールを用いる方法と,API を用いる方法の,二つの経路がある.

コンソール画面からリソースを操作する

AWS のアカウントにログインすると,まず最初に表示されるのがAWS コンソールである (figure_title).

コンソールを使うことで, EC2 のインスタンスを立ち上げたり,S3 のデータを追加・削除したり,ログを閲覧したりなど,AWS 上のあらゆるリソースの操作を GUI (Graphical User Interface) を通して実行することができる. 初めて触る機能をポチポチと試したり,デバッグを行うときなどにとても便利である.

コンソールはさらっと機能を試したり,開発中のクラウドのデバッグをするときには便利なのであるが,実際にクラウドの開発をする場面でこれを直接いじることはあまりない. むしろ,次に紹介する API を使用して,プログラムとしてクラウドのリソースを記述することで開発を行うのが一般的である. そのような理由で,本書では AWS コンソールを使った AWS の使い方はあまり触れない. AWS のドキュメンテーションには,たくさんの チュートリアル が用意されており,コンソール画面から様々な操作を行う方法が記述されているので,興味がある読者はそちらを参照されたい.

API からリソースを操作する

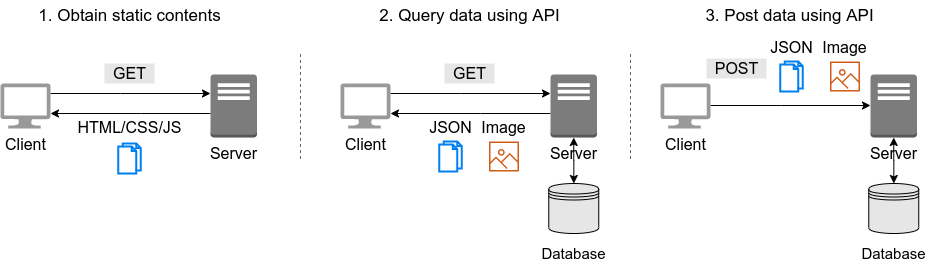

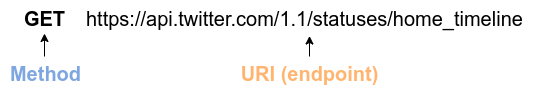

API (Application Programming Interface) を使うことで,コマンドを AWS に送信し,クラウドのリソースの操作をすることができる. API とは,端的に言えば AWS が公開しているコマンドの一覧であり,GET, POST, DELETE などの REST API から構成されている (REST API については REST API で簡単に解説する). が,直接 REST API を入力するのは面倒であるので,その手間を解消するための様々なツールが提供されている.

例えば, AWS CLI は, UNIX コンソールから AWS API を実行するための CLI (Command Line Interface) である. CLI に加えて,いろいろなプログラミング言語での SDK (Software Development Kit) が提供されている.以下に一例を挙げる.

Python ⇒ boto3

Ruby ⇒ AWS SDK for Ruby

Node.js ⇒ AWS SDK for Node.js

具体的な API の使用例を見てみよう.

S3 に新しい保存領域 (Bucket (バケット) とよばれる) を追加したいとしよう. AWS CLI を使った場合は,次のようなコマンドを打てばよい.

sh

$ aws s3 mb s3://my-bucket --region ap-northeast-1$ aws s3 mb s3://my-bucket --region ap-northeast-1上記のコマンドは, my-bucket という名前のバケットを, ap-northeast-1 のリージョンに作成する.

Python からこれと同じ操作を実行するには, boto3 ライブラリを使って,次のようなスクリプトを実行する.

python

import boto3

s3_client = boto3.client("s3", region_name="ap-northeast-1")

s3_client.create_bucket(Bucket="my-bucket")import boto3

s3_client = boto3.client("s3", region_name="ap-northeast-1")

s3_client.create_bucket(Bucket="my-bucket")もう一つ例をあげよう.

新しい EC2 のインスタンス(インスタンスとは,起動状態にある仮想サーバーの意味である)を起動するには,次のようなコマンドを打てば良い.

sh

$ aws ec2 run-instances --image-id ami-xxxxxxxx --count 1 --instance-type t2.micro --key-name MyKeyPair --security-group-ids sg-903004f8 --subnet-id subnet-6e7f829e$ aws ec2 run-instances --image-id ami-xxxxxxxx --count 1 --instance-type t2.micro --key-name MyKeyPair --security-group-ids sg-903004f8 --subnet-id subnet-6e7f829eこのコマンドにより, t2.micro というタイプ (1 vCPU, 1.0 GB RAM) のインスタンスが起動する. ここではその他のパラメータの詳細の説明は省略する (ハンズオン (Hands-on #1: 初めての EC2 インスタンスを起動する) で詳しく解説する).

Python から上記と同じ操作を実行するには,以下のようなスクリプトを使う.

python

import boto3

ec2_client = boto3.client("ec2")

ec2_client.run_instances(

ImageId="ami-xxxxxxxxx",

MinCount=1,

MaxCount=1,

KeyName="MyKeyPair",

InstanceType="t2.micro",

SecurityGroupIds=["sg-903004f8"],

SubnetId="subnet-6e7f829e",

)import boto3

ec2_client = boto3.client("ec2")

ec2_client.run_instances(

ImageId="ami-xxxxxxxxx",

MinCount=1,

MaxCount=1,

KeyName="MyKeyPair",

InstanceType="t2.micro",

SecurityGroupIds=["sg-903004f8"],

SubnetId="subnet-6e7f829e",

)以上の例を通じて,API によるクラウドのリソースの操作のイメージがつかめてきただろうか? コマンド一つで,新しい仮想サーバーを起動したり,データの保存領域を追加したり,任意の操作を実行できるわけである. 基本的に,このようなコマンドを複数組み合わせていくことで,自分の望む CPU・RAM・ネットワーク・ストレージが備わった計算環境を構築することができる. もちろん,逆の操作 (リソースの削除) も API を使って実行できる.

ミニ・ハンズオン: AWS CLI を使ってみよう

ここでは,ミニ・ハンズオンとして,AWS CLI を実際に使ってみる. AWS CLI は先述のとおり, AWS 上の任意のリソースの操作が可能であるが,ここでは一番シンプルな,S3 を使ったファイルの読み書きを実践する (EC2 の操作は少し複雑なので,第一回ハンズオンで行う). aws s3 コマンドの詳しい使い方は 公式ドキュメンテーションを参照.

AWS CLI のインストールについては, AWS CLI のインストール を参照.

以下に紹介するハンズオンは,基本的に S3 の無料枠 の範囲内で実行することができる.

以下のコマンドを実行する前に,AWS の認証情報が正しく設定されていることを確認する. これには ~/.aws/credentials のファイルに設定が書き込まれているか,環境変数 (AWS_ACCESS_KEY_ID, AWS_SECRET_ACCESS_KEY, AWS_DEFAULT_REGION) が定義されている必要がある. 詳しくは AWS CLI のインストール を参照.

まずは,S3 にデータの格納領域 (Bucket とよばれる.一般的な OS での"ドライブ"に相当する) を作成するところから始めよう.

sh

$ bucketName="mybucket-$(openssl rand -hex 12)"

$ echo $bucketName

$ aws s3 mb "s3://${bucketName}"$ bucketName="mybucket-$(openssl rand -hex 12)"

$ echo $bucketName

$ aws s3 mb "s3://${bucketName}"S3 のバケットの名前は, AWS 全体で一意的でなければならないことから,前述のコマンドではランダムな文字列を含んだバケットの名前を生成し,bucketName という変数に格納している. そして, aws s3 mb (mb は make bucket の略) によって,新しいバケットを作成する.

次に,バケットの一覧を取得してみよう.

sh

$ aws s3 ls

2020-06-07 23:45:44 mybucket-c6f93855550a72b5b66f5efe$ aws s3 ls

2020-06-07 23:45:44 mybucket-c6f93855550a72b5b66f5efe先ほど作成したバケットがリストにあることを確認できる.

本書のノーテーションとして,コマンドラインに入力するコマンドは,それがコマンドであると明示する目的で先頭に $ がつけてある. $ はコマンドをコピー&ペーストするときは除かなければならない. 逆に,コマンドの出力は $ なしで表示されている.

次に,バケットにファイルをアップロードする.

sh

$ echo "Hello world" > hello_world.txt

$ aws s3 cp hello_world.txt "s3://${bucketName}/hello_world.txt"$ echo "Hello world" > hello_world.txt

$ aws s3 cp hello_world.txt "s3://${bucketName}/hello_world.txt"上では hello_world.txt というダミーのファイルを作成して,それをアップロードした.

それでは,バケットの中にあるファイルの一覧を取得してみる.

sh

$ aws s3 ls "s3://${bucketName}" --human-readable

2020-06-07 23:54:19 13 Bytes hello_world.txt$ aws s3 ls "s3://${bucketName}" --human-readable

2020-06-07 23:54:19 13 Bytes hello_world.txt先ほどアップロードしたファイルがたしかに存在することがわかる.

最後に,使い終わったバケットを削除する.

sh

$ aws s3 rb "s3://${bucketName}" --force$ aws s3 rb "s3://${bucketName}" --forcerb は remove bucket の略である. デフォルトでは,バケットの中にファイルが存在すると削除できない. 空でないバケットを強制的に削除するには --force のオプションを付ける.

以上のように,AWS CLI を使って S3 バケットに対しての一連の操作を実行できた. EC2 や Lambda, DynamoDB などについても同様に AWS CLI を使ってあらゆる操作を実行できる.

Amazon Resource Name (ARN)

AWS 上のあらゆるリソースには, Amazon Resource Name (ARN) という固有の ID が付与されている. ARN は arn:aws:s3:::my_bucket/ のようなフォーマットで記述され,ARN を使用することで,特定の AWS リソース (S3 のバケットや EC2 のインスタンス) を一意的に参照することができる.

S3 バケットや EC2 インスタンスなどには ARN に加えて,人間が読みやすい名前を定義することも可能である. この場合は,ARN または名前のどちらを用いても同じリソースを参照することが可能である.

CloudFormation と AWS CDK

CloudFormation による Infrastructure as Code (IaC)

前節で述べたように,AWS API を使うことでクラウドのあらゆるリソースの作成・管理が可能である. よって,原理上は, API のコマンドを組み合わせていくことで,自分の作りたいクラウドを設計することができる.

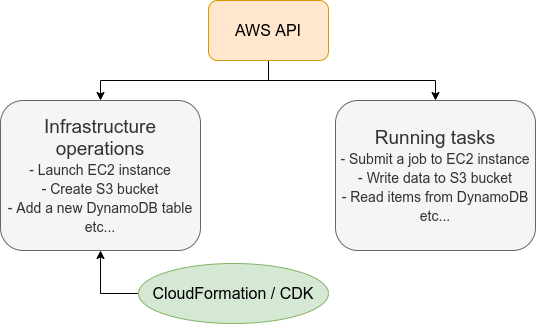

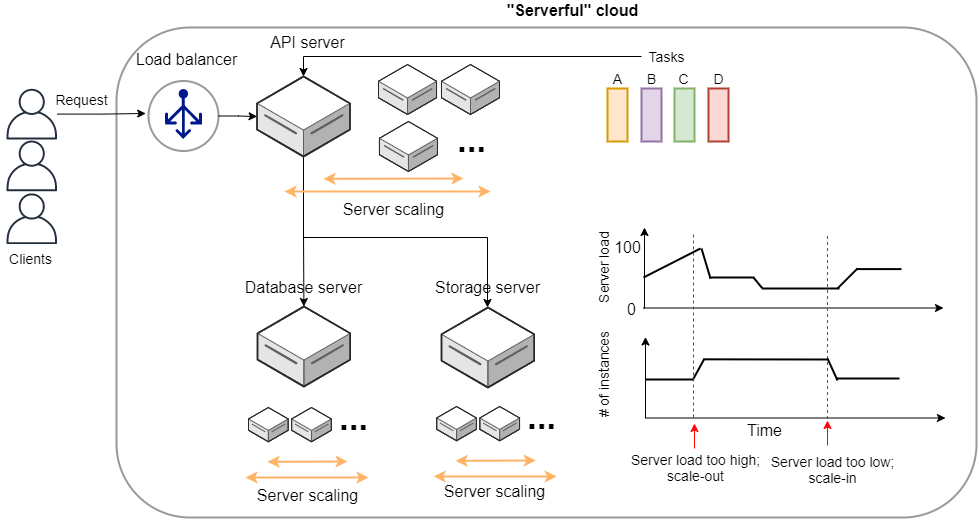

しかし,ここで実用上考慮しなければならない点が一つある. AWS API には大きく分けて,リソースを操作するコマンドと,タスクを実行するコマンドがあることである (figure_title).

リソースを操作するとは,EC2 のインスタンスを起動したり,S3 のバケットを作成したり,データベースに新たなテーブルを追加する,などの静的なリソースを準備する 操作を指す. "ハコ"を作る操作とよんでも良いだろう. このようなコマンドは,クラウドのデプロイ時にのみ,一度だけ実行されればよい.

タスクを実行するコマンド とは, EC2 のインスタンスにジョブを投入したり, S3 のバケットにデータを読み書きするなどの操作を指す. これは, EC2 や S3 などのリソース ("ハコ") を前提として,その内部で実行されるべき計算を記述するものである. 前者に比べてこちらは動的な操作を担当する,と捉えることもできる.

そのような観点から,インフラを記述するプログラムとタスクを実行するプログラムはある程度分けて管理されるべきである. クラウドの開発は,クラウドの(静的な)リソースを記述するプログラムを作成するステップと,インフラ上で動く動的な操作を行うプログラムを作成するステップの二段階に分けて考えることができる.

AWS での静的リソースを管理するための仕組みが, CloudFormation である. CloudFormation とは, CloudFormation の文法に従ったテキストファイルを使って,AWS のインフラを記述する仕組みである. CloudFormation を使って,たとえば,EC2 のインスタンスをどれくらいのスペックで,何個起動するか,インスタンス間はどのようなネットワークで結び,どのようなアクセス権限を付与するか,などのリソースの要件を逐次的に記述することができる. 一度 CloudFormation ファイルができ上がれば,それにしたがったクラウドシステムをコマンド一つで AWS 上に展開することができる. また,CloudFormation ファイルを交換することで,全く同一のクラウド環境を他者が簡単に再現することも可能になる. このように,本来は物理的な実体のあるハードウェアを,プログラムによって記述し,管理するという考え方を,**Infrastructure as Code (IaC)**とよぶ.

CloudFormation を記述するには,基本的に JSON (JavaScript Object Notation) とよばれるフォーマットを使う. 次のコードは,JSON で記述された CloudFormation ファイルの一例 (抜粋) である.

json

"Resources" : {

...

"WebServer": {

"Type" : "AWS::EC2::Instance",

"Properties": {

"ImageId" : { "Fn::FindInMap" : [ "AWSRegionArch2AMI", { "Ref" : "AWS::Region" },

{ "Fn::FindInMap" : [ "AWSInstanceType2Arch", { "Ref" : "InstanceType" }, "Arch" ] } ] },

"InstanceType" : { "Ref" : "InstanceType" },

"SecurityGroups" : [ {"Ref" : "WebServerSecurityGroup"} ],

"KeyName" : { "Ref" : "KeyName" },

"UserData" : { "Fn::Base64" : { "Fn::Join" : ["", [

"#!/bin/bash -xe\n",

"yum update -y aws-cfn-bootstrap\n",

"/opt/aws/bin/cfn-init -v ",

" --stack ", { "Ref" : "AWS::StackName" },

" --resource WebServer ",

" --configsets wordpress_install ",

" --region ", { "Ref" : "AWS::Region" }, "\n",

"/opt/aws/bin/cfn-signal -e $? ",

" --stack ", { "Ref" : "AWS::StackName" },

" --resource WebServer ",

" --region ", { "Ref" : "AWS::Region" }, "\n"

]]}}

},

...

},

...

},"Resources" : {

...

"WebServer": {

"Type" : "AWS::EC2::Instance",

"Properties": {

"ImageId" : { "Fn::FindInMap" : [ "AWSRegionArch2AMI", { "Ref" : "AWS::Region" },

{ "Fn::FindInMap" : [ "AWSInstanceType2Arch", { "Ref" : "InstanceType" }, "Arch" ] } ] },

"InstanceType" : { "Ref" : "InstanceType" },

"SecurityGroups" : [ {"Ref" : "WebServerSecurityGroup"} ],

"KeyName" : { "Ref" : "KeyName" },

"UserData" : { "Fn::Base64" : { "Fn::Join" : ["", [

"#!/bin/bash -xe\n",

"yum update -y aws-cfn-bootstrap\n",

"/opt/aws/bin/cfn-init -v ",

" --stack ", { "Ref" : "AWS::StackName" },

" --resource WebServer ",

" --configsets wordpress_install ",

" --region ", { "Ref" : "AWS::Region" }, "\n",

"/opt/aws/bin/cfn-signal -e $? ",

" --stack ", { "Ref" : "AWS::StackName" },

" --resource WebServer ",

" --region ", { "Ref" : "AWS::Region" }, "\n"

]]}}

},

...

},

...

},ここでは, "WebServer" という名前のつけられた EC2 インスタンスを定義している.かなり長大で複雑な記述であるが,これによって所望のスペック・OS をもつ EC2 インスタンスを自動的に生成することが可能になる.

AWS CDK

前節で紹介した CloudFormation は,見てわかるとおり大変記述が複雑であり,またそれのどれか一つにでも誤りがあってはいけない. また,基本的に"テキスト"を書いていくことになるので,プログラミング言語で使うような変数やクラスといった便利な概念が使えない (厳密には, CloudFormation にも変数に相当するような機能は存在する). また,記述の多くの部分は繰り返しが多く,自動化できる部分も多い.

そのような悩みを解決してくれるのが, AWS Cloud Development Kit (CDK) である. CDK は Python などのプログラミング言語を使って CloudFormation を自動的に生成してくれるツールである. CDK は 2019 年にリリースされたばかりの比較的新しいツールで,日々改良が進められている (GitHub リポジトリ のリリースを見ればその開発のスピードの速さがわかるだろう). CDK は TypeScript (JavaScript), Python, Java など複数の言語でサポートされている.

CDK を使うことで,CloudFormation に相当するクラウドリソースの記述を,より親しみのあるプログラミング言語を使って行うことができる. かつ,典型的なリソース操作に関してはパラメータの多くの部分を自動で決定してくれるので,記述しなければならない量もかなり削減される.

以下に Python を使った CDK のコードの一例 (抜粋) を示す.

python

from aws_cdk import (

core,

aws_ec2 as ec2,

)

class MyFirstEc2(core.Stack):

def __init__(self, scope, name, **kwargs):

super().__init__(scope, name, **kwargs)

vpc = ec2.Vpc(

... # some parameters

)

sg = ec2.SecurityGroup(

... # some parameters

)

host = ec2.Instance(

self, "MyGreatEc2",

instance_type=ec2.InstanceType("t2.micro"),

machine_image=ec2.MachineImage.latest_amazon_linux(),

vpc=vpc,

...

)from aws_cdk import (

core,

aws_ec2 as ec2,

)

class MyFirstEc2(core.Stack):

def __init__(self, scope, name, **kwargs):

super().__init__(scope, name, **kwargs)

vpc = ec2.Vpc(

... # some parameters

)

sg = ec2.SecurityGroup(

... # some parameters

)

host = ec2.Instance(

self, "MyGreatEc2",

instance_type=ec2.InstanceType("t2.micro"),

machine_image=ec2.MachineImage.latest_amazon_linux(),

vpc=vpc,

...

)このコードは,一つ前に示した JSON を使った CloudFormation と実質的に同じことを記述している. とても煩雑だった CloudFormation ファイルに比べて, CDK と Python を使うことで格段に短く,わかりやすく記述できることができるのがわかるだろう.

本書の主題は,CDK を使って,コードを書きながら AWS の概念や開発方法を学んでいくことである. 後の章では CDK を使って様々なハンズオンを実施していく. 早速,最初のハンズオンでは, CDK を使って EC2 インスタンスを作成する方法を学んでいこう.

- AWS CDK Examples: CDK を使ったプロジェクトの例が多数紹介されている. ここにある例をテンプレートに自分のアプリケーションの開発を進めるとよい.

Hands-on #1: 初めての EC2 インスタンスを起動する

ハンズオンの第一回では, CDK を使って EC2 のインスタンス(仮想サーバー)を作成し,SSH でサーバーにログインする,という演習を行う. このハンズオンを終えれば,あなたは自分だけのサーバーを AWS 上に立ち上げ,自由に計算を走らせることができるようになるのである!

準備

ハンズオンのソースコードは GitHub の handson/ec2-get-started に置いてある.

このハンズオンは,基本的に AWS の無料枠 の範囲内で実行することができる.

まずは,ハンズオンを実行するための環境を整える. これらの環境整備は,後のハンズオンでも前提となるものなので確実にミスなく行っていただきたい.

- AWS Account: ハンズオンを実行するには個人の AWS アカウントが必要である. AWS アカウントの取得については AWS アカウントの取得 を参照のこと.

- Python と Node.js: 本ハンズオンを実行するには,Python (3.6 以上),Node.js (12.0 以上) がインストールされていなければならない.

- AWS CLI: AWS CLI のインストールについては, AWS CLI のインストール を参照. ここに記載されている認証鍵の設定も済ませておくこと.

- AWS CDK: AWS CDK のインストールについては, AWS CDK のインストール を参照.

- ソースコードのダウンロード: 本ハンズオンで使用するプログラムのソースコードを,以下のコマンドを使って GitHub からダウンロードする.

sh

$ git clone https://github.com/tomomano/learn-aws-by-coding.git$ git clone https://github.com/tomomano/learn-aws-by-coding.gitあるいは, https://github.com/tomomano/learn-aws-by-coding のページに行って,右上のダウンロードボタンからダウンロードすることもできる.

Docker を使用する場合

Python, Node.js, AWS CDK など,ハンズオンのプログラムを実行するために必要なプログラム/ライブラリがインストール済みの Docker image を用意した. また,ハンズオンのソースコードもパッケージ済みである. Docker の使い方を知っている読者は,これを使えば,諸々のインストールをする必要なく,すぐにハンズオンのプログラムを実行できる.

使用方法については ハンズオン実行用の Docker image の使い方 を参照のこと.

SSH

SSH (secure shell) は Unix 系のリモートサーバーに安全にアクセスするためのツールである. 本ハンズオンでは, SSH を使って仮想サーバーにアクセスする. SSH に慣れていない読者のため,簡単な説明をここで行おう.

SSH による通信はすべて暗号化されているので,機密情報をインターネットを介して安全に送受信することができる. 本ハンズオンで,リモートのサーバーにアクセスするための SSH クライアントがローカルマシンにインストールされている必要がある. SSH クライアントは Linux/Mac には標準搭載されている. Windows の場合は WSL をインストールすることで SSH クライアントを利用することを推奨する (環境構築 を参照).

SSH コマンドの基本的な使い方を次に示す. <host name> はアクセスする先のサーバーの IP アドレスや DNS によるホストネームが入る. <user name> は接続する先のユーザー名である.

sh

$ ssh <user name>@<host name>$ ssh <user name>@<host name>SSH は平文のパスワードによる認証を行うこともできるが,より強固なセキュリティを施すため,公開鍵暗号方式(Public Key Cryptography)による認証を行うことが強く推奨されており, EC2 はこの方法でしかアクセスを許していない. 公開鍵暗号方式の仕組みについては各自勉強してほしい. 本ハンズオンにおいて大事なことは,EC2 インスタンスが公開鍵(Public key)を保持し,クライアントとなるコンピュータ(読者自身のコンピュータ)が秘密鍵(Private key)を保持する,という点である. EC2 のインスタンスには秘密鍵を持ったコンピュータのみがアクセスすることができる.逆に言うと,秘密鍵が漏洩すると第三者もサーバーにアクセスできることになるので,秘密鍵は絶対に漏洩することのないよう注意して管理する.

SSH コマンドでは,ログインのために使用する秘密鍵ファイルを -i もしくは --identity_file のオプションで指定することができる. たとえば,次のように使う.

sh

$ ssh -i Ec2SecretKey.pem <user name>@<host name>$ ssh -i Ec2SecretKey.pem <user name>@<host name>アプリケーションの説明

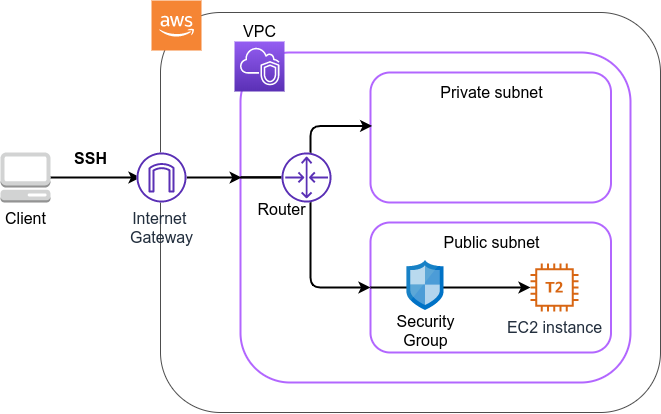

このハンズオンで作成するアプリケーションの概要を figure_title に示す.

このアプリケーションではまず,VPC (Virtual Private Cloud) を使ってプライベートな仮想ネットワーク環境を立ち上げている. その VPC の public subnet の内側に,EC2 (Elatic Compute Cloud) の仮想サーバーを配置する. さらに,セキュリティのため, Security Group による EC2 インスタンスへのアクセス制限を設定している. このようにして作成された仮想サーバーに,SSH を使ってアクセスし,簡単な計算を行う.

figure_title のようなアプリケーションを,CDK を使って構築する.

早速ではあるが,今回のハンズオンで使用するプログラムを見てみよう (handson/ec2-get-started/app.py).

python

class MyFirstEc2(core.Stack):

def __init__(self, scope: core.App, name: str, key_name: str, **kwargs) -> None:

super().__init__(scope, name, **kwargs)

#

vpc = ec2.Vpc(

self, "MyFirstEc2-Vpc",

max_azs=1,

cidr="10.10.0.0/23",

subnet_configuration=[

ec2.SubnetConfiguration(

name="public",

subnet_type=ec2.SubnetType.PUBLIC,

)

],

nat_gateways=0,

)

#

sg = ec2.SecurityGroup(

self, "MyFirstEc2Vpc-Sg",

vpc=vpc,

allow_all_outbound=True,

)

sg.add_ingress_rule(

peer=ec2.Peer.any_ipv4(),

connection=ec2.Port.tcp(22),

)

#

host = ec2.Instance(

self, "MyFirstEc2Instance",

instance_type=ec2.InstanceType("t2.micro"),

machine_image=ec2.MachineImage.latest_amazon_linux(),

vpc=vpc,

vpc_subnets=ec2.SubnetSelection(subnet_type=ec2.SubnetType.PUBLIC),

security_group=sg,

key_name=key_name

)class MyFirstEc2(core.Stack):

def __init__(self, scope: core.App, name: str, key_name: str, **kwargs) -> None:

super().__init__(scope, name, **kwargs)

#

vpc = ec2.Vpc(

self, "MyFirstEc2-Vpc",

max_azs=1,

cidr="10.10.0.0/23",

subnet_configuration=[

ec2.SubnetConfiguration(

name="public",

subnet_type=ec2.SubnetType.PUBLIC,

)

],

nat_gateways=0,

)

#

sg = ec2.SecurityGroup(

self, "MyFirstEc2Vpc-Sg",

vpc=vpc,

allow_all_outbound=True,

)

sg.add_ingress_rule(

peer=ec2.Peer.any_ipv4(),

connection=ec2.Port.tcp(22),

)

#

host = ec2.Instance(

self, "MyFirstEc2Instance",

instance_type=ec2.InstanceType("t2.micro"),

machine_image=ec2.MachineImage.latest_amazon_linux(),

vpc=vpc,

vpc_subnets=ec2.SubnetSelection(subnet_type=ec2.SubnetType.PUBLIC),

security_group=sg,

key_name=key_name

)まず最初に,VPC を定義する.

次に, security group (SG) を定義している. ここでは,任意の IPv4 のアドレスからの,ポート 22 (SSH の接続に使用される)への接続を許可している. それ以外の接続は拒絶される.

最後に,上記で作った VPC と SG が付与された EC2 インスタンスを作成している. インスタンスタイプは

t2.microを選択し, Amazon Linux を OS として設定している.

それぞれについて,もう少し詳しく説明しよう.

VPC (Virtual Private Cloud)

VPC のアイコン.

VPC は AWS 上にプライベートな仮想ネットワーク環境を構築するツールである.高度な計算システムを構築するには,複数のサーバーを連動させて計算を行う必要があるが,そのような場合に互いのアドレスなどを管理する必要があり,そういった目的で VPC は有用である.

本ハンズオンでは,サーバーは一つしか起動しないので,VPC の恩恵はよく分からないかもしれない.しかし,EC2 インスタンスは必ず VPC の中に配置されなければならない,という制約があるので,このハンズオンでもミニマルな VPC を構成している.

興味のある読者のために,VPC のコードについてもう少し詳しく説明しよう.

python

vpc = ec2.Vpc(

self, "MyFirstEc2-Vpc",

max_azs=1,

cidr="10.10.0.0/23",

subnet_configuration=[

ec2.SubnetConfiguration(

name="public",

subnet_type=ec2.SubnetType.PUBLIC,

)

],

nat_gateways=0,

)vpc = ec2.Vpc(

self, "MyFirstEc2-Vpc",

max_azs=1,

cidr="10.10.0.0/23",

subnet_configuration=[

ec2.SubnetConfiguration(

name="public",

subnet_type=ec2.SubnetType.PUBLIC,

)

],

nat_gateways=0,

)max_azs=1: このパラメータは,前章で説明した avaialibility zone (AZ) を設定している. このハンズオンでは,特にデータセンターの障害などを気にする必要はないので1にしている.cidr="10.10.0.0/23": このパラメータは,VPC 内の IPv4 のレンジを指定している. CIDR 記法については, Wikipediaなどを参照.10.10.0.0/23は10.10.0.0から10.10.1.255までの 512 個の連続したアドレス範囲を指している. つまり,この VPC では最大で 512 個のユニークな IPv4 アドレスが使えることになる. 今回はサーバーは一つなので 512 個は明らかに多すぎるが,VPC はアドレスの数はどれだけ作成しても無料なので,多めに作成した.subnet_configuration=...: このパラメータは,VPC にどのようなサブネットを作るか,を決めている. サブネットの種類には private subnet と public subnet の二種類がある. private subnet は基本的にインターネットとは遮断されたサブネット環境である. インターネットと繋がっていないので,セキュリティは極めて高く, VPC 内のサーバーとのみ通信を行えばよい EC2 インスタンスはここに配置する. Public subnet とはインターネットに繋がったサブネットである. 本ハンズオンで作成するサーバーは,外から SSH でログインを行いたいので, Public subnet 内に配置する. より詳細な記述は 公式ドキュメンテーション を参照.natgateways=0: これは少し高度な内容なので省略する (興味のある読者は 公式ドキュメンテーションを参照). が,これを 0 にしておかないと,NAT Gateway の利用料金が発生してしまうので,注意!

Security Group

Security group (SG) は, EC2 インスタンスに付与することのできる仮想ファイアーウォールである. たとえば,特定の IP アドレスから来た接続を許可・拒絶したり (インバウンド・トラフィックの制限) ,逆に特定の IP アドレスへのアクセスを禁止したり (アウトバウンド・トラフィックの制限) することができる.

コードの該当部分を見てみよう.

python

sg = ec2.SecurityGroup(

self, "MyFirstEc2Vpc-Sg",

vpc=vpc,

allow_all_outbound=True,

)

sg.add_ingress_rule(

peer=ec2.Peer.any_ipv4(),

connection=ec2.Port.tcp(22),

)sg = ec2.SecurityGroup(

self, "MyFirstEc2Vpc-Sg",

vpc=vpc,

allow_all_outbound=True,

)

sg.add_ingress_rule(

peer=ec2.Peer.any_ipv4(),

connection=ec2.Port.tcp(22),

)本ハンズオンでは, SSH による外部からの接続を許容するため, sg.add_ingress_rule(peer=ec2.Peer.any_ipv4(), connection=ec2.Port.tcp(22)) により,すべての IPv4 アドレスからのポート 22 番へのアクセスを許容している. また, SSH で EC2 インスタンスにログインしたのち,インターネットからプログラムなどをダウンロードできるよう, allow_all_outbound=True のパラメータを設定している.

SSH はデフォルトでは 22 番ポートを使用するのが慣例である.

セキュリティ上の観点からは,SSH の接続は自宅や大学・職場など特定の地点からの接続のみを許す方が望ましい.

EC2 (Elastic Compute Cloud)

EC2 のアイコン.

EC2 は AWS 上に仮想サーバーを立ち上げるサービスである. 個々の起動状態にある仮想サーバーのことをインスタンス (instance) とよぶ (しかし,口語的なコミュニケーションにおいては,サーバーとインスタンスという言葉は相互互換的に用いられることが多い).

EC2 では用途に応じて様々なインスタンスタイプが提供されている. table_title に,代表的なインスタンスタイプの例を挙げる (執筆時点での情報). EC2 のインスタンスタイプのすべてのリストは 公式ドキュメンテーション "Amazon EC2 Instance Types" で見ることができる.

| Instance | vCPU | Memory (GiB) | Network bandwidth (Gbps) | Price per hour ($) |

|---|---|---|---|---|

t2.micro | 1 | 1 | - | 0.0116 |

t2.small | 1 | 2 | - | 0.023 |

t2.medium | 2 | 4 | - | 0.0464 |

c5.24xlarge | 96 | 192 | 25 | 4.08 |

c5n.18xlarge | 72 | 192 | 100 | 3.888 |

x1e.16xlarge | 64 | 1952 | 10 | 13.344 |

table_title からわかるように, CPU は 1 コアから 96 コアまで,メモリーは 1GB から 2TB 以上まで,ネットワーク帯域は最大で 100Gbps まで,幅広く選択することができる. また,時間あたりの料金は,CPU・メモリーの占有数にほぼ比例する形で増加する. EC2 はサーバーの起動時間を秒単位で記録しており,利用料金は使用時間に比例する形で決定される. 例えば, t2.medium のインスタンスを 10 時間起動した場合,0.0464 * 10 = 0.464 ドルの料金が発生する.

AWS には 無料利用枠 というものがあり, t2.micro であれば月に 750 時間までは無料で利用することができる.

table_title の価格は us-east-1 のものである. リージョンによって多少価格設定が異なる.

上記で t2.micro の $0.0116 / hour という金額は, On-demand インスタンスというタイプを選択した場合の価格である. EC2 ではほかに, Spot instance とよばれるインスタンスも存在しする. Spot instance は,AWS のデータセンターの負荷が増えた場合,ユーザーのプログラムが実行中であっても AWS の判断により強制シャットダウンされる,という不便さを抱えているのだが,その分大幅に安い料金設定になっている. AWS で一時的に生じた余剰な空き CPU をユーザーに割安で貸し出す,という発想である. 科学計算やウェブサーバーなどの用途でコストを削減する目的で, Spot Instance を活用する事例も多数報告されている.

EC2 インスタンスを定義しているコードの該当部分を見てみよう.

python

host = ec2.Instance(

self, "MyFirstEc2Instance",

instance_type=ec2.InstanceType("t2.micro"),

machine_image=ec2.MachineImage.latest_amazon_linux(),

vpc=vpc,

vpc_subnets=ec2.SubnetSelection(subnet_type=ec2.SubnetType.PUBLIC),

security_group=sg,

key_name=key_name

)host = ec2.Instance(

self, "MyFirstEc2Instance",

instance_type=ec2.InstanceType("t2.micro"),

machine_image=ec2.MachineImage.latest_amazon_linux(),

vpc=vpc,

vpc_subnets=ec2.SubnetSelection(subnet_type=ec2.SubnetType.PUBLIC),

security_group=sg,

key_name=key_name

)ここでは, t2.micro というインスタンスタイプを選択している. さらに, machine_image として, Amazon Linux を選択している (Machine image は OS と似た概念である. Machine image については, Hands-on #2: AWS でディープラーニングを実践 でより詳しく触れる). さらに,上で定義した VPC, SG をこのインスタンスに付与している.

以上が,今回使用するプログラムの簡単な解説であった. ミニマルな形のプログラムではあるが,仮想サーバーを作成するのに必要なステップがおわかりいただけただろうか?

プログラムを実行する

さて,ハンズオンのコードの理解ができたところで,プログラムを実際に実行してみよう.繰り返しになるが, 準備 での準備ができていることが前提である.

Python の依存ライブラリのインストール

まずは,Python の依存ライブラリをインストールする.以下では,Python のライブラリを管理するツールとして, venv を使用する.

まずは, handson/ec2-get-started のディレクトリに移動しよう.

sh

$ cd handson/ec2-get-started$ cd handson/ec2-get-startedディレクトリを移動したら, venv で新しい仮想環境を作成し,インストールを実行する.

sh

$ python3 -m venv .env

$ source .env/bin/activate

$ pip install -r requirements.txt$ python3 -m venv .env

$ source .env/bin/activate

$ pip install -r requirements.txtこれで Python の環境構築は完了だ.

venv の簡単な説明は Python クイックガイド に記述してある.

環境によっては pip ではなく pip3 あるいは python3 -m pip に置き換える必要がある.

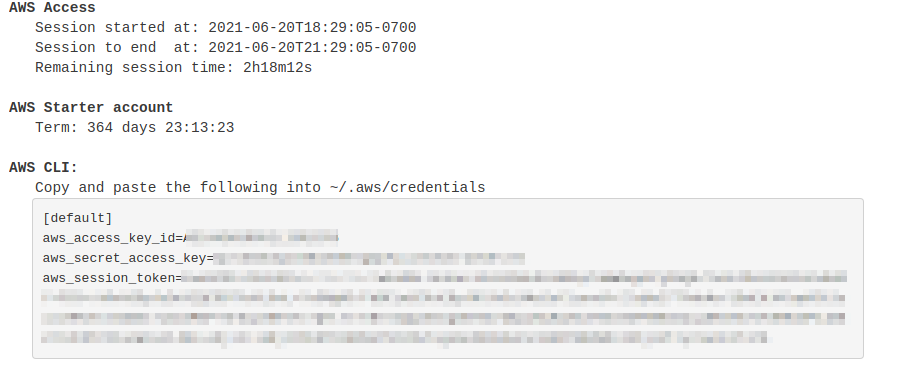

AWS のシークレットキーをセットする

AWS CLI および AWS CDK を使うには, AWS のシークレットキーが設定されている必要がある. シークレットキーの発行については AWS のシークレットキーの作成 を参照のこと. シークレットキーを発行したら, AWS CLI のインストール を参照し,コマンドラインの設定を行う.

手順をここに短く要約すると,一つ目の方法は AWS_ACCESS_KEY_ID などの環境変数を設定するやり方である. もう一つの方法は, ~/.aws/credentials に認証情報を保存しておく方式である. シークレットキーの設定は AWS CLI/CDK を使用するうえで共通のステップになるので,しっかりと理解しておくように.

SSH 鍵を生成

EC2 インスタンスには SSH を使ってログインする. EC2 インスタンスを作成するのに先行して,今回のハンズオンで専用に使う SSH の公開鍵・秘密鍵のペアを準備する必要がある.

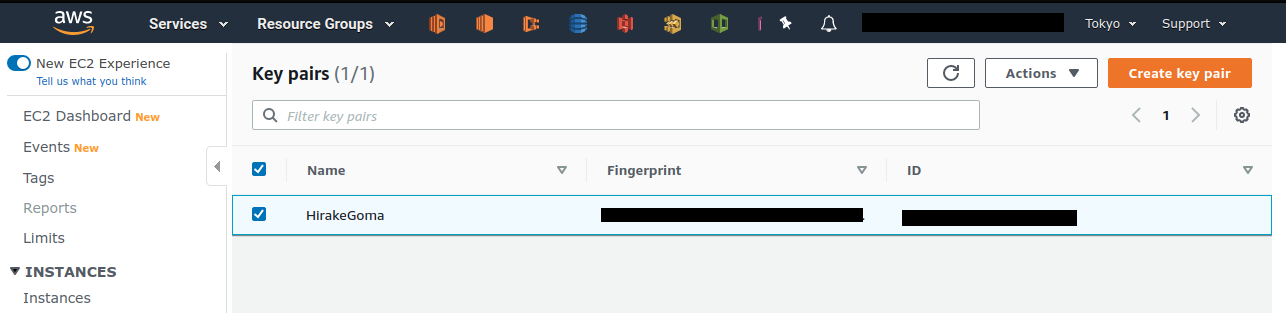

次の AWS CLI コマンドにより, HirakeGoma という名前のついた鍵を生成する.

sh

$ export KEY_NAME="HirakeGoma"

$ aws ec2 create-key-pair --key-name ${KEY_NAME} --query 'KeyMaterial' --output text > ${KEY_NAME}.pem$ export KEY_NAME="HirakeGoma"

$ aws ec2 create-key-pair --key-name ${KEY_NAME} --query 'KeyMaterial' --output text > ${KEY_NAME}.pemこのコマンドを実行すると,現在のディレクトリに HirakeGoma.pem というファイルが作成される.これが,サーバーにアクセスするための秘密鍵である. SSH でこの鍵を使うため, ~/.ssh/ のディレクトリに鍵を移動する. さらに,秘密鍵が書き換えられたり第三者に閲覧されないよう,ファイルのアクセス権限を 400 に設定する.

sh

$ mv HirakeGoma.pem ~/.ssh/

$ chmod 400 ~/.ssh/HirakeGoma.pem$ mv HirakeGoma.pem ~/.ssh/

$ chmod 400 ~/.ssh/HirakeGoma.pemデプロイを実行

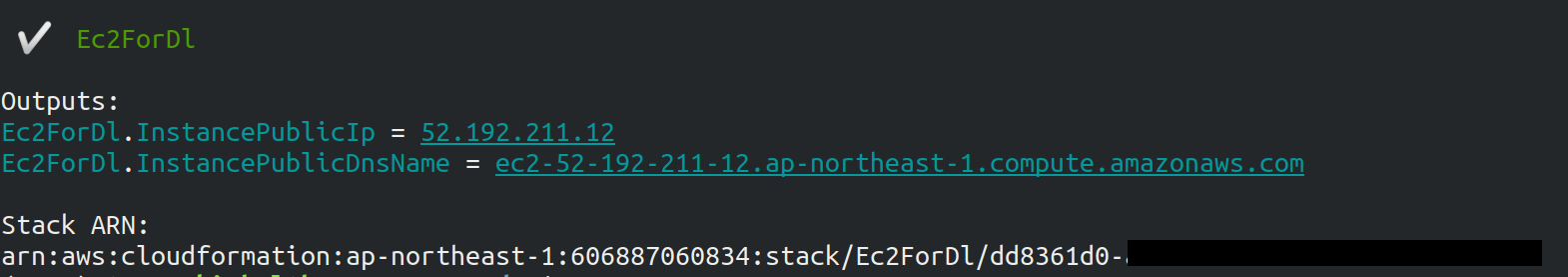

これまでのステップで, EC2 インスタンスをデプロイするための準備が整った! 早速,次のコマンドによりアプリケーションを AWS にデプロイしよう. -c key_name="HirakeGoma" というオプションで,先ほど生成した HirakeGoma という名前の鍵を使うよう指定している.

sh

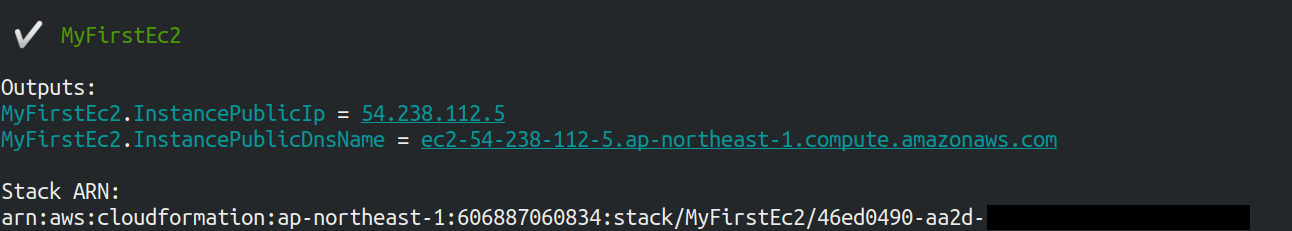

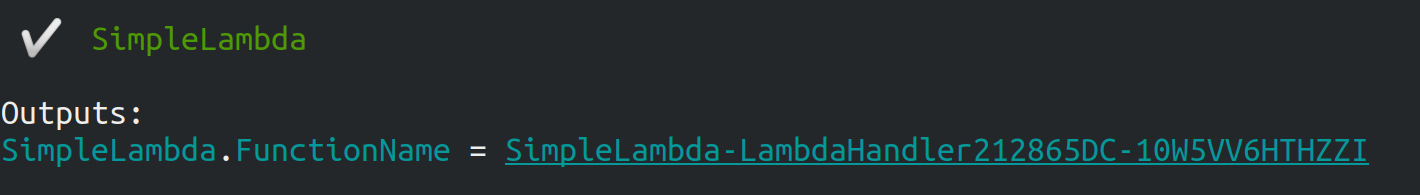

$ cdk deploy -c key_name="HirakeGoma"$ cdk deploy -c key_name="HirakeGoma"このコマンドを実行すると, VPC, EC2 などが AWS 上に展開される. そして,コマンドの出力の最後に figure_title のような出力が得られるはずである. 出力の中で InstancePublicIp に続く数字が,起動したインスタンスのパブリック IP アドレスである. IP アドレスはデプロイごとにランダムなアドレスが割り当てられる.

SSH でログイン

早速,SSH で接続してみよう.

sh

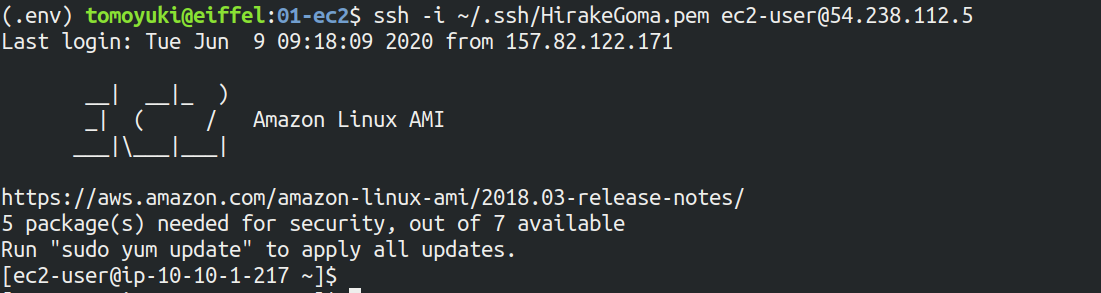

$ ssh -i ~/.ssh/HirakeGoma.pem ec2-user@<IP address>$ ssh -i ~/.ssh/HirakeGoma.pem ec2-user@<IP address>-i オプションで,先ほど生成した秘密鍵を指定している. EC2 インスタンスにはデフォルトで ec2-user という名前のユーザーが作られているので,それを使用する. 最後に, <IP address> の部分は自身が作成した EC2 インスタンスの IP アドレスで置き換える (12.345.678.9 など).

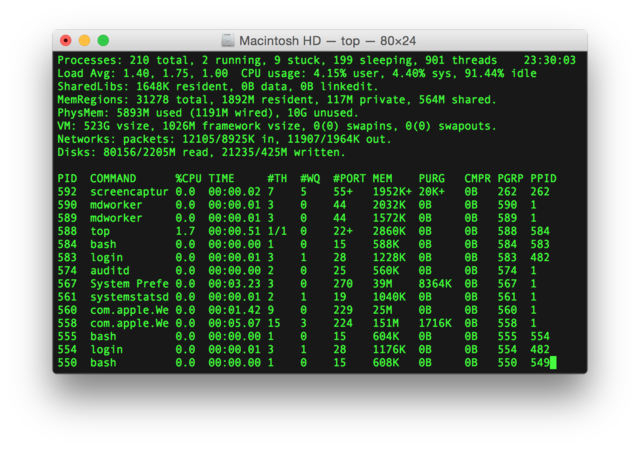

ログインに成功すると, figure_title のような画面が表示される. リモートのサーバーにログインしているので,プロンプトが [ec2-user@ip-10-10-1-217 ~]$ のようになっていることを確認しよう.

おめでとう!これで,めでたく AWS 上に EC2 仮想サーバーを起動し,リモートからアクセスできるようになった!

起動した EC2 インスタンスで遊んでみる

せっかく新しいインスタンスを起動したので,少し遊んでみよう.

ログインした EC2 インスタンスで,次のコマンドを実行してみよう. CPU の情報を取得することができる.

sh

$ cat /proc/cpuinfo

processor : 0

vendor_id : GenuineIntel

cpu family : 6

model : 63

model name : Intel(R) Xeon(R) CPU E5-2676 v3 @ 2.40GHz

stepping : 2

microcode : 0x43

cpu MHz : 2400.096

cache size : 30720 KB$ cat /proc/cpuinfo

processor : 0

vendor_id : GenuineIntel

cpu family : 6

model : 63

model name : Intel(R) Xeon(R) CPU E5-2676 v3 @ 2.40GHz

stepping : 2

microcode : 0x43

cpu MHz : 2400.096

cache size : 30720 KB次に,実行中のプロセスやメモリの消費を見てみよう.

sh

$ top -n 1

top - 09:29:19 up 43 min, 1 user, load average: 0.00, 0.00, 0.00

Tasks: 76 total, 1 running, 51 sleeping, 0 stopped, 0 zombie

Cpu(s): 0.3%us, 0.3%sy, 0.1%ni, 98.9%id, 0.2%wa, 0.0%hi, 0.0%si, 0.2%st

Mem: 1009140k total, 270760k used, 738380k free, 14340k buffers

Swap: 0k total, 0k used, 0k free, 185856k cached

PID USER PR NI VIRT RES SHR S %CPU %MEM TIME+ COMMAND

1 root 20 0 19696 2596 2268 S 0.0 0.3 0:01.21 init

2 root 20 0 0 0 0 S 0.0 0.0 0:00.00 kthreadd

3 root 20 0 0 0 0 I 0.0 0.0 0:00.00 kworker/0:0$ top -n 1

top - 09:29:19 up 43 min, 1 user, load average: 0.00, 0.00, 0.00

Tasks: 76 total, 1 running, 51 sleeping, 0 stopped, 0 zombie

Cpu(s): 0.3%us, 0.3%sy, 0.1%ni, 98.9%id, 0.2%wa, 0.0%hi, 0.0%si, 0.2%st

Mem: 1009140k total, 270760k used, 738380k free, 14340k buffers

Swap: 0k total, 0k used, 0k free, 185856k cached

PID USER PR NI VIRT RES SHR S %CPU %MEM TIME+ COMMAND

1 root 20 0 19696 2596 2268 S 0.0 0.3 0:01.21 init

2 root 20 0 0 0 0 S 0.0 0.0 0:00.00 kthreadd

3 root 20 0 0 0 0 I 0.0 0.0 0:00.00 kworker/0:0t2.micro インスタンスなので, 1009140k = 1GB のメモリーがあることがわかる.

今回起動したインスタンスには Python 2 はインストール済みだが, Python 3 は入っていない. Python 3.6 のインストールを行ってみよう. インストールは簡単である.

sh

$ sudo yum update -y

$ sudo yum install -y python36$ sudo yum update -y

$ sudo yum install -y python36インストールした Python を起動してみよう.

sh

$ python3

Python 3.6.10 (default, Feb 10 2020, 19:55:14)

[GCC 4.8.5 20150623 (Red Hat 4.8.5-28)] on linux

Type "help", "copyright", "credits" or "license" for more information.

>>>$ python3

Python 3.6.10 (default, Feb 10 2020, 19:55:14)

[GCC 4.8.5 20150623 (Red Hat 4.8.5-28)] on linux

Type "help", "copyright", "credits" or "license" for more information.

>>>Python のインタープリタが起動した! Ctrl + D あるいは exit() と入力することで,インタープリタを閉じることができる.

さて,サーバーでのお遊びはこんなところにしておこう (興味があれば各自いろいろと試してみると良い) . 次のコマンドでログアウトする.

sh

$ exit$ exitAWS コンソールから確認

これまでは,すべてコマンドラインから EC2 に関連する操作を行ってきた. EC2 インスタンスの状態を確認したり,サーバーをシャットダウンするなどの操作は,AWS コンソールから実行することもできる. 軽くこれを紹介しよう.

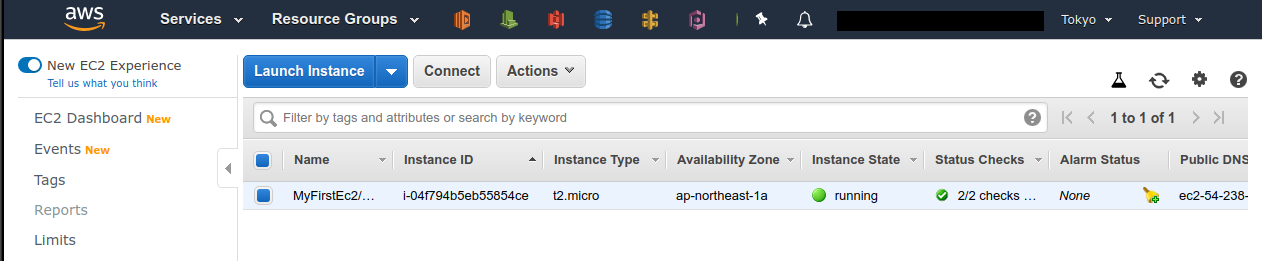

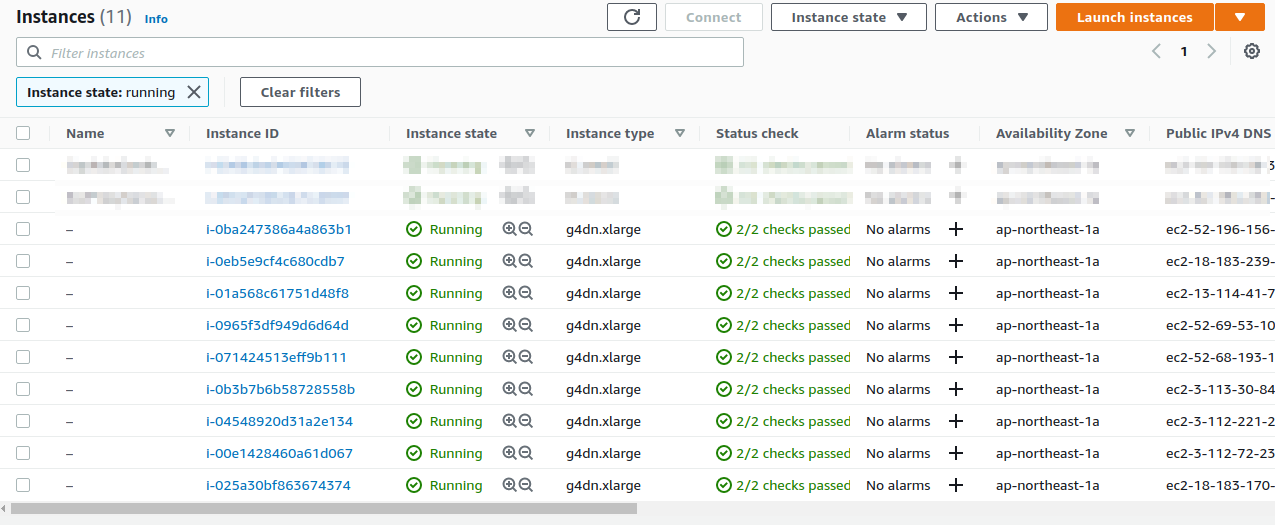

まず,ウェブブラウザを開いて AWS コンソールにログインする. ログインしたら, Services から EC2 を検索(選択)する. 次に,左のサイドバーの Instances とページをたどる. すると, figure_title のような画面が得られるはずである. この画面で,自分のアカウントの管理下にあるインスタンスを確認できる. 同様に,VPC・SG についてもコンソールから確認できる.

コンソール右上で,正しいリージョン (今回の場合は ap-northeast-1, Tokyo) が選択されているか,注意する!

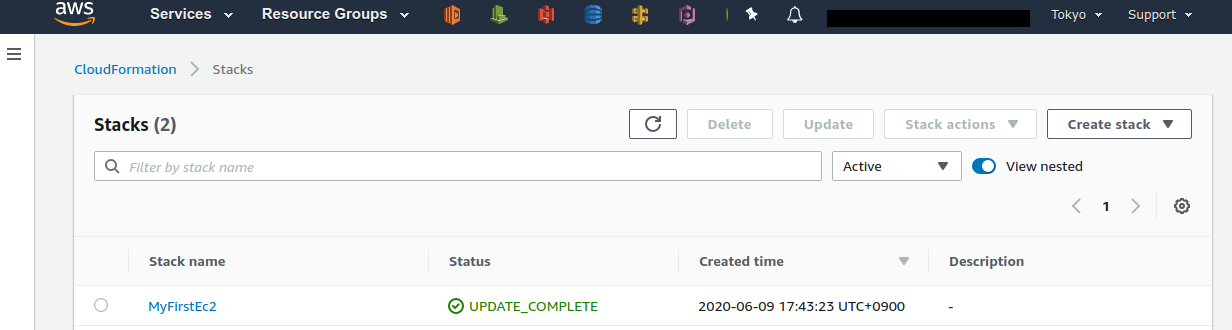

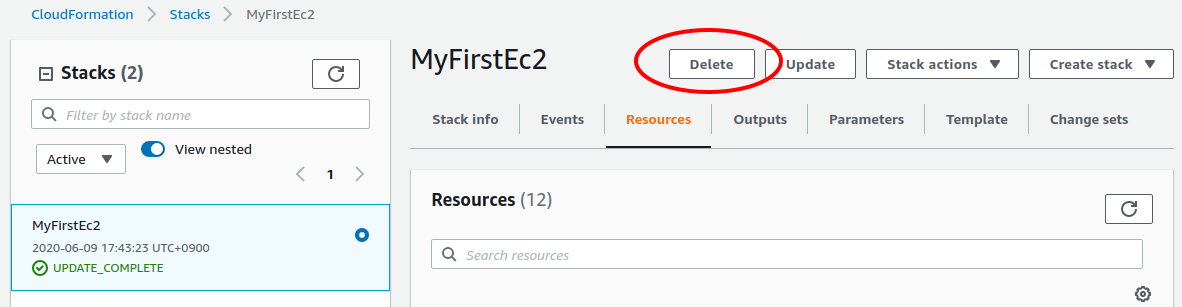

前章で CloudFormation について触れたが,今回デプロイしたアプリケーションも,CloudFormation のスタックとして管理されている. スタック (stack) とは, AWS リソースの集合のことを指す. 今回の場合は, VPC/EC2/SG などがスタックの中に含まれている. コンソールで CloudFormation のページに行ってみよう (figure_title).

"MyFirstEc2" という名前のスタックがあることが確認できる. クリックをして中身を見てみると,EC2, VPC などのリソースがこのスタックに紐付いていることがわかる.

スタックを削除

これにて,第一回のハンズオンで説明すべき事柄はすべて完了した. 最後に,使わなくなったスタックを削除しよう. スタックの削除には,二つの方法がある.

一つ目の方法は,前節の Cloudformation のコンソール画面で, "Delete" ボタンを押すことである (figure_title). すると,スタックの状態が "DELETE_IN_PROGRESS" に変わり,削除が完了すると CloudFormation のスタックの一覧から消える.

二つ目の方法は,コマンドラインから行う方法である. 先ほど,デプロイを行ったコマンドラインに戻ろう. そうしたら,次のコマンドを実行する.

sh

$ cdk destroy$ cdk destroyこのコマンドを実行すると,スタックの削除が始まる. 削除した後は,VPC, EC2 など,すべて跡形もなく消え去っていることを自身で確かめよう. CloudFormation を用いることで関連するすべての AWS リソースを一度に管理・削除することができるので,大変便利である.

スタックの削除は各自で必ず行うこと! 行わなかった場合, EC2 インスタンスの料金が発生し続けることになる!

また,本ハンズオンのために作成した SSH 鍵ペアも不要なので,削除しておく. まず, EC2 側に登録してある公開鍵を削除する. これも,コンソールおよびコマンドラインの二つの方法で実行できる.

コンソールから実行するには, EC2 の画面に行き,左のサイドバーの Key Pairs を選択する. 鍵の一覧が表示されるので, HirakeGoma とある鍵にチェックを入れ,画面右上の Actions から, Delete を実行する (figure_title).

コマンドラインから実行するには,次のコマンドを使う.

sh

$ aws ec2 delete-key-pair --key-name "HirakeGoma"$ aws ec2 delete-key-pair --key-name "HirakeGoma"最後に,ローカルのコンピュータから鍵を削除する.

sh

$ rm -f ~/.ssh/HirakeGoma.pem$ rm -f ~/.ssh/HirakeGoma.pemこれで,クラウドの片付けもすべて終了だ.

なお,頻繁に EC2 インスタンスを起動したりする場合は,いちいち SSH 鍵を削除する必要はない.

小括

ここまでが,本書の第一部の内容である. 盛りだくさんの内容であったが,ついてこれたであろうか?

クラウド概論 では,クラウドの定義と用語の説明を行ったあと,なぜクラウドを使うのか,という点を議論した. 続いて AWS 入門 では,クラウドを学ぶ具体的なプラットフォームとして AWS を取り上げ, AWS を使用するにあたり最低限必要な知識と用語の説明を行った. さらに, Hands-on #1: 初めての EC2 インスタンスを起動する のハンズオンでは AWS CLI と AWS CDK を使って,自身のプライベートなサーバーを AWS 上に立ち上げる演習を行った.

これらを通じて,いかに簡単に (たった数行のコマンドで!) 仮想サーバーを立ち上げたり,削除したりすることができるか,体験できただろう. 筆者は,クラウド概論 でクラウドの最も重要な側面はダイナミックに計算リソースを拡大・縮小できることである,と述べた. この言葉の意味が,ハンズオンを通じてより明らかになっただろうか? ここで学んだ技術を少し応用するだけで,自分のウェブページをホストする仮想サーバーを作成したり,大量のコアを搭載した EC2 インスタンスを用意して科学計算を実行するなど,いろいろなアプリケーションが実現できる.

次章からは,今回学んだクラウドの技術を基に,より現実に即した問題を解くことを体験してもらう. お楽しみに!

クラウドで行う科学計算・機械学習

計算機が発達した現代では,計算機によるシミュレーションやビッグデータの解析は,科学・エンジニアリングの研究の主要な柱である. これらの大規模な計算を実行するには,クラウドは最適である. 本章から始まる第二部では,どのようにしてクラウド上で科学計算を実行するのかを,ハンズオンとともに体験してもらう. 科学計算の具体的な題材として,今回は機械学習(深層学習)を取り上げる.

なお,本書では PyTorch ライブラリを使って深層学習のアルゴリズムを実装するが,深層学習および PyTorch の知識は不要である. 講義ではなぜ・どうやって深層学習をクラウドで実行するかに主眼を置いているので,実行するプログラムの詳細には立ち入らない. 将来,自分で深層学習を使う機会が来たときに,詳しく学んでもらいたい.

なぜ機械学習をクラウドで行うのか?

2010 年頃に始まった第三次 AI ブームのおかげで,学術研究だけでなく社会・ビジネスの文脈でも機械学習に高い関心が寄せられている. とくに,深層学習 (ディープラーニング) とよばれる多層のレイヤーからなるニューラルネットワークを用いたアルゴリズムは,画像認識や自然言語処理などの分野で圧倒的に高い性能を実現し,革命をもたらしている.

深層学習の特徴は,なんといってもそのパラメータの多さである. 層が深くなるほど,層間のニューロンを結ぶ重みパラメータの数が増大していく. たとえば,最新の言語モデルである GPT-3 には1750 億個ものパラメータが含まれている. このような膨大なパラメータを有することで,深層学習は高い表現力と汎化性能を実現しているのである.

GPT-3 に限らず,最近の SOTA (State-of-the-art) の性能を達成するニューラルネットワークでは,百万から億のオーダーのパラメータを内包することは頻繁になってきている. そのような巨大なニューラルネットを訓練 (最適化) させるのは,当然のことながら膨大な計算コストがかかる. 結果として,ひとつの計算機では丸一日以上の時間がかかる場合も珍しくない. 深層学習の発展の速度は目覚ましく,研究・ビジネス両方の観点からも,いかにスループットよくニューラルネットワークの最適化を行えるかが鍵となってくる. そのような問題を解決するのにとても有効な手段が,クラウドである! Hands-on #1: 初めての EC2 インスタンスを起動する でその片鱗を見たように,クラウドを使用することでゼロから数千に至るまでの数のインスタンスを動的に起動し,並列に計算を実行することができる. さらに,深層学習を加速させる目的で,深層学習の演算に専用設計された計算チップ (GPU など) がある. クラウドを利用すると,そのような専用計算チップも無尽蔵に利用することができる. 事実,先述した GPT-3 の学習も,詳細は明かされていないが,Microsoft 社のクラウドを使って行われたと報告されている.

GPU による深層学習の高速化

深層学習の計算で欠かすことのできない技術として, GPU (Graphics Processing Unit) について少し説明する.

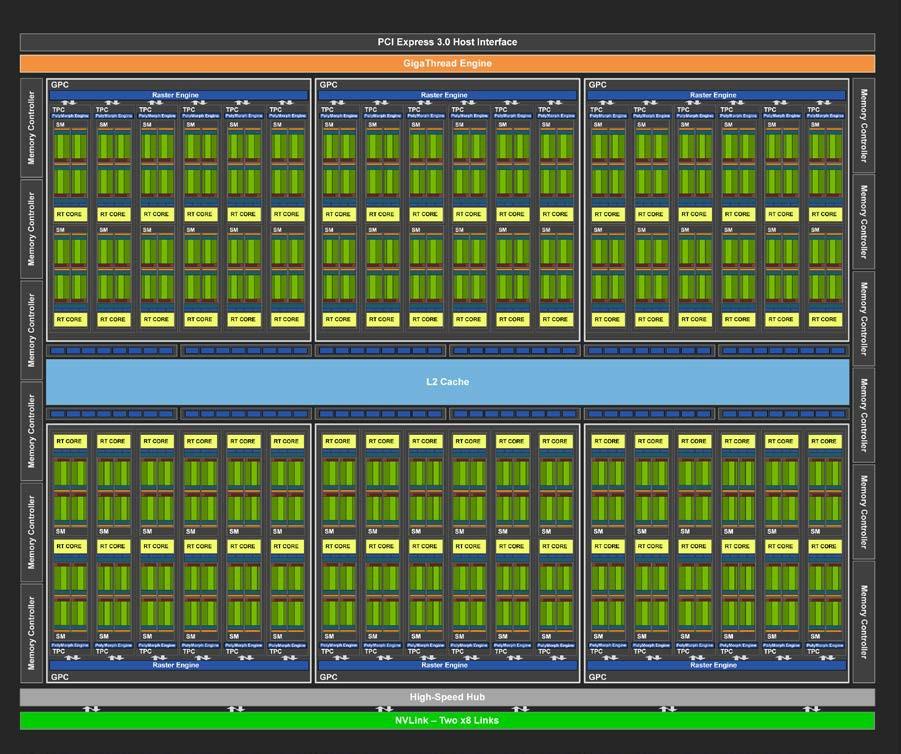

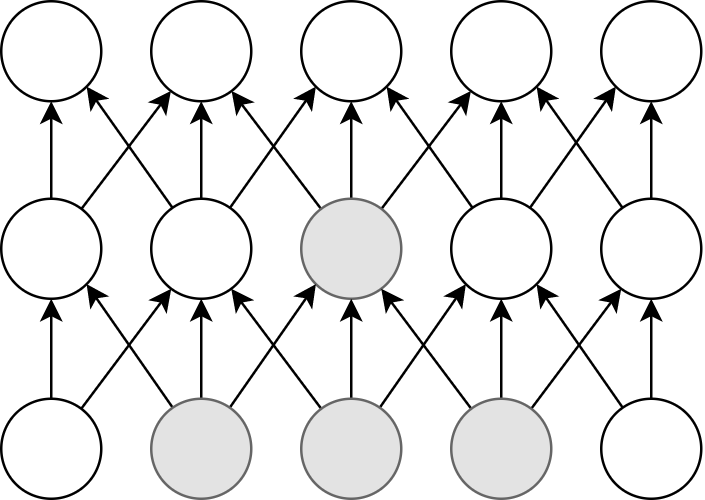

GPU は,その名のとおり,元々はコンピュータグラフィックスを出力するための専用計算チップである. CPU (Central Processing Unit) に対し,グラフィックスの演算に特化した設計がなされている. 身近なところでは, XBox や PS5 などのゲームコンソールなどに搭載されているし,ハイエンドなノート型・デスクトップ型計算機にも搭載されていることがある. コンピュータグラフィックスでは,スクリーンにアレイ状に並んだ数百万個の画素をビデオレート (30 fps) 以上で処理する必要がある. そのため,GPU はコアあたりの演算能力は比較的小さいかわりに,チップあたり数百から数千のコアを搭載しており (figure_title),スクリーンの画素を並列的に処理することで,リアルタイムでの描画を実現している.

このように,コンピュータグラフィクスの目的で生まれた GPU だが,2010 年前後から,その高い並列計算能力をグラフィックス以外の計算 (科学計算など) に用いるという流れ (General-purpose computing on GPU; GPGPU) が生まれた. GPU のコアは,その設計から,行列の計算など,単純かつ規則的な演算が得意であり,そのような演算に対しては数個程度のコアしかもたない CPU に比べて圧倒的に高い計算速度を実現することができる. 現在では GPGPU は分子動力学や気象シミュレーション,そして機械学習など多くの分野で使われている.

ディープラーニングで最も頻繁に起こる演算が,ニューロンの出力を次の層のニューロンに伝える畳み込み (Convolution) 演算である (figure_title). 畳み込み演算は,まさに GPU が得意とする演算であり, CPU ではなく GPU を用いることで学習を飛躍的に (最大で数百倍程度) 加速させることができる.

このように GPU は機械学習の計算で欠かせないものであるが,なかなか高価である. たとえば,科学計算・機械学習に専用設計された NVIDIA 社の Tesla V100 というチップは,一台で約百万円の価格が設定されている. 機械学習を始めるのに,いきなり百万円の投資はなかなか大きい. だが,クラウドを使えば,初期コスト0で GPU を使用することができる.

機械学習を行うのに, V100 が必ずしも必要というわけではない. むしろ,研究者などでしばしば行われるのは,コンピュータゲームに使われるグラフィックス用の GPU を買ってきて (NVIDIA GeForce シリーズなど),開発のときはをそれを用いる,というアプローチである. グラフィックス用のいわゆる"コンシューマ GPU"は,市場の需要が大きいおかげで,10 万円前後の価格で購入することができる. V100 と比べると,コンシューマ GPU はコアの数が少なかったり,メモリーが小さかったりなどで劣る点があるが, それらを除いては計算能力にとくに制限があるわけではなく,開発の段階では十分な性能である場合がほとんどである. プログラムができあがって,ビッグデータの解析や,モデルをさらに大きくしたいときなどに,クラウドは有効だろう.

クラウドで GPU を使うには, GPU が搭載された EC2 インスタンスタイプ (P3, P2, G3, G4 など) を選択しなければならない. table_title に,代表的な GPU 搭載のインスタンスタイプを挙げる (執筆時点での情報).

| Instance | GPUs | GPU model | GPU Mem (GiB) | vCPU | Mem (GiB) | Price per hour ($) |

|---|---|---|---|---|---|---|

p3.2xlarge | 1 | NVIDIA V100 | 16 | 8 | 61 | 3.06 |

p3n.16xlarge | 8 | NVIDIA V100 | 128 | 64 | 488 | 24.48 |

p2.xlarge | 1 | NVIDIA K80 | 12 | 4 | 61 | 0.9 |

g4dn.xlarge | 1 | NVIDIA T4 | 16 | 4 | 16 | 0.526 |

table_title からわかるとおり, CPU のみのインスタンスと比べると少し高い価格設定になっている. また,古い世代の GPU (V100 に対しての K80) はより安価な価格で提供されている. 1 インスタンスあたりの GPU の搭載数は 1 台から最大で 8 台まで選択することが可能である.

GPU を搭載した一番安いインスタンスタイプは, g4dn.xlarge であり,これには廉価かつ省エネルギー設計の NVIDIA T4 が搭載されている. 後のハンズオンでは,このインスタンスを使用して,ディープラーニングの計算を行ってみる.

table_title の価格は us-east-1 のものである. リージョンによって多少価格設定が異なる.

V100 を一台搭載した p3.2xlarge の利用料金は一時間あたり $3.06 である. V100 が約百万円で売られていることを考えると,約 3000 時間 (= 124 日間),通算で計算を行った場合に,クラウドを使うよりも V100 を自分で買ったほうがお得になる,という計算になる (実際には,自前で V100 を用意する場合は, V100 だけでなく, CPU やネットワーク機器,電気使用料も必要なので,百万円よりもさらにコストがかかる).

GPT-3 で使われた計算リソースの詳細は論文でも明かされていないのだが, Lambda 社のブログで興味深い考察が行われている (Lambda 社は機械学習に特化したクラウドサービスを提供している).

記事によると,1750 億のパラメータを訓練するには,一台の GPU (NVIDIA V100) を用いた場合,342 年の月日と 460 万ドルのクラウド利用料が必要となる,とのことである. GPT-3 のチームは,複数の GPU に処理を分散することで現実的な時間のうちに訓練を完了させたのであろうが,このレベルのモデルになってくるとクラウド技術の限界を攻めないと達成できないことは確かである.

深層学習を詳しく勉強したい人には以下の参考書を推薦したい. 深層学習の基礎的な概念や理論は普遍的であるが,この分野は日進月歩なので,常に最新の情報を取り入れることを忘れずに.

Deep Learning (Ian Goodfellow, Yoshua Bengio and Aaron Courville) 出版されてから数年が経つが,深層学習の理論的な側面を学びたいならばおすすめの入門書. ウェブで無料で読むことができる. 日本語版も出版されている. 実装についてはほとんど触れられていないので,理論家向けの本.

ゼロから作る Deep Learning (斎藤 康毅) 合計三冊からなるシリーズ. 理論と実装がバランスよく説明されていて,深層学習の入門書の決定版.

Dive into Deep Learning (Aston Zhang, Zachary C. Lipton, Mu Li, and Alexander J. Smola) 深層学習の基礎から最新のアルゴリズムまでを,実装を通して学んでいくスタイルの本. ウェブで無料で読むことができる,1000 ページ越えの超大作. これを読破することができれば,深層学習の実装で困ることはないだろう.

Hands-on #2: AWS でディープラーニングを実践

準備

ハンズオン第二回では, GPU を搭載した EC2 インスタンスを起動し,深層学習モデルの学習と推論を実行する演習を行う.

ハンズオンのソースコードは GitHub の handson/mnist に置いてある.

本ハンズオンの実行には,第一回ハンズオンで説明した準備 (準備) が整っていることを前提とする. それ以外に必要な準備はない.

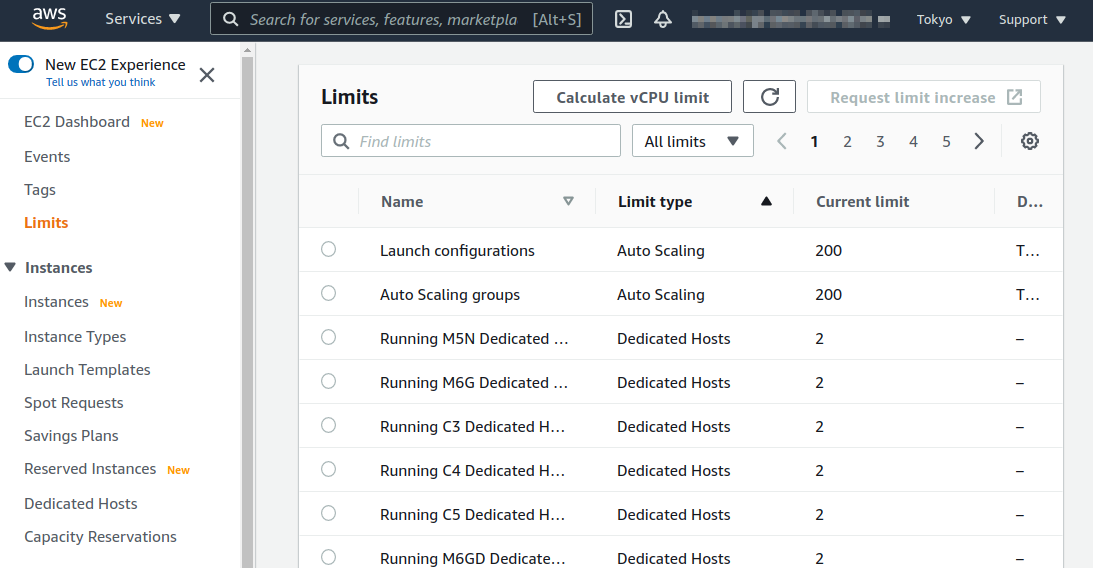

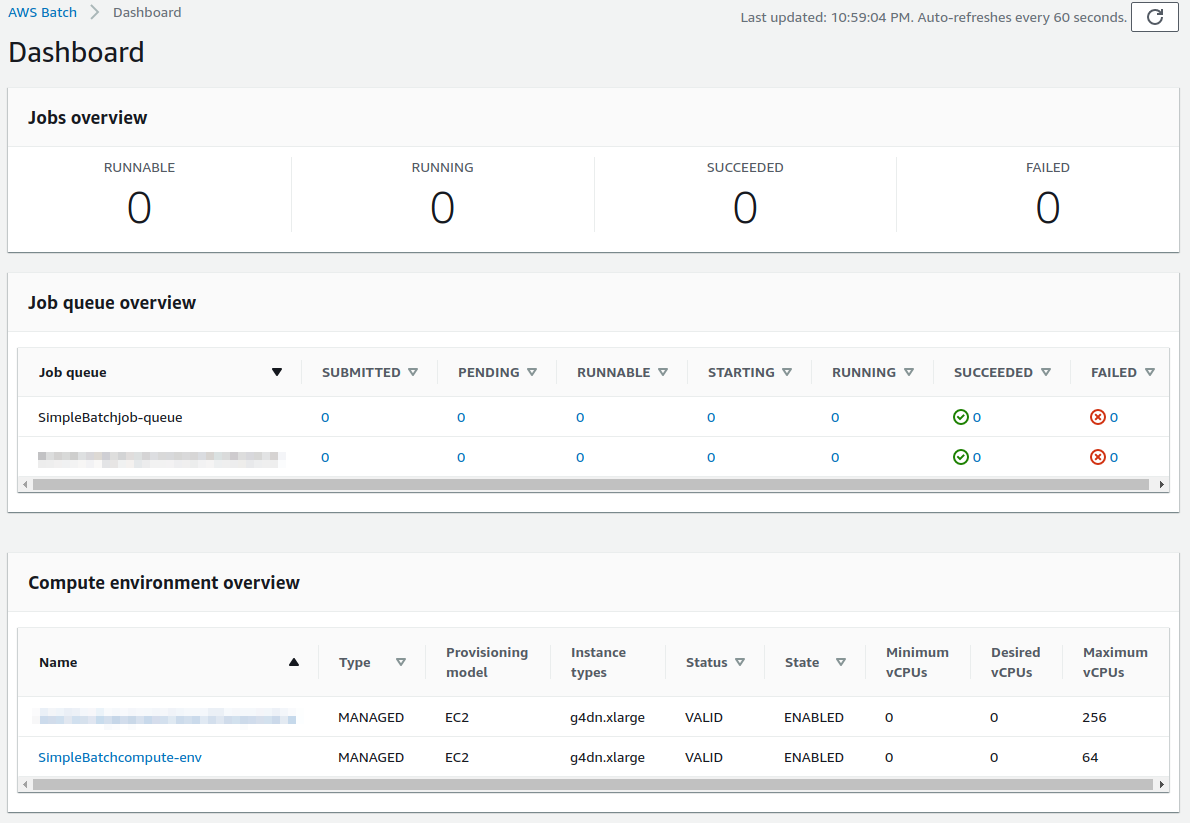

初期状態の AWS アカウントでは, GPU 搭載の G タイプのインスタンスの起動上限が 0 になっていることがある. これを確認するには, AWS コンソールから EC2 の画面を開き,左のメニューから Limits を選択する. その中の Running On-Demand All G instances という数字が G インスタンスの起動上限を表している.

もし,これが 0 になっていた場合は, AWS の自動申請フォームから上限緩和のリクエストを送る必要がある. 詳しくは 公式ドキュメンテーション "Amazon EC2 service quotas" を参照のこと.

このハンズオンは, g4dn.xlarge タイプの EC2 インスタンスを使うので,東京 (ap-northeast-1) リージョンでは 0.71 $/hour のコストが発生する.

AWS Educate Starter Account を使用している読者へ: 執筆時点においては, Starter Account には GPU 搭載型インスタンスを起動できないという制限が設けられている. したがって, Starter Account のユーザーはこのハンズオンを実行することはできない. 興味のある読者は,制限のない一般アカウントを自分自身で取得する必要があることに注意.

アプリケーションの説明

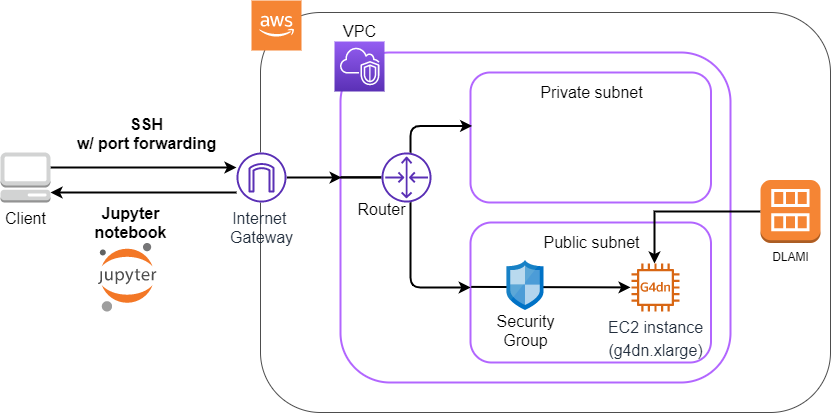

このハンズオンで作成するアプリケーションの概要を figure_title に示す.

図の多くの部分が,第一回ハンズオンで作成したアプリケーションと共通していることに気がつくだろう. 少しの変更で,簡単にディープラーニングを走らせる環境を構築することができるのである!主な変更点は次の3点である.

GPU を搭載した

g4dn.xlargeインスタンスタイプを使用ディープラーニングに使うプログラムがあらかじめインストールされた DLAMI (後述) を使用

SSH にポートフォワーディングのオプションつけてサーバーに接続し,サーバーで起動している Jupyter Notebook (後述) を使ってプログラムを書いたり実行したりする

ハンズオンで使用するプログラムのコードをみてみよう handson/mnist/app.py). コードは第一回目とほとんど共通である.変更点のみ解説を行う.

python

class Ec2ForDl(core.Stack):

def __init__(self, scope: core.App, name: str, key_name: str, **kwargs) -> None:

super().__init__(scope, name, **kwargs)

vpc = ec2.Vpc(

self, "Ec2ForDl-Vpc",

max_azs=1,

cidr="10.10.0.0/23",

subnet_configuration=[

ec2.SubnetConfiguration(

name="public",

subnet_type=ec2.SubnetType.PUBLIC,

)

],

nat_gateways=0,

)

sg = ec2.SecurityGroup(

self, "Ec2ForDl-Sg",

vpc=vpc,

allow_all_outbound=True,

)

sg.add_ingress_rule(

peer=ec2.Peer.any_ipv4(),

connection=ec2.Port.tcp(22),

)

host = ec2.Instance(

self, "Ec2ForDl-Instance",

instance_type=ec2.InstanceType("g4dn.xlarge"), #

machine_image=ec2.MachineImage.generic_linux({

"us-east-1": "ami-060f07284bb6f9faf",

"ap-northeast-1": "ami-09c0c16fc46a29ed9"

}), #

vpc=vpc,

vpc_subnets=ec2.SubnetSelection(subnet_type=ec2.SubnetType.PUBLIC),

security_group=sg,

key_name=key_name

)class Ec2ForDl(core.Stack):

def __init__(self, scope: core.App, name: str, key_name: str, **kwargs) -> None:

super().__init__(scope, name, **kwargs)

vpc = ec2.Vpc(

self, "Ec2ForDl-Vpc",

max_azs=1,

cidr="10.10.0.0/23",

subnet_configuration=[

ec2.SubnetConfiguration(

name="public",

subnet_type=ec2.SubnetType.PUBLIC,

)

],

nat_gateways=0,

)

sg = ec2.SecurityGroup(

self, "Ec2ForDl-Sg",

vpc=vpc,

allow_all_outbound=True,

)

sg.add_ingress_rule(

peer=ec2.Peer.any_ipv4(),

connection=ec2.Port.tcp(22),

)

host = ec2.Instance(

self, "Ec2ForDl-Instance",

instance_type=ec2.InstanceType("g4dn.xlarge"), #

machine_image=ec2.MachineImage.generic_linux({

"us-east-1": "ami-060f07284bb6f9faf",

"ap-northeast-1": "ami-09c0c16fc46a29ed9"

}), #

vpc=vpc,

vpc_subnets=ec2.SubnetSelection(subnet_type=ec2.SubnetType.PUBLIC),

security_group=sg,

key_name=key_name

)ここで,

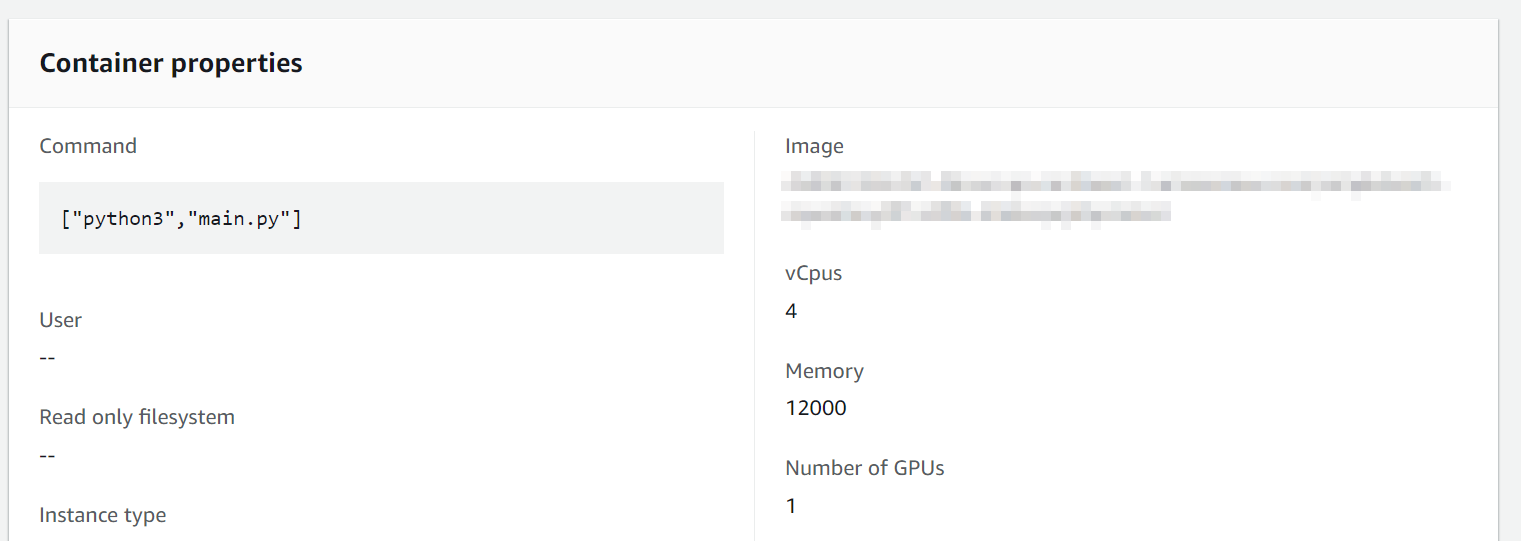

g4dn.xlargeインスタンスタイプを選択している (第一回では, CPU のみのt2.microだった).g4dn.xlargeのインスタンスタイプは, クラウドで行う科学計算・機械学習 ですでに触れた通り,NVIDIA T4と呼ばれる廉価版モデルの GPU を搭載したインスタンスである. CPU は 4 core, メインメモリーは 16GB が割り当てあられている.ここでは,Deep Learning 用の諸々のソフトウェアがプリンストールされた AMI (Deep Learning Amazon Machine Image; DLAMI) を選択している (第一回では,Amazon Linux という AMI を使用していた). 使用する AMI の ID は リージョンごとに指定する必要があり,ここでは

us-east-1とap-northeast-1でそれぞれ定義している.

DLAMI という新しい概念が出てきたので,説明しよう.

AMI が us-east-1 と ap-northeast-1 でしか定義されていないので,提供されているコードはこの二つのリージョンのみでデプロイ可能である. もしほかのリージョンを利用したい場合は, AMI の ID を自身で検索し,コードに書き込む必要がある.

DLAMI (Deep Learning Amazon Machine Image)

AMI (Amazon Machine Image) とは,大まかには OS (Operating System) に相当する概念である. 当然のことながら, OS がなければコンピュータはなにもできないので,EC2 インスタンスを起動するときには必ずなにかの OS を"インストール"する必要がある. EC2 が起動したときにロードされる OS に相当するものが, AMI である. AMI には,たとえば Ubuntu などの Linux 系 OS に加えて,Windows Server を選択することもできる. また, EC2 での使用に最適化された Amazon Linux という AMI も提供されている.

しかしながら, AMI を単なる OS と理解するのは過剰な単純化である. AMI には,ベースとなる (空っぽの) OS を選択することもできるが,それに加えて,各種のプログラムがインストール済みの AMI も定義することができる. 必要なプログラムがインストールされている AMI を見つけることができれば,自身でインストールを行ったり環境設定したりする手間が大幅に省ける. 具体例を挙げると,ハンズオン第一回では EC2 インスタンスに Python 3.6 をインストールする例を示したが,そのような操作をインスタンスが起動するたびに行うのは手間である!

AMI は, AWS 公式のものに加えて,サードパーティから提供されているものもある. また,自分自身の AMI を作って登録することも可能である (参考). AMI は EC2 のコンソールから検索することが可能である. あるいは,AWS CLI を使って,次のコマンドでリストを取得することができる (参考).

sh

$ aws ec2 describe-images --owners amazon$ aws ec2 describe-images --owners amazonディープラーニングで頻繁に使われるプログラムがあらかじめインストールしてある AMI が, DLAMI (Deep Learning AMI) である. DLAMI には TensorFlow, PyTorch などの人気の高いディープラーニングのフレームワーク・ライブラリがすでにインストールされているため, EC2 インスタンスを起動してすぐさまディープラーニングの計算を実行できる.

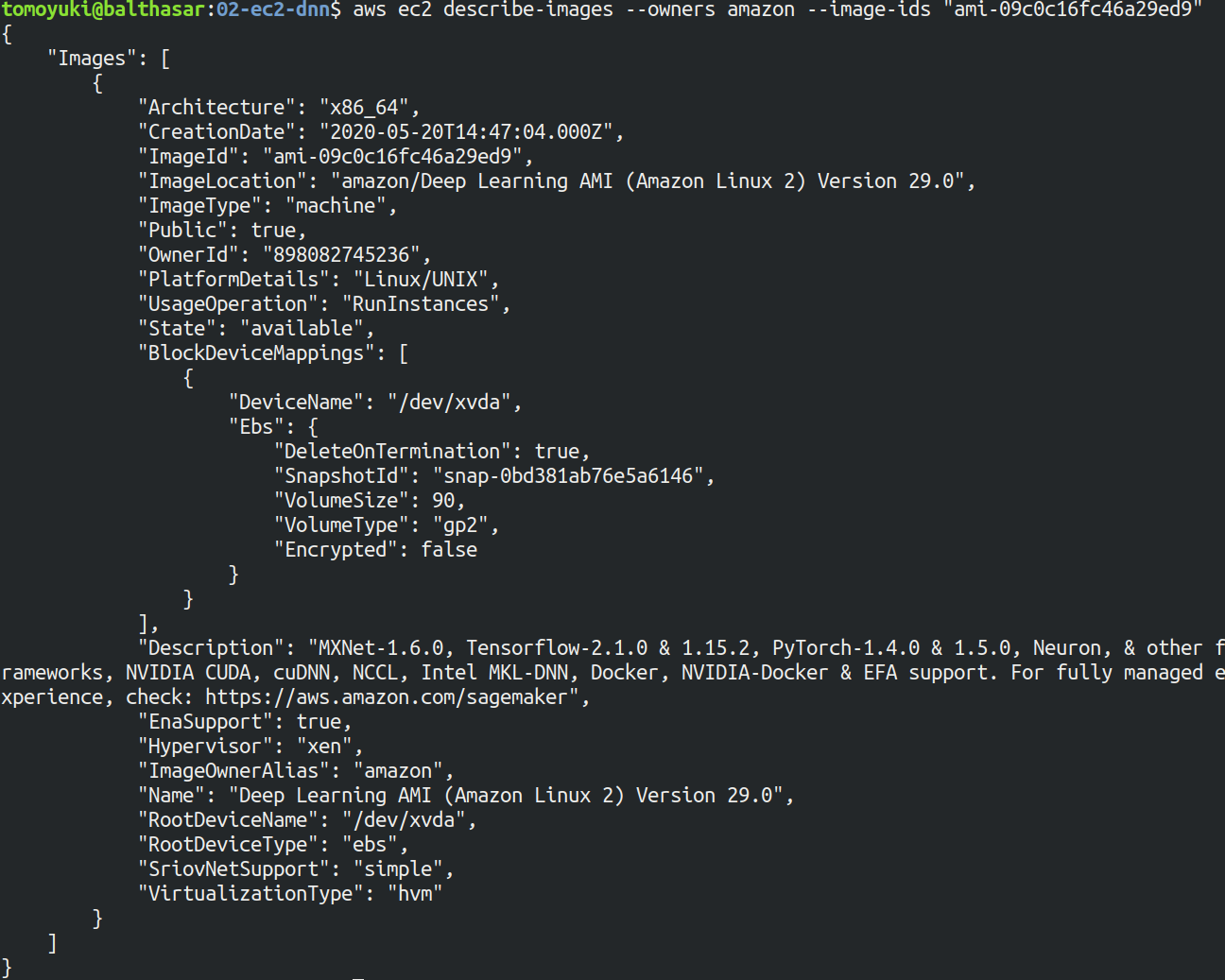

本ハンズオンでは, Amazon Linux 2 をベースにした DLAMI を使用する (AMI ID = ami-09c0c16fc46a29ed9.この AMI は ap-northeast-1 でしか使用できない点に注意). AWS CLI を使って,この AMI の詳細情報を取得してみよう.

sh

$ aws ec2 describe-images --owners amazon --image-ids "ami-09c0c16fc46a29ed9" --region ap-northeast-1$ aws ec2 describe-images --owners amazon --image-ids "ami-09c0c16fc46a29ed9" --region ap-northeast-1

figure_title のような出力が得られるはずである.得られた出力から,この DLAMI には PyTorch のバージョン 1.4.0 と 1.5.0 がインストールされていることがわかる. この DLAMI を使って,早速ディープラーニングの計算を実行してみよう.

DLAMI には具体的には何がインストールされているのだろうか? 興味のある読者のために,簡単な解説をしよう (参考: 公式ドキュメンテーション "What Is the AWS Deep Learning AMI?").

最も low-level なレイヤーとしては, GPU ドライバー がインストールされている. GPU ドライバーなしには OS は GPU とコマンドのやり取りをすることができない. 次のレイヤーが CUDA と cuDNN である. CUDA は, NVIDIA 社が開発した, GPU 上で汎用コンピューティングを行うための言語であり, C++ 言語を拡張したシンタックスを備える. cuDNN は CUDA で書かれたディープラーニングのライブラリであり,n 次元の畳み込みなどの演算が実装されている. ここまでが, "Base" とよばれるタイプの DLAMI の中身である.

これに加えて, "Conda" とよばれるタイプには, "Base" のプログラム基盤の上に, TensorFlow や PyTorch などのライブラリがインストールされている. さらに, Anaconda による仮想環境を使うことによって, TensorFlow の環境・ PyTorch の環境・ MxNet の環境など,フレームワークを簡単に切り替えることができる (これについては,後のハンズオンで触れる). また, Jupyter Notebook もインストール済みである.

スタックのデプロイ

スタックの中身が理解できたところで,早速スタックをデプロイしてみよう.

デプロイの手順は,ハンズオン 1 とほとんど共通である. ここでは,コマンドのみ列挙する (# で始まる行はコメントである). それぞれのコマンドの意味を忘れてしまった場合は,ハンズオン 1 に戻って復習していただきたい. シークレットキーの設定も忘れずに (AWS CLI のインストール).

sh

# プロジェクトのディレクトリに移動

$ cd handson/mnist

# venv を作成し,依存ライブラリのインストールを行う

$ python3 -m venv .env

$ source .env/bin/activate

$ pip install -r requirements.txt

# SSH鍵を生成

$ export KEY_NAME="HirakeGoma"

$ aws ec2 create-key-pair --key-name ${KEY_NAME} --query 'KeyMaterial' --output text > ${KEY_NAME}.pem

$ mv HirakeGoma.pem ~/.ssh/

$ chmod 400 ~/.ssh/HirakeGoma.pem

# デプロイを実行

$ cdk deploy -c key_name="HirakeGoma"# プロジェクトのディレクトリに移動

$ cd handson/mnist

# venv を作成し,依存ライブラリのインストールを行う

$ python3 -m venv .env

$ source .env/bin/activate

$ pip install -r requirements.txt

# SSH鍵を生成

$ export KEY_NAME="HirakeGoma"

$ aws ec2 create-key-pair --key-name ${KEY_NAME} --query 'KeyMaterial' --output text > ${KEY_NAME}.pem

$ mv HirakeGoma.pem ~/.ssh/

$ chmod 400 ~/.ssh/HirakeGoma.pem

# デプロイを実行

$ cdk deploy -c key_name="HirakeGoma"ハンズオン 1 で作成した SSH 鍵の削除を行わなかった場合は, SSH 鍵を改めて作成する必要はない. 逆に言うと,同じ名前の SSH がすでに存在する場合は,鍵生成のコマンドはエラーを出力する.

デプロイのコマンドが無事に実行されれば, figure_title のような出力が得られるはずである.AWS により割り振られた IP アドレス (InstancePublicIp に続く文字列) をメモしておこう.

ログイン

早速,デプロイしたインスタンスに SSH でログインしてみよう. ここでは,この後で使う Jupyter Notebook に接続するため,ポートフォワーディング (port forwarding) のオプション (-L) をつけてログインする.

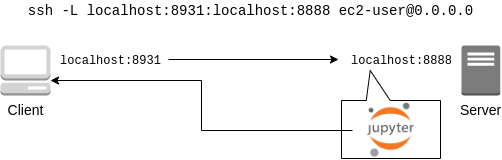

sh

$ ssh -i ~/.ssh/HirakeGoma.pem -L localhost:8931:localhost:8888 ec2-user@<IP address>$ ssh -i ~/.ssh/HirakeGoma.pem -L localhost:8931:localhost:8888 ec2-user@<IP address>ポートフォワーディングとは,クライアントマシンの特定のアドレスへの接続を, SSH の暗号化された通信を介して,リモートマシンの特定のアドレスへ転送する,という意味である. このコマンドの -L localhost:8931:localhost:8888 は,自分のローカルマシンの localhost:8931 へのアクセスを,リモートサーバーの localhost:8888 のアドレスに転送せよ,という意味である (: につづく数字は TCP/IP ポートの番号を意味している). リモートサーバーのポート 8888 には,後述する Jupyter Notebook が起動している. したがって,ローカルマシンの localhost:8931 にアクセスすることで,リモートサーバーの Jupyter Notebook にアクセスすることができるのである (figure_title). このような SSH による接続方式をトンネル接続とよぶ.

ポートフォワーディングのオプションで,ポートの番号 (:8931, :8888 など) には 1 から 65535 までの任意の整数を指定できる. しかし,たとえば ポート 22 (SSH) やポート 80 (HTTP) など,いくつかすでに使われているポート番号もあることに注意する. また, Jupyter Notebook はデフォルトではポート 8888 番を使用する. したがって,リモート側のポート番号は,8888 を使うのがよい.

SSH ログインコマンドの <IP address> 部分は自身のインスタンスの IP アドレスを代入することを忘れずに.

本書の提供している Docker を使ってデプロイを実行した人へ

SSH によるログインは, Docker の外 (すなわちクライアントマシン本体) から行わなければならない. なぜなら,Jupyter を開くウェブブラウザは Docker の外にあるからである.

その際,秘密鍵を Docker の外にもってこなければならない. 手っ取り早い方法は, cat ~/.ssh/HirakeGoma と打って,出力結果をコピーしてホストマシンのファイルに書き込む方法である. あるいは -v オプションをつけて,ファイルシステムをマウントしてもよい (詳しくは Docker 公式ドキュメンテーション "Use volumes" を参照).

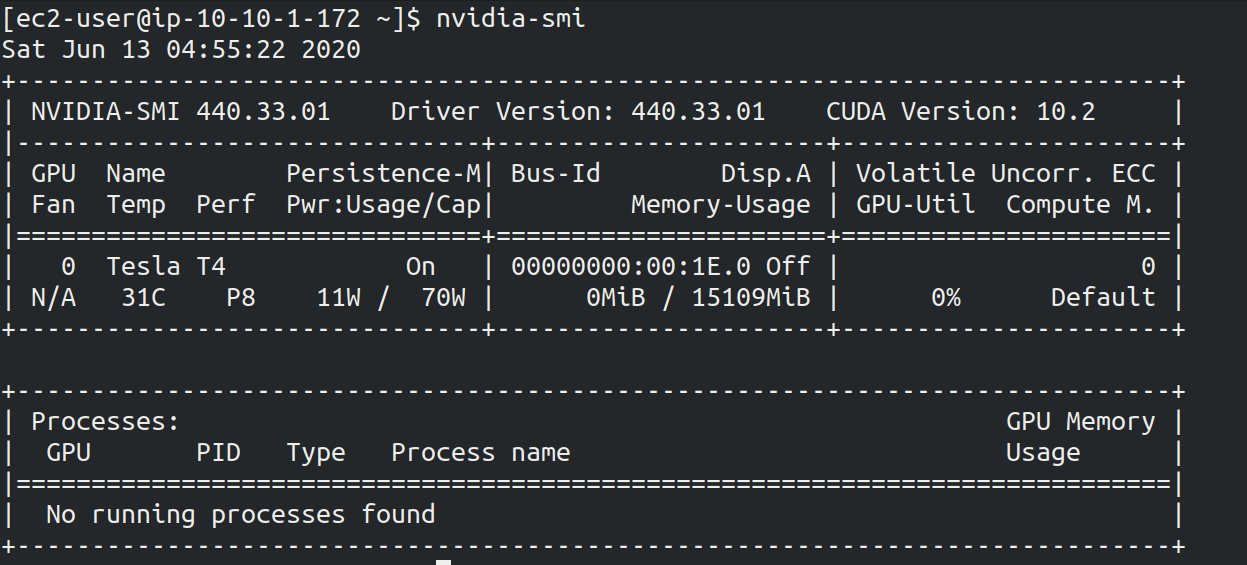

SSH によるログインができたら,早速, GPU の状態を確認してみよう. 次のコマンドを実行する.

sh

$ nvidia-smi$ nvidia-smifigure_title のような出力が得られるはずである. 出力を見ると, Tesla T4 型の GPU が 1 台搭載されていることが確認できる. その他,GPU Driver や CUDA のバージョン, GPU の負荷・メモリー使用率などの情報を確認することができる.

Jupyter Notebook の起動

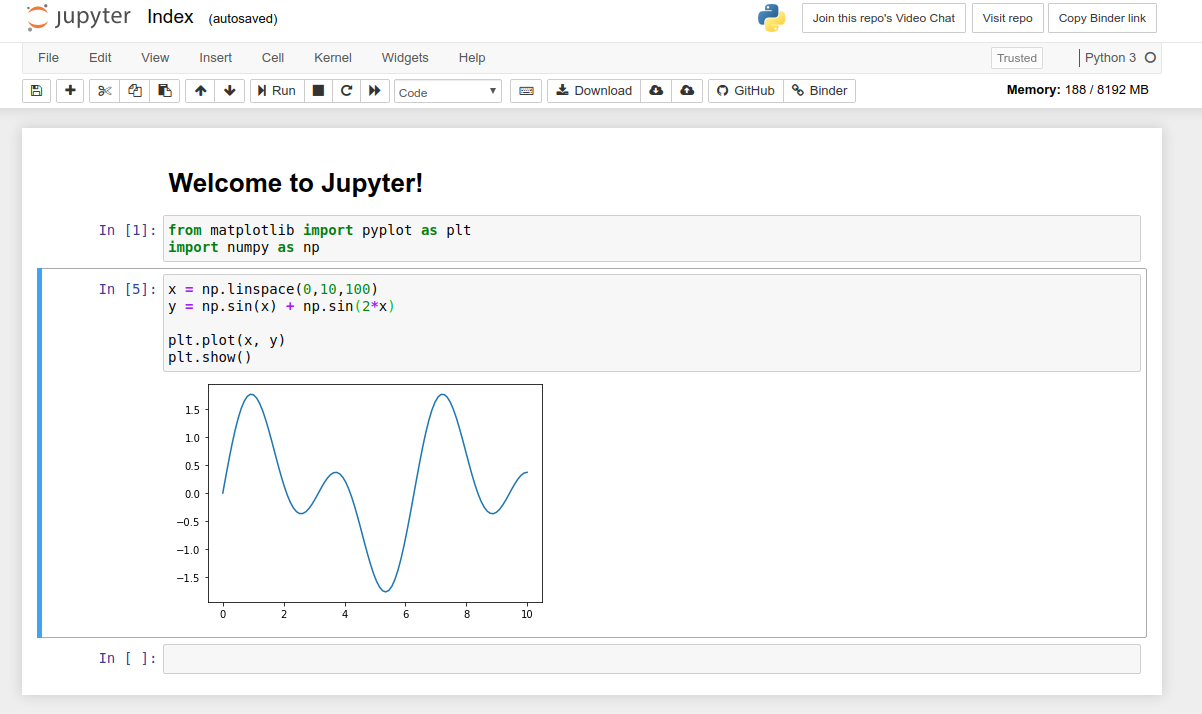

Jupyter Notebook とは,インタラクティブに Python のプログラムを書いたり実行したりするためのツールである. Jupyter は GUI としてウェブブラウザを介してアクセスする形式をとっており,まるでノートを書くように,プロットやテーブルのデータも美しく表示することができる (figure_title). Python に慣れている読者は,きっと一度は使ったことがあるだろう.

このハンズオンでは, Jupyter Notebook を使ってディープラーニングのプログラムをインタラクティブに実行していく. DLAMI には既に Jupyter がインストールされているので,特段の設定なしに使い始めることができる.

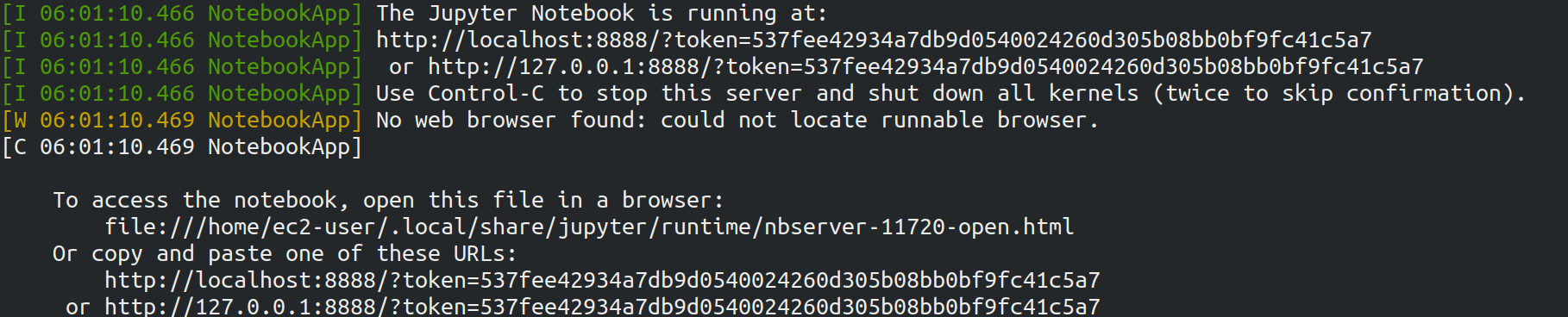

早速, Jupyter を起動しよう. SSH でログインした先の EC2 インスタンスで,次のコマンドを実行すればよい.

sh

$ cd ~ # go to home directory

$ jupyter notebook$ cd ~ # go to home directory

$ jupyter notebookこのコマンドを実行すると, figure_title のような出力が確認できるだろう. この出力から,Jupyter のサーバーが EC2 インスタンスの localhost:8888 というアドレスに起動していることがわかる. また, localhost:8888 に続く ?token=XXXX は,アクセスに使うための一時的なトークンである.

Jupyter Notebook を初回に起動するときは,起動に数分程度の時間がかかることがある. ほかの動作も起動直後は遅く,いくつかプログラムを走らせていくうちに俊敏に反応するようになってくる. これは, AWS の GPU 搭載型仮想マシンの運用方法に起因する現象だと考えられる.

先ほど,ポートフォワーディングのオプションをつけて SSH 接続をしているので, Jupyter の起動している localhost:8888 には,ローカルマシンの localhost:8931 からアクセスすることができる. したがって,ローカルマシンから Jupyter にアクセスするには,ウェブブラウザ (Chrome, FireFox など)から次のアドレスにアクセスすれば良い.

http://localhost:8931/?token=XXXX</programlisting>

?token=XXXX の部分は,上で Jupyter を起動したときに発行されたトークンの値に置き換える.

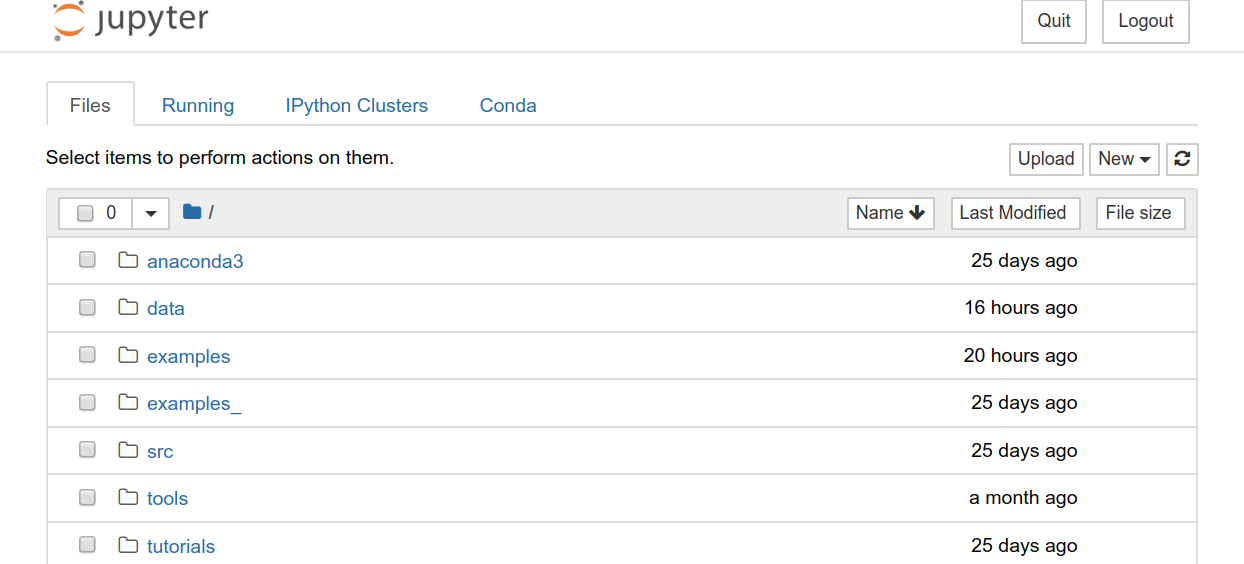

上のアドレスにアクセスすると, Jupyter のホーム画面が起動するはずである (figure_title). これで, Jupyter の準備が整った!

Jupyter Notebook の使い方 (超簡易版)

Shift+Enter: セルを実行Esc: Command mode に遷移メニューバーの "+" ボタン または Command mode で

A⇒ セルを追加メニューバーの "ハサミ" ボタン または Command mode で

X⇒ セルを削除

ショートカットの一覧などは Ventsislav Yordanov 氏によるブログ が参考になる.

PyTorch はじめの一歩

PyTorch は Facebook AI Research LAB (FAIR) が中心となって開発を進めている,オープンソースのディープラーニングのライブラリである. PyTorch は 有名な例で言えば Tesla 社の自動運転プロジェクトなどで使用されており,執筆時点において最も人気の高いディープラーニングライブラリの一つである. 本ハンズオンでは, PyTorch を使ってディープラーニングの実践を行う.

PyTorch の歴史のお話

Facebook は PyTorch のほかに Caffe2 とよばれるディープラーニングのフレームワークを開発していた (初代 Caffe は UC Berkley の博士課程学生だった Yangqing Jia によって創られた). Caffe2 は 2018 年に PyTorch プロジェクトに合併された.

また,2019 年 12 月,日本の Preferred Networks 社が開発していた Chainer も開発を終了し,PyTorch の開発チームと協業していくことが発表された (詳しくは プレスリリース を参照). PyTorch には,開発統合前から Chainer からインスパイアされた API がいくつもあり, Chainer の DNA は今も PyTorch に引き継がれているのである…!

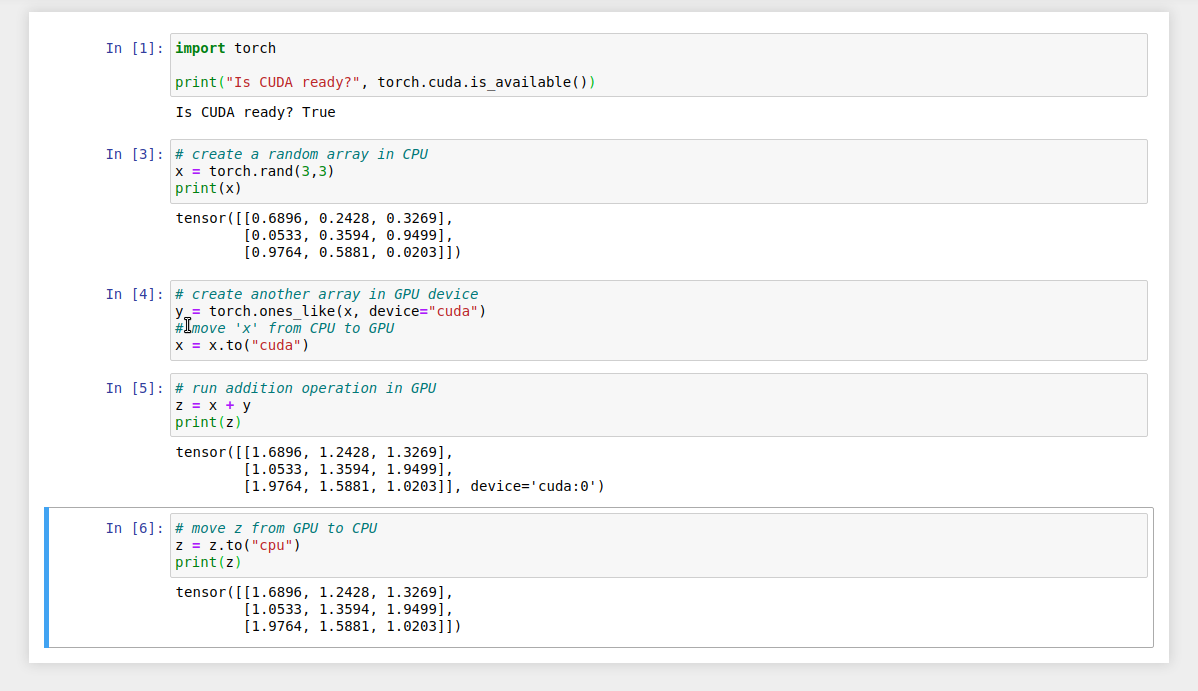

本格的なディープラーニングの計算に移る前に, PyTorch ライブラリを使って, GPU で計算を行うとはどういうものか,その入り口に触れてみよう.

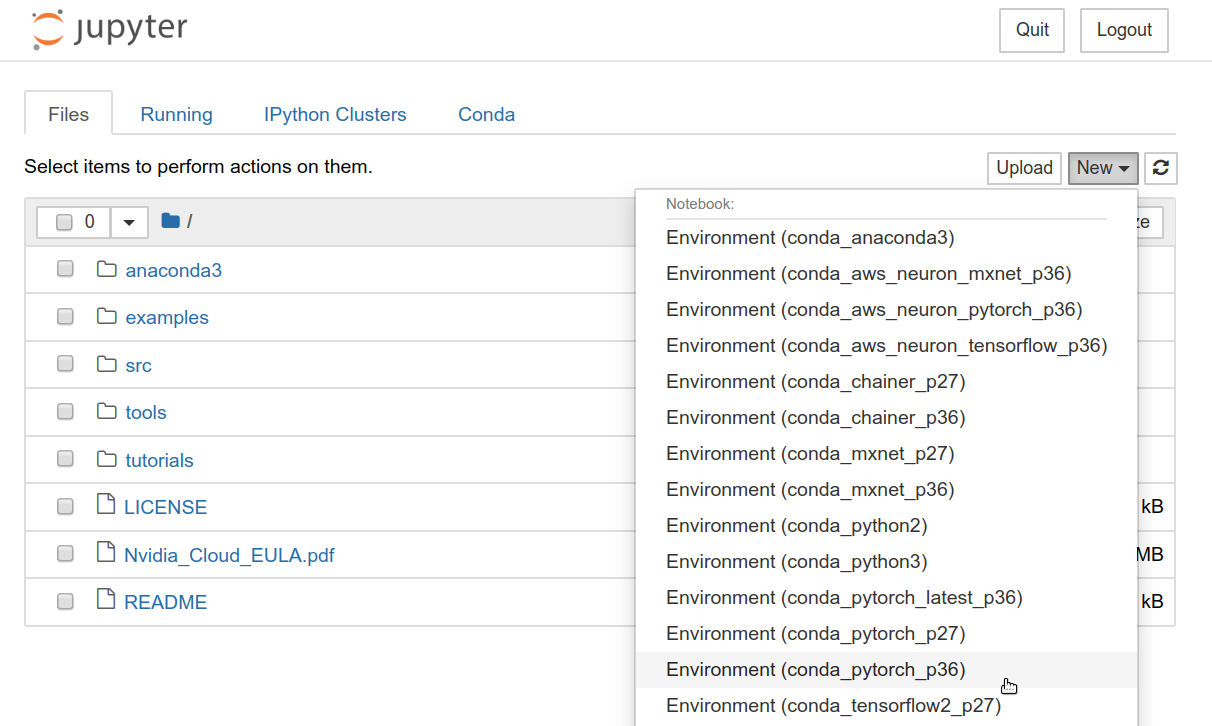

まずは,新しいノートブックを作成する. Jupyter のホーム画面の右上の "New" を押し,"conda_pytorch_p36" という環境を選択したうえで,新規ノートブックを作成する (figure_title). "conda_pytorch_p36" の仮想環境には, PyTorch がインストール済みである.

ここでは,次のようなプログラムを書いて,実行していく. (figure_title).

まずは, PyTorch をインポートする.さらに, GPU が使える環境にあるか,確認する.

python

import torch

print("Is CUDA ready?", torch.cuda.is_available())import torch

print("Is CUDA ready?", torch.cuda.is_available())出力:

Is CUDA ready? True</programlisting>

次に,3x3 のランダムな行列を CPU 上に作ってみよう.

python

x = torch.rand(3,3)

print(x)x = torch.rand(3,3)

print(x)出力:

tensor([[0.6896, 0.2428, 0.3269], [0.0533, 0.3594, 0.9499], [0.9764, 0.5881, 0.0203]])</programlisting>

次に,行列を GPU 上に作成する.

python

y = torch.ones_like(x, device="cuda")

x = x.to("cuda")y = torch.ones_like(x, device="cuda")

x = x.to("cuda")そして,行列 x と y の加算を,GPU 上で実行する.

python

z = x + y

print(z)z = x + y

print(z)出力:

tensor([[1.6896, 1.2428, 1.3269], [1.0533, 1.3594, 1.9499], [1.9764, 1.5881, 1.0203]], device='cuda:0')</programlisting>

最後に, GPU 上にある行列を, CPU に戻す.

python

z = z.to("cpu")

print(z)z = z.to("cpu")

print(z)出力:

tensor([[1.6896, 1.2428, 1.3269], [1.0533, 1.3594, 1.9499], [1.9764, 1.5881, 1.0203]])</programlisting>

以上の例は, GPU を使った計算の初歩の初歩であるが,雰囲気はつかめただろうか? CPU と GPU で明示的にデータを交換するのが肝である. この例はたった 3x3 の行列の足し算なので, GPU を使う意味はまったくないが,これが数千,数万のサイズの行列になったとき, GPU は格段の威力を発揮する.

完成した Jupyter Notebook は /handson/mnist/pytorch/pytorch_get_started.ipynb にある. Jupyter の画面右上の "Upload" からこのファイルをアップロードして,コードを走らせることが可能である.

しなしながら,勉強のときにはコードはすべて自分の手で打つことが,記憶に残りやすくより効果的である,というのが筆者の意見である.

実際にベンチマークを取ることで GPU と CPU の速度を比較をしてみよう. 実行時間を計測するツールとして, Jupyter の提供する %time マジックコマンドを利用する.

まずは CPU を使用して,10000x10000 の行列の行列積を計算した場合の速度を測ってみよう. 先ほどのノートブックの続きに,次のコードを実行する.

python

s = 10000

device = "cpu"

x = torch.rand(s, s, device=device, dtype=torch.float32)

y = torch.rand(s, s, device=device, dtype=torch.float32)

%time z = torch.matmul(x,y)s = 10000

device = "cpu"

x = torch.rand(s, s, device=device, dtype=torch.float32)

y = torch.rand(s, s, device=device, dtype=torch.float32)

%time z = torch.matmul(x,y)出力は以下のようなものが得られるだろう. これは,行列積の計算に実時間で 5.8 秒かかったことを意味する (実行のたびに計測される時間はばらつくことに留意).

CPU times: user 11.5 s, sys: 140 ms, total: 11.6 s Wall time: 5.8 s</programlisting>

次に, GPU を使用して,同じ演算を行った場合の速度を計測しよう.

python

s = 10000

device = "cuda"

x = torch.rand(s, s, device=device, dtype=torch.float32)

y = torch.rand(s, s, device=device, dtype=torch.float32)

torch.cuda.synchronize()

%time z = torch.matmul(x,y); torch.cuda.synchronize()s = 10000

device = "cuda"

x = torch.rand(s, s, device=device, dtype=torch.float32)

y = torch.rand(s, s, device=device, dtype=torch.float32)

torch.cuda.synchronize()

%time z = torch.matmul(x,y); torch.cuda.synchronize()出力は以下のようなものになるだろう. GPU では 553 ミリ秒 で計算を終えることができた!

CPU times: user 334 ms, sys: 220 ms, total: 554 ms Wall time: 553 ms</programlisting>

PyTorch において, GPU での演算は asynchronous (非同期) で実行される. その理由で,上のベンチマークコードでは, torch.cuda.synchronize() というステートメントを埋め込んである.

このベンチマークでは, dtype=torch.float32 と指定することで,32bit の浮動小数点型を用いている. ディープラーニングの学習および推論の計算には,32bit 型,場合によっては 16bit 型が使われるのが一般的である. これの主な理由として,教師データやミニバッチに起因するノイズが,浮動小数点の精度よりも大きいことがあげられる. 32bit/16bit を採用することで,メモリー消費を抑えたり,計算速度の向上が達成できる.

上記のベンチマークから,GPU を用いることで,約 10 倍のスピードアップを実現することができた. スピードアップの性能は,演算の種類や行列のサイズに依存する. 行列積は,そのなかでも最も速度向上が見込まれる演算の一つである.

実践ディープラーニング! MNIST 手書き数字認識タスク

ここまで,AWS 上でディープラーニングの計算をするための概念や前提知識をながながと説明してきたが,ついにここからディープラーニングの計算を実際に走らせてみる.

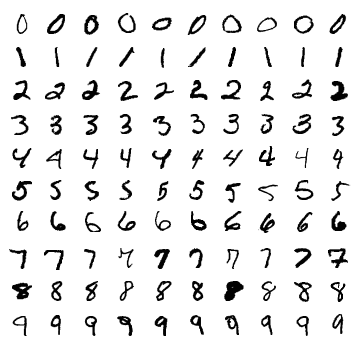

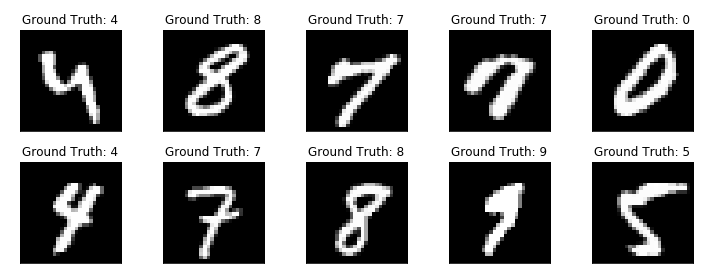

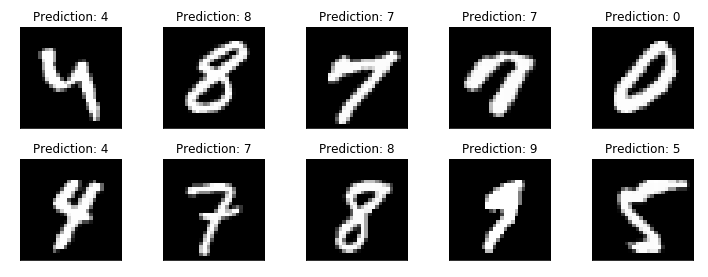

ここでは,機械学習のタスクで最も初歩的かつ有名な MNIST データセットを使った数字認識を扱う (figure_title). これは,0 から 9 までの手書きの数字の画像が与えられ,その数字が何の数字なのかを当てる,というシンプルなタスクである.

今回は, MNIST 文字認識タスクを,畳み込みニューラルネットワーク (Convolutional Neural Network; CNN) を使って解く. ソースコードは /handson/minist/pytorch/ にある mnist.ipynb と simple_mnist.py である. なお,このプログラムは, PyTorch の公式 Example Project 集 を参考に,多少の改変を行ったものである.

まずは,カスタムのクラスや関数が定義された simple_mnist.py をアップロードしよう (figure_title). 画面右上の "Upload" ボタンをクリックし,ファイルを選択することでアップロードができる. この Python プログラムの中に,CNN のモデルや,学習の各イテレーションにおけるパラメータの更新などが記述されている. 今回はこの中身を説明することはしないが,興味のある読者は自身でソースコードを読んでみるとよい.

simple_mnist.py をアップロードできたら,次に新しい notebook を作成しよう. "conda_pytorch_p36" の環境を選択することを忘れずに.

新しいノートブックが起動したら,まずは必要なライブラリをインポートしよう.

python

import torch

import torch.optim as optim

import torchvision

from torchvision import datasets, transforms

from matplotlib import pyplot as plt

# custom functions and classes

from simple_mnist import Model, train, evaluateimport torch

import torch.optim as optim

import torchvision

from torchvision import datasets, transforms

from matplotlib import pyplot as plt

# custom functions and classes

from simple_mnist import Model, train, evaluatetorchvision パッケージには,MNIST データセットをロードするなどの便利な関数が含まれている. また,今回のハンズオンで使うカスタムのクラス・関数 (Model, train, evaluate) のインポートを行っている.

次に,MNIST テストデータをダウンロードしよう. 同時に,画像データの輝度の正規化も行っている.

python

transf = transforms.Compose([transforms.ToTensor(),

transforms.Normalize((0.1307,), (0.3081,))])

trainset = datasets.MNIST(root='./data', train=True, download=True, transform=transf)

trainloader = torch.utils.data.DataLoader(trainset, batch_size=64, shuffle=True)

testset = datasets.MNIST(root='./data', train=False, download=True, transform=transf)

testloader = torch.utils.data.DataLoader(testset, batch_size=1000, shuffle=True)transf = transforms.Compose([transforms.ToTensor(),

transforms.Normalize((0.1307,), (0.3081,))])

trainset = datasets.MNIST(root='./data', train=True, download=True, transform=transf)

trainloader = torch.utils.data.DataLoader(trainset, batch_size=64, shuffle=True)

testset = datasets.MNIST(root='./data', train=False, download=True, transform=transf)

testloader = torch.utils.data.DataLoader(testset, batch_size=1000, shuffle=True)今回扱う MNIST データは 28x28 ピクセルの正方形の画像(モノクロ)と,それぞれのラベル(0 - 9 の数字)の組で構成されている. いくつかのデータを抽出して,可視化してみよう. figure_title のような出力が得られるはずである.

python

examples = iter(testloader)

example_data, example_targets = examples.next()

print("Example data size:", example_data.shape)

fig = plt.figure(figsize=(10,4))

for i in range(10):

plt.subplot(2,5,i+1)

plt.tight_layout()

plt.imshow(example_data[i][0], cmap='gray', interpolation='none')

plt.title("Ground Truth: {}".format(example_targets[i]))

plt.xticks([])

plt.yticks([])

plt.show()examples = iter(testloader)

example_data, example_targets = examples.next()

print("Example data size:", example_data.shape)

fig = plt.figure(figsize=(10,4))

for i in range(10):

plt.subplot(2,5,i+1)

plt.tight_layout()

plt.imshow(example_data[i][0], cmap='gray', interpolation='none')

plt.title("Ground Truth: {}".format(example_targets[i]))

plt.xticks([])

plt.yticks([])

plt.show()

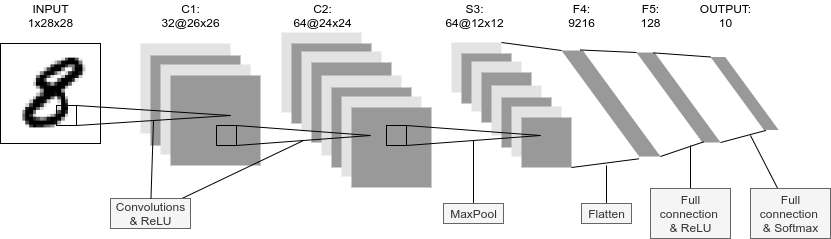

次に, CNN のモデルを定義する.

python

model = Model()

model.to("cuda") # load to GPUmodel = Model()

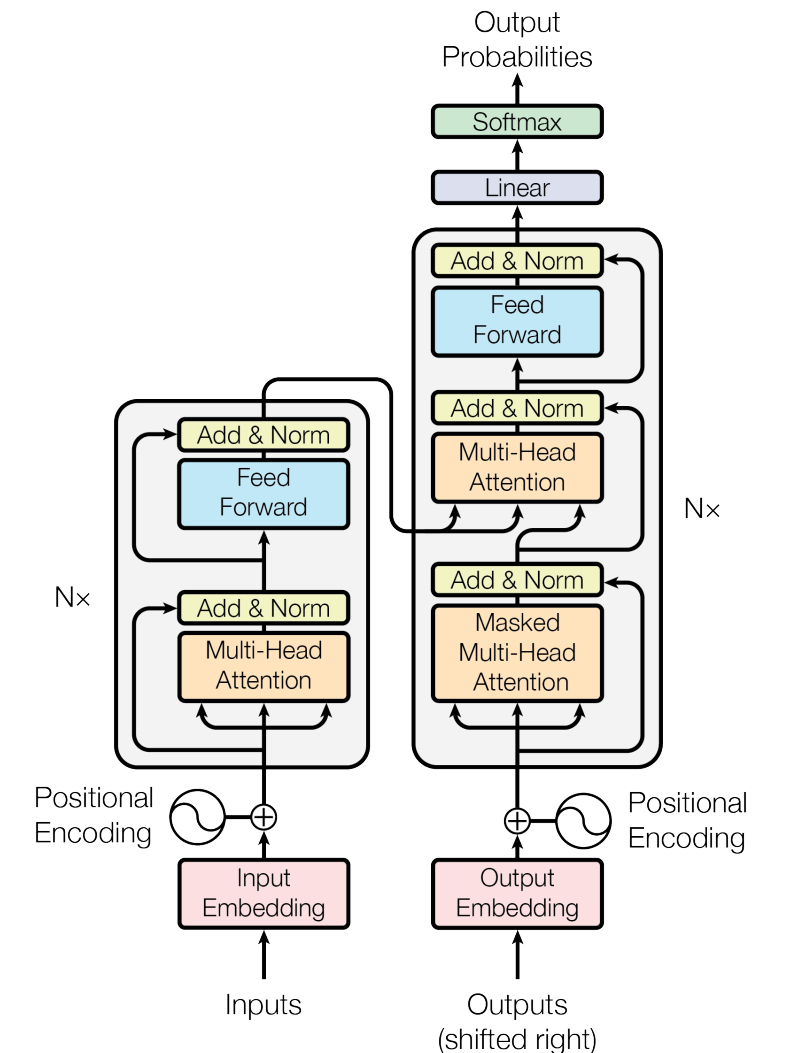

model.to("cuda") # load to GPU今回使う Model は simple_mnist.py の中で定義されている. このモデルは,figure_title に示したような,2層の畳み込み層と 2 層の全結合層からなるネットワークである. 出力層 (output layer) には Softmax 関数を使用し,損失関数 (Loss function) には 負の対数尤度関数 (Negative log likelyhood; NLL) を使用している.

続いて, CNN のパラメータを更新する最適化アルゴリズムを定義する. ここでは, 確率的勾配降下法 (Stochastic Gradient Descent; SGD) を使用している.

python

optimizer = optim.SGD(model.parameters(), lr=0.01, momentum=0.5)optimizer = optim.SGD(model.parameters(), lr=0.01, momentum=0.5)これで,準備が整った. CNN の学習ループを開始しよう!

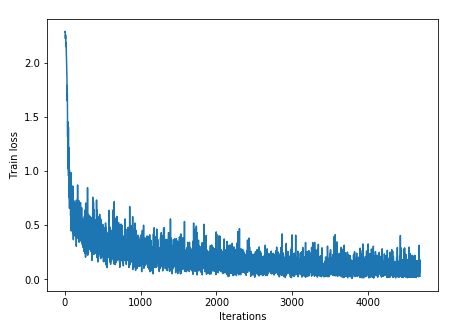

python

train_losses = []

for epoch in range(5):

losses = train(model, trainloader, optimizer, epoch)

train_losses = train_losses + losses

test_loss, test_accuracy = evaluate(model, testloader)

print(f"\nTest set: Average loss: {test_loss:.4f}, Accuracy: {test_accuracy:.1f}%\n")

plt.figure(figsize=(7,5))

plt.plot(train_losses)

plt.xlabel("Iterations")

plt.ylabel("Train loss")

plt.show()train_losses = []

for epoch in range(5):

losses = train(model, trainloader, optimizer, epoch)

train_losses = train_losses + losses

test_loss, test_accuracy = evaluate(model, testloader)

print(f"\nTest set: Average loss: {test_loss:.4f}, Accuracy: {test_accuracy:.1f}%\n")

plt.figure(figsize=(7,5))

plt.plot(train_losses)

plt.xlabel("Iterations")

plt.ylabel("Train loss")

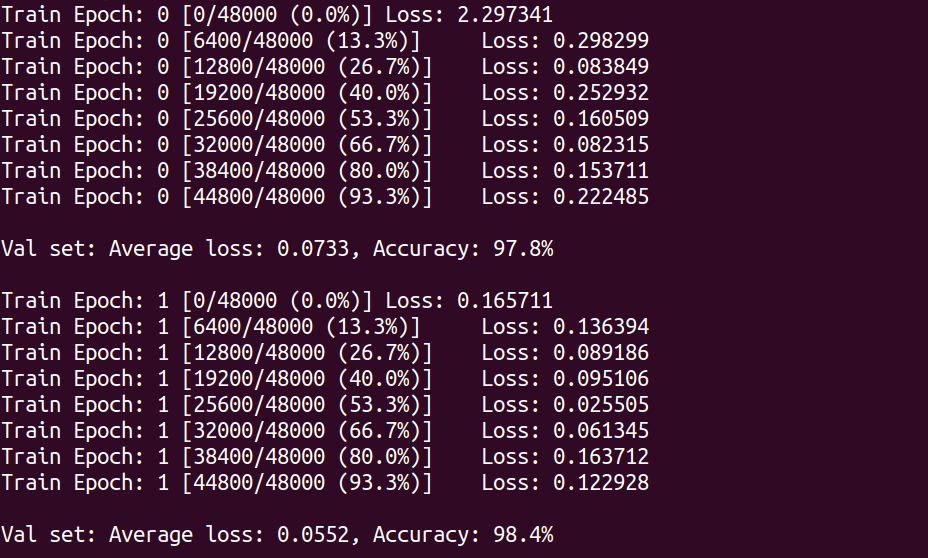

plt.show()ここでは 5 エポック分の学習を行っている. GPU を使えば,これくらいの計算であれば 1 分程度で完了するだろう.

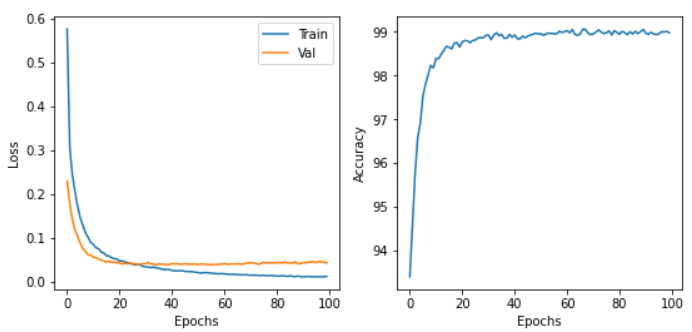

出力として, figure_title のようなプロットが得られるはずである. イテレーションを重ねるにつれて,損失関数 (Loss function) の値が減少している (=精度が向上している) ことがわかる.

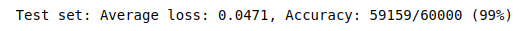

出力にはテキスト形式で各エポック終了後のテストデータに対する精度も表示されている. 最終的には 98% 以上の極めて高い精度を実現できていることが確認できるだろう (figure_title).

学習した CNN の推論結果を可視化してみよう. 次のコードを実行することで, figure_title のような出力が得られるだろう. この図で,下段右から二番目は,"1"に近い見た目をしているが,きちんと"9"と推論できている. なかなか賢い CNN を作り出すことができたようだ!

python

model.eval()

with torch.no_grad():

output = model(example_data.to("cuda"))

fig = plt.figure(figsize=(10,4))

for i in range(10):

plt.subplot(2,5,i+1)

plt.tight_layout()

plt.imshow(example_data[i][0], cmap='gray', interpolation='none')

plt.title("Prediction: {}".format(output.data.max(1, keepdim=True)[1][i].item()))

plt.xticks([])

plt.yticks([])

plt.show()model.eval()

with torch.no_grad():

output = model(example_data.to("cuda"))

fig = plt.figure(figsize=(10,4))

for i in range(10):

plt.subplot(2,5,i+1)

plt.tight_layout()

plt.imshow(example_data[i][0], cmap='gray', interpolation='none')

plt.title("Prediction: {}".format(output.data.max(1, keepdim=True)[1][i].item()))

plt.xticks([])

plt.yticks([])

plt.show()

最後に,学習したニューラルネットワークのパラメータを mnist_cnn.pt というファイル名で保存しておこう. これで,将来いつでも今回学習したモデルを再現し,別の実験に使用することができる.

python

torch.save(model.state_dict(), "mnist_cnn.pt")torch.save(model.state_dict(), "mnist_cnn.pt")以上が, AWS クラウドの仮想サーバーを立ち上げ,最初のディープラーニングの計算を行う一連の流れである. MNIST 文字認識のタスクを行うニューラルネットを,クラウド上の GPU を使って高速に学習させ,現実的な問題を一つ解くことができたのである. 興味のある読者は,今回のハンズオンを雛形に,自分の所望の計算を走らせてみるとよいだろう.

スタックの削除

これにて,ハンズオン第二回の内容はすべて説明した. クラウドの利用料金を最小化するため,使い終わった EC2 インスタンスはすぐさま削除しよう.

ハンズオン第一回と同様に, AWS の CloudFormation コンソールか, AWS CLI により削除を実行する (詳細は スタックを削除 参照).

sh

$ cdk destroy$ cdk destroyスタックの削除は各自で必ず行うこと! 行わなかった場合,EC2 インスタンスの料金が発生し続けることになる! g4dn.xlarge は $0.71 / hour の料金設定なので,一日起動しつづけると約$17 の請求が発生することになる!

AWS のバジェットアラート

AWS の初心者が (あるいは経験者も) しばしば陥る失敗が,インスタンスの停止忘れなどで無駄なリソースがクラウドで放置されてしまい,巨大な額の請求が届く,というミスだ. 特に,開発を行っている間はこのような事態は起こりうるものだと思って,備えておかなければならない. このような事態を未然に防ぐため, AWS Budgets という機能が無料で提供されている. AWS Budgets を利用することで,月の利用金額がある閾値を超えた場合にユーザーにメールが送信される,などのアラートを設定することができる. 詳細な手順は AWS の公式ブログ "Getting Started with AWS Budgets" を参照のこと. 本書の読者も,ぜひこのタイミングでアラートを設定しておくことを推奨する.

Docker 入門

ここまでの章で扱ってきたハンズオンでは,単一のサーバーを立ち上げ,それに SSH でログインをして,コマンドを叩くことで計算を行ってきた. いわば,パーソナルコンピュータの延長のような形でクラウドを使ってきたわけである. このような,インターネットのどこからでもアクセスできるパーソナルコンピュータとしてのクラウドという使い方も,もちろん便利であるし,いろいろな応用の可能性がある. しかし,これだけではクラウドの本当の価値は十分に発揮されていないと言うべきだろう. クラウド概論 で述べたように,現代的なクラウドの一番の強みは自由に計算機の規模を拡大できることにある. すなわち,多数のサーバーを同時に起動し,複数のジョブを分散並列的に実行させることで大量のデータを処理してこそ,クラウドの本領が発揮されるのである.

本章からはじまる 3 章分 (Docker 入門, Hands-on #3: AWS で自動質問回答ボットを走らせる, Hands-on #4: AWS Batch を使って機械学習のハイパーパラメータサーチを並列化する) を使って,クラウドを利用することでどのように大規模な計算システムを構築しビッグデータの解析に立ち向かうのか,その片鱗をお見せしたい. とくに,前章で扱った深層学習をどのようにビッグデータに適用していくかという点に焦点を絞って議論していきたい. そのための前準備として,本章では Docker とよばれる計算機環境の仮想化ソフトウェアを紹介する (figure_title). 現代のクラウドは Docker なしには成り立たないといっても過言ではないだろう. クラウドに限らず,ローカルで行う計算処理にも Docker は大変便利である. AWS からは少し話が離れるが,しっかりと理解して前に進んでもらいたい.

機械学習の大規模化

先ほどから"計算システムの大規模化"と繰り返し唱えているが,それは具体的にはどのようなものを指しているのか? ここでは大規模データを処理するための計算機システムを,機械学習を例にとって見てみよう.

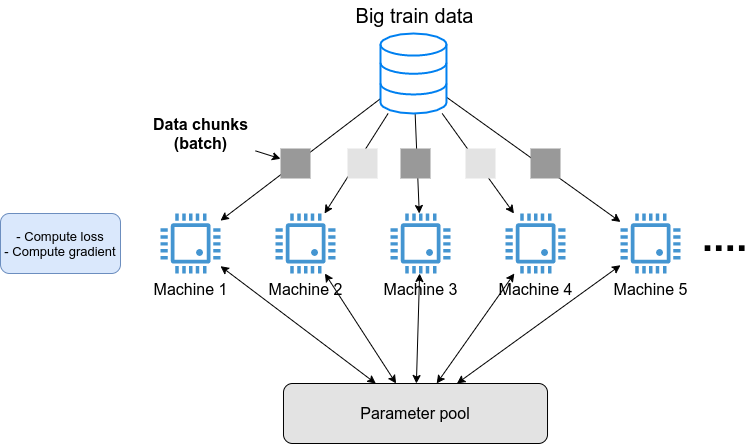

クラウドで行う科学計算・機械学習 で紹介した GPT-3 のような,超巨大な数のパラメータを有する深層学習モデルを学習させたいとしよう. そのような計算を行いたい場合,一つのサーバーでは計算力が到底足りない. したがって,典型的には figure_title に示すような計算システムの設計がなされる. すなわち,大量の教師データを小さなチャンクとして複数のマシンに分散し,並列的にニューラルネットのパラメータを最適化していくという構造である.

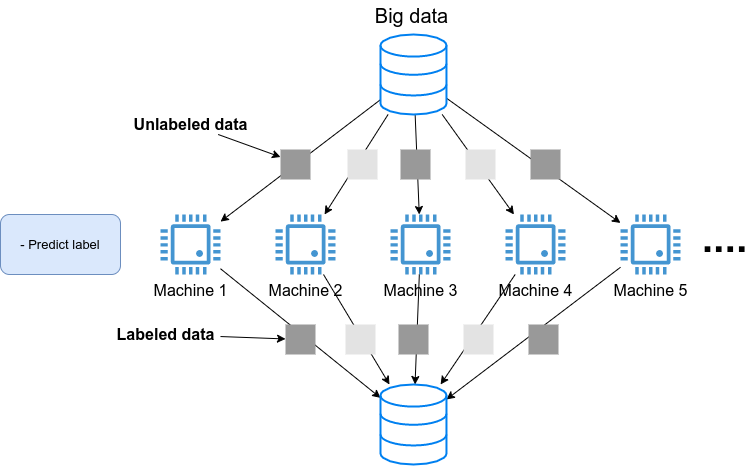

あるいは,学習済みのモデルを大量のデータに適用し,解析を行いたいとしよう. たとえば, SNS のプラットフォームで大量の画像が与えられて,それぞれの写真に何が写っているのかをラベルづけする,などのアプリケーションを想定できる. そのような場合は, figure_title のようなアーキテクチャが考えられるだろう. すなわち,大量のデータを複数のマシンで分割し,それぞれのマシンで推論の計算を行うというような構造である.

このような複数の計算機を同時に走らせるようなアプリケーションをクラウド上で実現するには,どのようにすればよいのだろうか?

重要なポイントとして, figure_title や figure_title で起動している複数のマシンは,基本的に全く同一の OS・計算環境を有している点である. ここで,個人のコンピュータで行うようなインストールの操作を,各マシンで行うこともできるが,それは大変な手間であるし,メンテナンスも面倒だろう. すなわち,大規模な計算システムを構築するには,簡単に計算環境を複製できるような仕組みが必要であるということがわかる.

そのような目的を実現するために使われるのが, Docker とよばれるソフトウェアである.

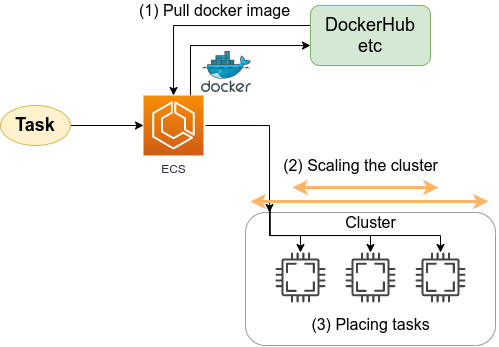

Docker とは

Docker とは, コンテナ (Container) とよばれる仮想環境下で,ホスト OS とは独立した別の計算環境を走らせるためのソフトウェアである. Docker を使うことで, OS を含めたすべてのプログラムをコンパクトにパッケージングすることが可能になる (パッケージされた一つの計算環境のことを **イメージ (Image)**とよぶ). Docker を使うことで,クラウドのサーバー上に瞬時に計算環境を複製することが可能になり, figure_title で見たような複数の計算機を同時に走らせるためのシステムが実現できる.

Docker は 2013 年に Solomon Hykes らを中心に開発され,それ以降爆発的に普及し,クラウドコンピューティングだけでなく,機械学習・科学計算の文脈などでも欠かすことのできないソフトウェアとなった. Docker はエンタープライズ向けの製品を除き無料で使用することができ,コアの部分は オープンソースプロジェクト として公開されている. Docker は Linux, Windows, Mac いずれの OS でも提供されている. 概念としては, Docker は仮想マシン (Virtual machine; VM) にとても近い. ここでは, VM との対比をしながら,Docker とはなにかを簡単に説明しよう.

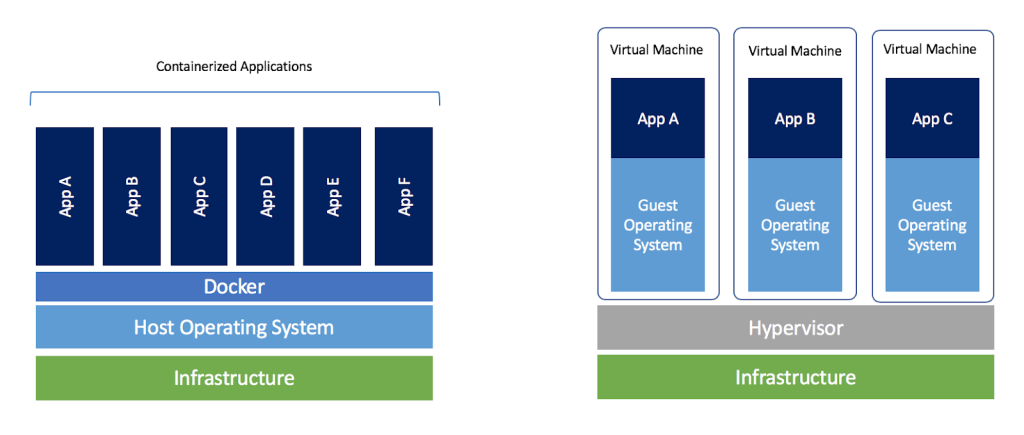

仮想マシン (VM) とは,ホストとなるマシンの上に,仮想化された OS を走らせる技術である (figure_title). VM には ハイパーバイザー (Hypervisor) とよばれるレイヤーが存在する. Hypervisor はまず,物理的な計算機リソース (CPU, RAM, network など) を分割し,仮想化する. たとえば, ホストマシンに物理的な CPU が 4 コアあるとして,ハイパーバイザーはそれを (2,2) 個の組に仮想的に分割することができる. VM 上で起動する OS には,ハイパーバイザーによって仮想化されたハードウェアが割り当てられる. VM 上で起動する OS は基本的に完全に独立であり,たとえば OS-A は OS-B に割り当てられた CPU やメモリー領域にアクセスすることはできない (これを isolation とよぶ). VM を作成するための有名なソフトウェアとしては, VMware, VirtualBox, Xen などがある. また,これまで触ってきた EC2 も,基本的に VM 技術を使うことで所望のスペックをもった仮想マシンがユーザーに提示される.

Docker も, VM と同様に,仮想化された OS をホストの OS 上に走らせるための技術である. VM に対し, Docker ではハードウェアレベルの仮想化は行われておらず,すべての仮想化はソフトウェアレベルで実現されている (figure_title). Docker で走る仮想 OS は,多くの部分をホストの OS に依存しており,結果として非常にコンパクトである. その結果, Docker で仮想 OS を起動するために要する時間は, VM に比べて圧倒的に早い. また, パッケージ化された環境 (=イメージ) のサイズも完全な OS に比べ圧倒的に小さくなるので,ネットワークを通じたやり取りが非常に高速化される点も重要である 加えて, VM のいくつかの実装では,メタル (仮想化マシンに対して,物理的なハードウェア上で直接起動する場合のこと) と比べ,ハイパーバイザーレイヤーでのオーバーヘッドなどにより性能が低下することが知られているが, Docker ではメタルとほぼ同様の性能を引き出すことができるとされている.

その他, VM との相違点などはたくさんあるのだが,ここではこれ以上詳細には立ち入らない. 大事なのは, Docker とはとてもコンパクトかつハイパフォーマンスな仮想計算環境を作るツールである,という点である. その手軽さゆえに,2013 年の登場以降,クラウドシステムでの利用が急速に増加し,現代のクラウドでは欠くことのできない中心的な技術になっている.

職業的プログラマーにとっての"三種の神器"とはなんだろうか? 多様な意見があると思うが,筆者は Git, Vim そして Docker を挙げたい.

Git は多くの読者がご存じの通り,コードの変更を追跡するためのシステムである. Linux の作成者である Linus Torvalds によって 2005 年に誕生した. チームでの開発を進める際には欠かせないツールだ.

Vim は 1991 年から 30 年以上の間プログラマーたちに愛されてきたテキストエディターである. Stackoverflow が行った 2019 年のアンケート によると,開発環境の部門で 5 位の人気を獲得している. たくさんのショートカットと様々なカスタム設定が提供されているので,初見の人にはなかなかハードルが高いが,一度マスターすれば他のモダンなエディターや統合開発環境に負けない,あるいはそれ以上の開発体験を実現することができる.

これらの十年以上の歴史あるツールに並んで,第三番目の三種の神器として挙げたいのが Docker だ. Docker はプログラマーの開発のワークフローを一変させた. たとえば,プロジェクトごとに Docker イメージを作成することで,どの OS・コンピュータ でも全く同じ計算環境で開発・テストを実行することができるようになった. また, DevOps や CI / CD (Continuous Integration / Continuous Deployment) といった最近の開発ワークフローも Docker のようなコンテナ技術の存在に立脚している. さらにはサーバーレスコンピューティング (Serverless architecture) といった概念も,コンテナ技術の生んだ大きな技術革新といえる.

あなたにとっての三種の神器はなんだろうか? また,これからの未来ではどんな新しいツールが三種の神器としてプログラマーのワークフローを革新していくだろうか?

Docker チュートリアル

Docker とはなにかを理解するためには,実際に触って動かしてみるのが一番有効な手立てである. ここでは, Docker の簡単なチュートリアルを行っていく.

Docker のインストールについては, Docker のインストール および 公式のドキュメンテーション を参照してもらいたい. Docker のインストールが完了している前提で,以下は話を進めるものとする.

Docker 用語集

Docker を使い始めるに当たり,最初に主要な用語を解説しよう. 次のパラグラフで太字で強調された用語を頭に入れた上で,続くチュートリアルに取り組んでいただきたい.

Docker を起動する際の大まかなステップを示したのが figure_title である. パッケージされた一つの計算環境のことを **イメージ (Image)**とよぶ. イメージは, Docker Hub などのリポジトリで配布されているものをダウンロードするか,自分でカスタムのイメージを作成することも可能である. イメージを作成するための”レシピ”を記述したファイルが Dockerfile である. Dockerfile からイメージを作成する操作を build とよぶ. イメージがホストマシンのメモリにロードされ,起動状態にある計算環境のことを コンテナ (Container) とよぶ. Container を起動するために使用されるコマンドが run である.

イメージをダウンロード

パッケージ化された Docker の仮想環境 (= イメージ (Image)) は, Docker Hub からダウンロードできる. Docker Hub には,個人や企業・団体が作成した Docker イメージが集められており, GitHub などと同じ感覚で,オープンな形で公開されている.

たとえば, Ubuntu のイメージは Ubuntu の公式リポジトリ で公開されており, pull コマンドを使うことでローカルにダウンロードすることができる.

sh

$ docker pull ubuntu:18.04$ docker pull ubuntu:18.04ここで,イメージ名の : (コロン) 以降に続く文字列を タグ (tag) と呼び,主にバージョンを指定するなどの目的で使われる.

pull コマンドはデフォルトでは Docker Hub でイメージを検索し,ダウンロードを行う. Docker イメージを公開するためのデータベース (レジストリ (registry) とよぶ) は Docker Hub だけではなく,たとえば GitLab や GitHub は独自のレジストリ機能を提供しているし,個人のサーバーでレジストリを立ち上げることも可能である. Docker Hub 以外のレジストリから pull するには, myregistry.local:5000/testing/test-image のように,イメージ名の先頭につける形でレジストリのアドレス (さらにオプションとしてポート番号) を指定する.

コンテナを起動

Pull してきたイメージを起動するには, run コマンドを使う.

sh

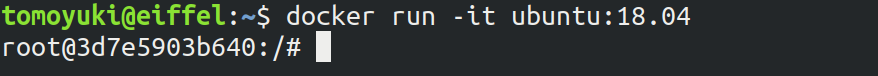

$ docker run -it ubuntu:18.04$ docker run -it ubuntu:18.04ここで, -it とは,インタラクティブな shell のセッションを開始するために必要なオプションである.

このコマンドを実行すると,仮想化された Ubuntu が起動され,コマンドラインからコマンドが打ち込めるようになる (figure_title). このように起動状態にある計算環境 (ランタイム) のことを Container (コンテナ) とよぶ.

ここで使用した ubuntu:18.04 のイメージは,空の Ubuntu OS だが,すでにプログラムがインストール済みのものもある. これは, Hands-on #2: AWS でディープラーニングを実践 でみた DLAMI と概念として似ている. たとえば, PyTorch がインストール済みのイメージは PyTorch 公式の Docker Hub リポジトリ で公開されている.

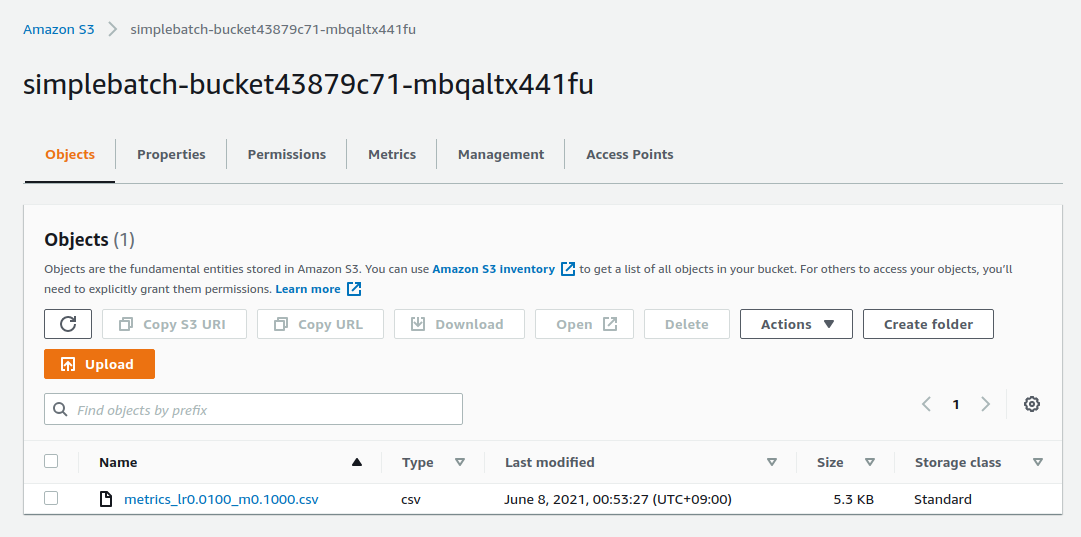

これを起動してみよう.